仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

论文题目:COMPOSITIONALENTAILMENTLEARNINGFORHYPERBOLICVISION-LANGUAGEMODELS

论文地址:https ://arxiv.org/pdf/2410.06912

本文首次提出了一种新的学习范式,即“组合蕴含学习”,用于在双曲空间中学习视觉-语言模型的表示。该方法不仅考虑了图像和文本的整体对齐,还利用了图像中的局部对象(图像框)和文本中的局部描述(文本框)之间的语义层次关系。

通过在双曲空间中引入“蕴含锥”(entailmentcones),模型能够强制执行图像和文本之间的语义层次关系,使得更一般的概念(如图像框和文本框)更接近空间的原点,而更具体的概念(如完整图像和完整文本)则位于空间的边界。

HyCoCLIP是一个新的对比学习方法,它在双曲空间中同时考虑了视觉和语言数据的组合顺序和层次结构。

本文提出了一种名为HyperbolicCompositionalCLIP(HyCoCLIP)的方法,用于在双曲空间中学习视觉-语言表示。该方法的核心在于利用图像和文本的组合语义信息,通过层次化的对比学习和蕴含学习目标,优化图像、图像框、文本和文本框之间的语义对齐关系。具体而言,HyCoCLIP将图像和文本嵌入到双曲空间中,利用双曲空间的指数增长特性来更好地表示视觉和语言数据的层次结构。在双曲空间中,更一般的概念(如图像框和文本框)被嵌入到空间的原点附近,而更具体的概念(如完整图像和完整文本)则被嵌入到空间的边界。这种层次化的嵌入方式使得模型能够更好地捕捉视觉和语言数据的语义层次关系。

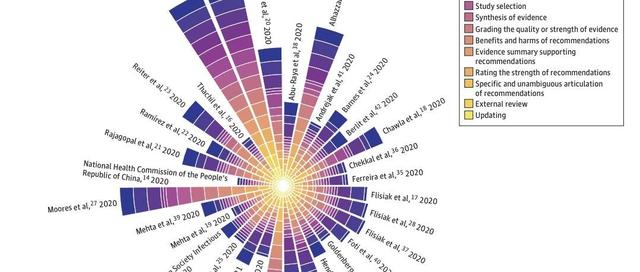

(b)描述了图像和文本对的视觉-语义层次关系。完整图像(I)和完整文本(T)为局部图像框(Ibox)和局部文本框(Tbox)提供了更具体的上下文。

(c)展示了在双曲空间中如何通过蕴含锥(entailmentcones)强制执行这种具体-一般的关系。具体概念(如T)的外角ϕ被推入一般概念(如Tbox)的开口阈值ηω内。

本图展示了展示了HyCoCLIP的整体架构。图像和文本框从图像-文本数据集中提取后,通过编码器模块嵌入到双曲潜在空间中。HyCoCLIP通过将更广泛的概念(如文本框)嵌入到空间中心,更细粒度的概念(如完整图像)嵌入到边界,并利用蕴含锥为学习的潜在空间提供可解释的结构。

本图展示了零样本图像分类任务的性能比较。表中对比了CLIP和MERU在RedCaps数据集上训练的结果,以及HyCoCLIP在GRIT数据集上训练的结果。结果显示,HyCoCLIP在多个数据集上显著优于CLIP和MERU,尤其是在ImageNet数据集上,HyCoCLIP的准确率达到了45.8%,远高于CLIP的11.4%和MERU的11.4%。此外,在CIFAR-10数据集上,HyCoCLIP的准确率达到了88.8%,表明其在细粒度分类任务中也表现出色。这些结果表明HyCoCLIP在零样本分类任务中具有更强的泛化能力和语义对齐能力,尤其是在处理大规模和复杂数据集时。

–END–

关注“学姐带你玩AI”公众号,回复“CLIP创新”

领取CLIP结合创新方案合集+开源代码

往期精彩阅读

👉kaggle比赛baseline合集

👉经典论文推荐合集

👉人工智能必读书籍

👉本专科硕博学习经验

评论区留言参与讨论嗷