SQL-R1:通过强化学习训练自然语言到 SQL 的推理模型

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

使用自然语言而非复杂的SQL语法来查询数据库的能力一直是数据库可访问性的一个目标。自然语言到SQL(NL2SQL)系统旨在弥合这一差距,允许非技术用户在无需专业编程知识的情况下从数据库中检索信息。然而,当前的方法在处理复杂的数据库模式、多表连接和嵌套查询时面临着重大挑战。

https ://www.arxiv.org/pdf/2504.08600

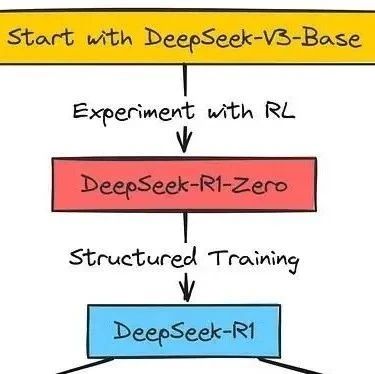

如上图所示,传统的监督微调(SFT)方法直接生成SQL查询而没有明确的推理,而强化学习方法则包含一个推理过程并接收来自数据库执行结果的反馈。

本文介绍了一种名为SQL-R1的新型自然语言到SQL推理模型,该模型使用强化学习技术进行训练。与以前主要依赖于监督微调的方法不同,SQL-R1利用强化学习来优化其在SQL生成过程中的决策,从而产生更准确的查询,并在复杂场景中更好地泛化。

当前的NL2SQL系统主要依赖于大型语言模型(LLM)的监督微调(SFT)。虽然这些方法已经显示出希望,但它们存在以下几个局限性:

:SFT模型通常难以泛化到训练期间未见过的新数据库模式或查询模式。

:大多数模型直接生成SQL,而没有明确的推理步骤,因此很难追溯它们是如何得出特定查询的。

:训练数据中的错误会传播到模型,导致持续的错误。

:SFT缺乏将执行结果作为反馈纳入的机制,这对于改进SQL生成至关重要。

当处理涉及多个表和关系的复杂数据库模式时,这些限制尤其成问题。许多当前模型产生语法正确但语义不正确的查询,这些查询不能准确地表达用户的意图。

SQL-R1通过采用强化学习(RL)方法来解决这些局限性。主要创新包括:

:SQL-R1经过训练,可以在生成最终SQL查询之前生成显式的逐步推理,从而增强可解释性。

:该模型结合了对数据库执行查询的反馈,从而针对产生正确结果的查询进行优化。

:一种专门为NL2SQL任务量身定制的RL算法,它具有内存效率,并且允许清晰的奖励定义。

:一种利用合成数据来克服现实世界NL2SQL训练示例稀缺性的战略方法。

与GPT-4等更大的替代方案相比,该方法使SQL-R1能够使用相对较小的7B参数模型来实现具有竞争力的性能。

SQL-R1构建于Qwen2.5-Coder-7B-Instruct基础模型之上,然后通过监督学习和强化学习相结合的方式进行微调。训练过程主要包括两个阶段:

:初始的监督式微调,用于建立基本的NL2SQL能力,使用SynSQL-200K数据集(SynSQL-2.5M的一个子集)。

:使用GRPO算法和精心设计的奖励函数进行进一步优化,SynSQL-Complex-5K数据集侧重于更具挑战性的查询。

SQL-R1架构旨在处理自然语言查询以及数据库模式信息,然后生成详细的推理过程,随后生成相应的SQL查询。这种结构能够提供更好的可解释性,并为模型的决策过程提供一个窗口。

SQL-R1的训练过程涉及几个关键步骤:

基础模型选择:作者从Qwen2.5-Coder-7B-Instruct开始,选择它的原因是其编程能力和合理的参数数量。

冷启动策略:探索了两种SFT方法:

:仅教授SQL生成

:同时教授推理过程和SQL生成

强化学习:应用GRPO算法,具有以下特点:

内存高效的训练

清晰的奖励目标定义

能够处理NL2SQL任务的特定要求

候选选择:在推理过程中,模型生成多个带有推理过程的SQL候选,然后使用自洽性投票选择最佳候选。

这种渐进式的训练方法使得模型能够开发越来越复杂的NL2SQL能力,同时通过显式推理保持可解释性。

SQL-R1成功的关键要素是其精心设计的奖励函数,该函数由四个组成部分组成:

格式奖励(Rf):鼓励模型遵循预期的输出格式,推理过程包含在标签中,SQL包含在标签中。

执行奖励(Re):验证生成的SQL在语法上是否正确,并且可以在没有错误的情况下针对数据库执行。

结果奖励(Rr):将生成的SQL的结果与真实结果进行比较,以确保语义正确性。

长度奖励(Rl):平衡推理过程的全面性和简洁性,防止过于冗长或过于简短的解释。

总奖励计算公式如下:

其中w_f、w_e、w_r和w_l是每个组成部分的权重因子。

消融研究证实,每个组成部分都有助于模型的性能,其中执行奖励和结果奖励对于生成准确的SQL查询尤其重要。

该论文强调了数据工程对于成功的基于RL的NL2SQL模型的重要性。关键方面包括:

SynSQL-2.5M数据集:一个用于训练的大型合成数据集,包括:

用于SFT的SynSQL-200K子集

专注于用于RL的复杂查询的SynSQL-Complex-5K子集

合成数据生成:精心设计以覆盖不同的SQL模式、数据库模式和查询复杂性。

数据过滤:根据复杂性和与目标领域的关联性选择适当的训练样本。

该方法解决了真实世界NL2SQL训练数据稀缺的问题,同时确保模型能够处理各种查询模式和数据库结构。

SQL-R1在标准NL2SQL基准测试中表现出令人印象深刻的性能:

Spider数据集:

在开发集上的执行准确率为87.6%

在测试集上的执行准确率为88.7%

BIRD数据集:

在开发集上的执行准确率为66.6%

如上图所示,SQL-R1与更大的模型相比,实现了具有竞争力的性能。仅使用7B参数,它的性能优于许多更大的模型,包括一些具有32B或更多参数的模型。与像GPT-4(1000B+参数)和GPT-4o这样的闭源模型相比,这种效率尤为显著。

消融研究进一步表明:

:适当的SFT初始化显着提高了RL性能。

:每个奖励组成部分都在引导模型生成正确的SQL方面发挥着有意义的作用。

:经过训练可以生成显式推理过程的模型比直接生成SQL的模型表现更好。

SQL-R1方法具有几个重要的实际意义:

可访问性:通过使用较小的模型实现具有竞争力的性能,SQL-R1使NL2SQL技术对于计算资源有限的组织来说更易于访问。

可解释性:显式推理过程提供了模型如何得出特定SQL查询的透明度,这对于金融、医疗保健和其他受监管行业中的高风险应用至关重要。

适应性:与仅使用SFT的模型相比,强化学习方法使模型能够更有效地适应新的数据库模式和查询模式。

成本效率:与像GPT-4这样的大型模型相比,7B参数计数显着降低了计算要求,而不会牺牲性能。

开源潜力:基于开源基础模型为更广泛的社区采用和改进开辟了可能性。

SQL-R1代表了NL2SQL技术的重大进步,它证明了强化学习可以有效地提高自然语言到SQL系统的推理和泛化能力。通过明确地训练模型生成详细的推理过程,并使用包含数据库执行反馈的综合奖励函数,SQL-R1以相对较小的模型尺寸实现了具有竞争力的性能。

SQL-R1的成功为未来的研究开辟了几个有希望的方向:

探索NL2SQL任务中GRPO之外的其他RL算法

增强奖励函数以解决SQL生成中更细微的方面

开发更复杂的合成数据生成技术

扩展该方法以处理更复杂的数据库模式和查询模式

纳入用户反馈以不断提高模型性能

SQL-R1所展示的强化学习、显式推理和高效模型扩展的结合,为开发更强大、可解释且易于访问的NL2SQL系统提供了一个有价值的模板,有可能使各个领域的非技术用户都能轻松访问数据库。