16.8万篇论文揭秘:LLM如何血洗学术界,中美暗战谁赢了?

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

过去6年,AI领域最火的词非“大语言模型”(LLM)莫属。从ChatGPT到文心一言,这些模型不仅能写诗、编程,甚至能帮科学家搞研究。但LLM的影响力到底有多大?这篇论文给出了答案——研究者们分析了77个顶级计算机会议的16.8万篇论文,从中揪出1.6万篇LLM相关研究,挖出了LLM如何“血洗”学术界、工业界的全过程。

论文:Analyzing16,193LLMPapersforFunandProfits链接:https ://arxiv.org/pdf/2504.08619

一句话总结:LLM不仅是技术革命,更是科研圈的“流量密码”。

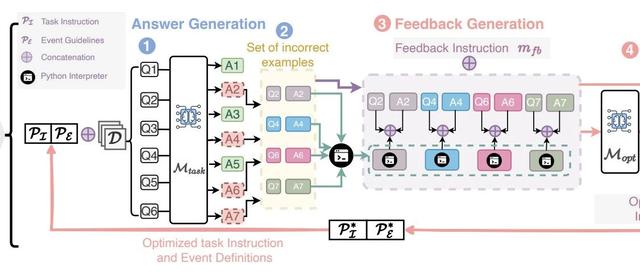

为了从海量论文中精准识别LLM相关研究,作者们玩了一把“以毒攻毒”——用大模型Llama3自动判断论文是否和LLM有关!传统方法依赖关键词匹配,但LLM发展太快,关键词根本追不上。于是他们让Llama3通读论文标题和摘要,直接“拍板”分类。

技术亮点:

主题建模:用另一个模型(INSTRUCTOR-XL)给论文摘要生成“语义指纹”,再聚类成50个主题,最后让Gemini给每个主题起名。

机构与国家分析:靠开源数据库+手动补全,甚至用AI统一机构名称(比如把“MIT”和“麻省理工”合并)。

论文提炼了10条关键结论,这里挑几个最劲爆的:

猛料1:NLP会议已成LLM“主战场”在NLP顶会上,超过60%的论文都在研究LLM,主题集中在模型优化、评估和落地应用。

猛料2:LLM跨界“打劫”其他领域CV顶会中,10%的论文开始搞多模态LLM;机器人会议(如ICRA)则忙着给机器人“装大脑”,让它们听懂人话。

猛料3:工业界早期称霸,学术界后来居上2019年,谷歌、微软等大厂垄断LLM研究;但到了2024年,清华、港科大等高校冲进Top10,甚至反超工业界!

工业界:靠算力、数据和烧钱,早期独占鳌头,代表作如GPT-3、BERT。

学术界:借助开源模型(如LLaMA)和校企合作,2024年强势逆袭。例如,清华的论文量直接冲上全球第一!

关键转折点:2022年后,开源社区爆发(比如Meta开源LLaMA),学术界终于不用“给大厂打工”,自己也能玩转LLM。

中美双雄:美国始终稳坐第一,中国紧追其后,两国合占半壁江山。

黑马选手:中国香港从2019年的第10名飙升至第4名,新加坡、韩国稳居前十。

研究方向差异:

美国:专注LLM应用和机器人;

中国:猛攻视觉-语言模型;

英国:偏爱医疗和翻译场景。

理论短板:目前LLM研究集中在工程落地,理论基础薄弱,谁能突破谁封神。

跨界融合:机器人、生物医学、教育等领域需求爆发,LLM的“跨界打劫”才刚刚开始。

伦理与安全:论文提到“社会影响”研究激增,未来如何防AI造假、防偏见,将是重中之重。

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦