啊?强大的Reasoning模型仍需好的prompt,性能暴增23%!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

过去人们认为,像ChatGPT这类“大脑发达”的LLM模型,只需简单指令就能完美执行任务。

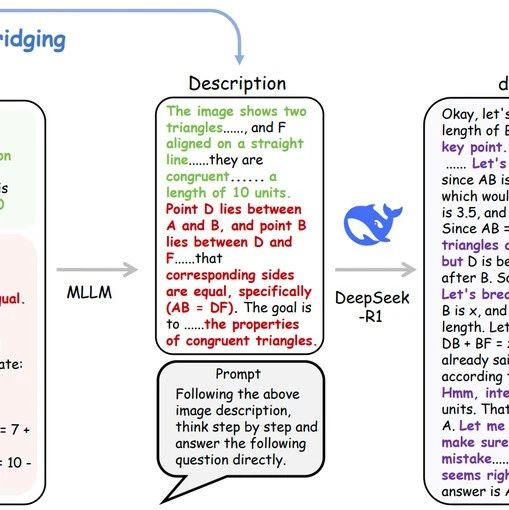

但这篇论文通过事件提取任务(例如从新闻中识别“公司破产”“法律诉讼”等事件)证明:即便是最先进的大型推理模型(LRM),也需要精心设计的“说明书”——即Prompt。实验数据显示,经过优化的提示词能让LRM性能提升高达23%!就像给学霸一本更清晰的习题解析,他们解题更快更准。

LLM(大语言模型):如GPT-4,擅长生成文本,但复杂推理能力有限。

LRM(大型推理模型):如论文中的DeepSeek-R1,专为逻辑推理训练,类似“理科尖子生”。

两者的核心区别在于:LRM能生成中间思考步骤(比如先拆解问题再解答),而LLM更依赖直觉反应。

论文采用了一种叫蒙特卡洛树搜索(MCTS)的算法,灵感来自围棋AI“AlphaGo”的策略:

试错:让LRM用当前提示词尝试解题

复盘:分析错误,生成改进建议

进化:迭代优化提示词,直到性能稳定

整个过程就像训练运动员:教练(优化器模型)观察运动员(任务模型)的表现,不断调整训练方案。

LRM也需要“外挂”即使是最强的DeepSeek-R1,优化后性能仍大幅提升。这说明:再聪明的模型,也需要人类引导方向。

LRM是“高效教练”当LRM担任提示词优化器时,生成的提示更简短精准。例如,它会添加规则:“去掉‘的’‘这个’等无关词,除非是专有名词”。

稳定性碾压传统模型LRM优化时只需2层搜索就能达到最佳效果,而传统模型需要5层。好比老司机找路,LRM一眼锁定捷径。

错误率直降优化后的提示减少了20%的“幻觉”和15%的指代错误。

别盲目相信“开箱即用”:再强的模型也需定制化提示。

让LRM当“优化顾问”:用它的推理能力反哺提示设计。

小样本也能逆袭:实验中仅用15条数据就实现显著提升,中小企业友好!

论文留下悬念:

长文本处理:当前实验仅针对10类事件,如何扩展?

全自动进化:能否让LRM完全自主优化,无需人类介入?

或许不久的将来,AI能像人类一样“反思—改进—突破”,开启真正的智能进化吧~

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦