仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

哈喽,我是cos大壮!~

今儿和大家聊聊结合随机森林和CNN,能够蹦出怎么样更加优秀的火花。

CNN的优势在于自动提取图像或时序数据中的局部特征与层次化语义信息。

随机森林则以其集成决策树的方式,具备对高维特征的鲁棒性和较强的非线性分类能力。

通过将CNN作为特征提取器,将深层次的抽象特征作为输入送入随机森林,可以充分利用CNN在特征学习方面的强大能力同时利用随机森林在防止过拟合、解释性强及集成学习中的稳健性,从而提高整体模型的泛化能力和稳定性。

集成学习的随机森林对噪声和异常值具有一定的容错性,能够减少单一模型(如CNN直接分类)可能遇到的过拟合问题。

在训练过程中,CNN可以学习出更具区分度的特征,而随机森林的随机采样和特征子集选择则可进一步提高模型对不同数据分布的适应性。

采用CNN提取特征后,随机森林的训练过程通常比全连接层或深度分类器的训练过程更为简单且高效。

这种分工方式可以在一定程度上降低调参的复杂性,避免单一模型在多层参数调优时可能遇到的梯度消失或局部最优问题。

CNN的核心操作是卷积运算,其数学公式为:

为输入图像或特征图;

为卷积核(滤波器);

为偏置项;

是卷积后在位置的输出。

该操作实现了局部感受野的特征提取,通过多个卷积核可以提取出不同层次的特征。

常用的激活函数为ReLU,其定义为:

该非线性变换能够引入非线性因素,使网络可以拟合复杂函数。

池化层用于降采样,减少计算量和参数数量。以最大池化为例,其操作为:

这里选取局部区域内的最大值,从而保留最显著的特征信息。

在经过一系列卷积和池化操作后,特征图会被展平,输入到全连接层进行最终的分类或回归。假设输入为向量,权重矩阵为,偏置为,则输出为:

为了优化网络参数,需要根据损失函数对各层参数进行求导。例如,对于卷积核:

利用链式法则,整个网络的梯度可逐层反传,并通过梯度下降法或其变种(如Adam、RMSprop)进行参数更新。

随机森林是一种集成学习方法,其基本单元为决策树。每棵决策树通过对特征进行分裂,将数据集划分成不同的叶子节点,然后根据叶节点中的多数类进行预测。

对于一个数据集,熵的定义为:

其中是数据集中第类的概率。当对某个特征进行划分时,信息增益定义为:

其中表示特征等于某个取值时的数据子集。

另一种常用的分裂标准为Gini不纯度:

决策树在每次划分时会选择使得熵或Gini值下降最多的特征和切分点。

随机森林通过引入以下两个随机性来构建多棵树:

Bootstrap采样:对原始数据集进行有放回的抽样,生成不同的子数据集。

随机特征选择:在每次分裂时,从所有特征中随机选择一个子集作为候选,从中选出最佳划分。

最终,每棵树独立生成预测结果,随机森林采用投票(分类问题)或平均(回归问题)的方式综合各树的预测。

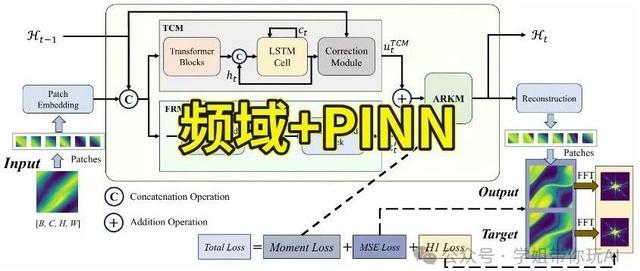

第一阶段(特征提取):

利用预训练或专门训练的CNN对输入数据(如图像)进行处理,提取出高层次的抽象特征。得到的特征向量可以看作对原始数据的一种降维和高效编码。

第二阶段(分类器):

将CNN提取的特征向量作为输入,送入随机森林进行分类。随机森林利用其集成学习机制,对这些高维特征进行处理,输出最终的类别标签。

将CNN与随机森林结合是一种利用两者优势互补的混合架构:CNN负责自动提取数据中潜在的、层次化的特征,而随机森林则通过集成多个决策树提供更鲁棒和易解释的分类结果。

在实际应用中,深度学习模型(如CNN)在特征提取方面有着出色的表现,但直接采用全连接层进行分类时,往往面临过拟合和调参复杂等问题。

随机森林作为一种集成学习方法,在防止过拟合、解释性以及训练速度上具有明显优势。将两者相结合,即利用CNN自动学习图像的深层次特征,再使用随机森林进行分类,不仅能充分利用CNN的特征表达能力,还能借助随机森林的鲁棒性提高整体模型的泛化性能。

这里,咱们采用CIFAR-10数据集,数据集包含10个类别的彩色图像。

整体流程分为两个阶段:

特征提取阶段:构建一个轻量级CNN模型,提取数据集中的特征。

分类阶段:使用sklearn中的RandomForestClassifier对CNN提取的特征进行训练和预测。

通过这种架构设计,既利用了CNN的自动特征学习能力,又发挥了随机森林在集成分类上的优势。

图1:展示训练过程中CNN模型的损失变化情况,验证模型收敛性。

图2:展示每个epoch在验证集上的准确率,帮助观察模型性能提升趋势。

图3:以热力图方式展示随机森林在测试集上的分类情况,直观反映各类别混淆情况。

图4:展示模型对随机选取的一个样本的预测概率分布,反映模型对该样本分类信心。

这里,咱们将CNN与随机森林结合的主要优势在于利用CNN自动提取深层特征,再利用随机森林进行鲁棒分类。

针对整个模型和训练流程,咱们再来聊聊CNN和随机森林:

可尝试增加卷积层数、调整卷积核大小以及步长,以获得更加丰富的特征表示。

使用BatchNormalization层对每个卷积层输出进行归一化,能够有效缓解梯度消失问题,加快模型收敛。

在激活函数方面,可以尝试LeakyReLU或ELU等变种,以获得更好的非线性表达能力。

增加更多数据增强手段(例如随机旋转、颜色抖动、随机擦除等),可以提升模型对复杂数据场景下的泛化能力。

关键参数包括树的数量(n_estimators)、最大深度(max_depth)、最小样本分裂数(min_samples_split)等。

采用网格搜索或随机搜索对上述参数进行调参,确保在训练集和验证集上均表现稳定。

对于CNN提取的特征,可进行进一步的特征选择或降维(例如PCA),降低冗余信息,提高随机森林训练效率。

首先在CNN部分单独训练,通过调整网络结构和训练超参数,获得一个较好的特征提取模型。

记录训练损失和验证准确率,观察模型收敛情况。

可采用交叉验证或独立验证集来评估模型性能。

在特征提取效果较好后,提取训练集与测试集特征,并初步训练随机森林分类器。通过验证随机森林在测试集上的准确率以及混淆矩阵,评估整体模型的分类效果。

对随机森林部分进行超参数调优:

使用网格搜索(GridSearch)或贝叶斯优化(BayesianOptimization)对随机森林参数进行调参,寻找最优参数组合。

在调参过程中,关注每个类别的召回率和精确率,避免因某一类别样本不均衡而导致模型偏向性预测。

上述所有的内容,给大家分享了,如何利用CNN与随机森林相结合,实现高效、鲁棒的图像分类系统。

感觉有帮助的朋友可以收藏、点赞、转发起来!

推荐阅读

(点击标题可跳转阅读)

《机器学习100天》视频讲解

公众号历史文章精选

我的深度学习入门路线

重磅!

1700多页的《人工智能学习路线、干货分享全集》PDF文档

扫描下方二维码,添加我的微信,领取1700多页的《人工智能学习路线、干货分享全集》PDF文档(一定要备注:资料)。

长按扫码,申请入群

感谢你的分享,点赞,在看三连