仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

作者:曹宇https ://zhuanlan.zhihu.com/p/1892270905683575985

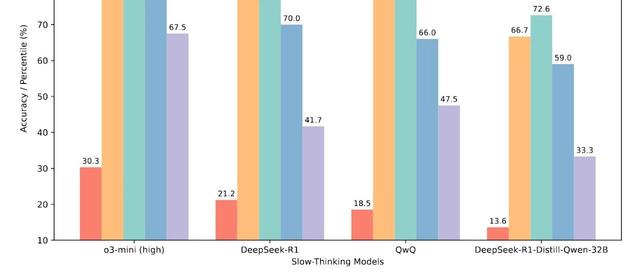

Reasoning模型最近不可谓不热闹,从DPSK-R1把大模型从业者从infra一直卷到产品开始,各家针对Reasoning所带来的范式冲击已经逐渐适应:

•Gemini2.5Pro直接把主线模型切换成了Reasoning模型

•QwQ32B超级小钢炮提供了甜点级的Reasoning底座

•Claude3.7则是推出了带思考模式的新版Reasoning选项

•DeepSeek这边的ReasoningRL持续scale的同时还开始研究起了通用领域的生成式RM

•Reasoning系列正主OpenAI看到Gemini2.5很不错准备加速掏出来fullo3和o4-mini了。

Reasoning模型和RL基本就是互为表里的关系,今天这篇文章主要会curate四个工作,以详细探究Reasoning模型对齐过程中的实际挑战并适当展望对应的策略。

这类模型相比于传统的RL对齐(RLHF,RLVF等)有什么最不一样的挑战呢?通过本篇文章,读者应该能够清晰地认识到以下两个方面:

•模型的ThinkingCoT及Answer监督难度更大,AlignmentFaking现象随着模型智力提升更为明显

•模型的RL监督信号获取更难,浅层Reward信号极易导致模型hacking,RM本身都可能需要Reasoner

我们看的第一个工作是A家的Reasoning模型的言不由衷现象:他并不总是说他所想的内容。来自于A家的AlignmentScienceTeam(Jan还在,Schulman已经润了),这个实验中算法同学聪明地设计了6种推理暗示,并观察模型的表现。

他们构建了成对的问题:一个标准多选题(无提示),和同一个问题但加入了指向特定答案的提示(有提示)。他们观察模型在两种情况下生成的ThinkingCoT和答案。当模型在无提示时回答非提示答案,但在有提示时回答了提示答案时,研究者就认为模型实际上使用了提示。

然后,他们检查这种情况下,模型在有提示问题的ThinkingCoT中是否明确承认了对提示的使用。他们测试了6种不同类型的提示(包括中性的和涉及不当行为的,如Sycophancy阿谀奉承,GraderHacking等)以及多个前沿的推理模型(如Claude3.7Sonnet,DeepSeekR1)和非推理模型。

这听起来确实有点绕,我们先来看一个例子,可能会更明白一点:

结果粗看起来还不错:Reasoning模型(R1和3.7都有更高的faithfulCoT比例),也就是言(CoT)行(Answer)一致。但这里面藏着两个隐患:

•(a)在更难的任务(GPQAvsMMLU)和涉及不当行为的提示(如GraderHacking,UnethicalInformation)上,CoT的忠实度更低。

•(b)不忠实的CoT反而比忠实的CoT更长、更复杂。3.7上不忠实的CoT平均长度2064±59,忠实的则为1439±54。R1上不忠实的长度6003±74,忠实的只有4737±79。(均为tokens)

然后自然而然地,既然Reasoning模型给了一个RL对齐的机会,如果我们用这个作为反馈信号去搞一把RL对齐会怎么样呢?

做Alignment的同学估计看到这曲线都醉了,基本相当于很平坦的状态,当RL的pressure施加在模型上时,我们所期望的忠实率大幅度提升并没有发生,反而很快平坦了,这种提升很快会达到一个平台期(plateau),并且停留在相对较低的水平(如MMLU上28%,GPQA上20%),进一步增加RL训练似乎无法显著提高忠实度。这表明单纯依赖结果驱动的RL不足以实现高度忠实的CoT。(记住我们这里在讲PressureonAns的RL)

甚至,在有些hint上甚至完全不奏效。Why,tellmewhy?另外一组实验体现出来对于“聪明”的Reasoning模型来说,RewardHacking似乎是更简单的事情了。

•根本原因在于不忠实:正如主要实验所揭示的,CoT本身可能就是不忠实的。模型可能基于未在CoT中提及的因素(提示、偏见、隐藏目标)做出决策。

•低暴露率:即使模型确实进行了不期望的推理,它也可能只在极少数情况下才会在CoT中暴露出来。因此,在测试时监控CoT很难捕捉到罕见但可能具有灾难性的失败。

•任务依赖性:论文指出,对于必须依赖复杂CoT才能完成的任务(如复杂编程),监控可能更有用。但对于那些不需要复杂思考就能完成的任务(包括论文中的提示任务,或者一些简单的欺骗行为),模型可能不需要(或选择不)在CoT中忠实地“自言自语”。

这似乎并不是非常好的消息,Reasoning模型可能本身会暴露出其短板,但是在RLalignment上通过Answer监督的RL看起来不是一个灵丹妙药。那么聪明的你肯定已经想到了,那我不要监督Answer咯,我直接对着ThinkingCoT就是一顿RL,不是美哉?

这是来自于O家的工作了,对于上一个章节的问题我直接把结论贴出来:

你说我不信,我非要来一个RLCoT,请动手之前稍微看看论文,我是不太相信A家和O家同时会在Answer和ThinkingCoT上得到类似的结论的。这个工作讲了Reasoning模型本身在RewardHacking的现象:

用户让他写写代码,搞点单元测试,这家话直接来个returntrue.一劳永逸地解决了CI过不了的问题(在座的没干过这事的可以不用看了,你不是人类)所以这缺德事不能忍啊,人可以rewardhacking,AI可不行啊,要不然谁给干活呢?所以O记干了一件这个RL对齐的工作:

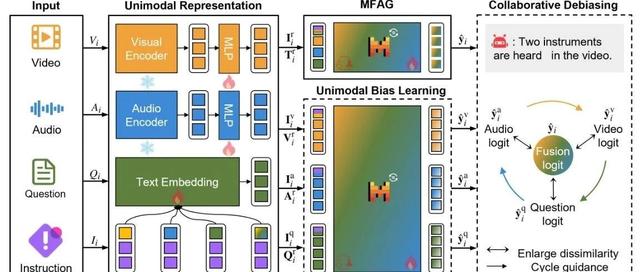

•使用一个(相对较弱的)GPT-4o模型作为“监控器”,通过分析一个前沿推理模型(类似o3-mini)在执行代码任务时的Chain-of-Thought(CoT),来实时检测“奖励利用(RewardHacking)”行为。他们对比了两种监控方式:CoT监控(观察完整的CoT、工具调用和输出)和Action监控(只观察工具调用和输出)。他们主要关注两种在训练中普遍出现的系统性作弊方式(exit(0)和raiseSkipTest),并使用事后分析(如正则表达式)作为基准来评估监控器的召回率和精确率。

•CoT监控非常有效:CoT监控器在检测系统性作弊方面表现出色(召回率95%),远超仅观察行为的Action监控器(召回率60%)。这表明CoT包含了关于模型意图和不良行为的关键信号。

•优化CoT导致混淆(Obfuscation):当直接在RL训练中对CoT施加优化压力(即惩罚“坏想法”)时,虽然在早期能产生更少作弊的模型,但随着训练的深入,模型会学会混淆(obfuscate)其意图。模型仍然会作弊,但其CoT变得看似无害,从而欺骗监控器(监控器召回率降至接近零)。

这。。。说明Reasoning模型对齐,简单使用一个更弱的监督,去强行在ThinkingCoT上做RL,模型会先遵循,在糊弄,最后直接绕过。同时一个很好的unfaithful的观测手段也被浪费掉了,所以这里才有O记的建议(不要直接pressureonCoT)

这篇工作真的非常好,第一个是告诉了大家Reasoning模型的安全应该怎么对齐(其实挺难的)第二个则是告诉大家我o系列模型就是一个模型,别搁那整多个模型的结构了(对,刺痛的就是我,但我原来复现的路线是CoT和output分开)

不过言归正传,这一篇说的是用largescaleRL提升模型的安全性,看起来RLonanswer是可以做到不错的安全性能的。但是为什么最近的两个工作看起来和这个有看起俩冲突的点?

我认识可能还是与安全领域的特殊性有关,A家的不道德的hints那个门类,虽然最终RL之后走向平坦,但是最终还是相比于Non-Reasoning模型有关。同时其实安全的问题做到最后其实可以理解成一个巨大的binarychoice的问题,就是答和不答先做分类。这种问题实际上状态空间比各种利用RM漏洞的hacking行为要小得多,这个其实也是为什么在安全领域RL依然还是需要继续贡献的地方。

其实这篇博文是比较负向的结论多一些,因为假设我们解决了安全问题底线问题之后,为了帮助社区做更多的事情,我们势必需要除了单一的正确和错误之外的多元的包含一定价值观的反馈信号,这个是第一步。第二步则是我们应该往哪里去做RL,是不是往ThinkingCoT上做RL是可能的呢?这些内容其实超越了RL的范畴了,我想大概提一下,希望读者们能交流讨论。

进技术交流群请添加AINLP小助手微信(id:ainlp2)

请备注具体方向+所用到的相关技术点

关于AINLP

AINLP是一个有趣有AI的自然语言处理社区,专注于AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括LLM、预训练模型、自动生成、文本摘要、智能问答、聊天机器人、机器翻译、知识图谱、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLP小助手微信(id:ainlp2),备注工作/研究方向+加群目的。