鲁棒音频-视觉问答新进展!西安交大、港科广提出全新测评数据集FortisAVQA与多模态大模型MAVEN助力鲁棒音视频问答

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

音视频问答(Audio-VisualQuestionAnswering,AVQA)是一项具有挑战性的多模态推理任务,需要智能系统理解音频-视频输入,准确回答自然语言查询。然而,现有的AVQA方法由于鲁棒性不足,容易学习到训练数据集中的分布偏差,导致在分布外数据上性能表现不佳。此外,当前的数据集也无法全面有效地诊断这些方法的鲁棒性。

为了应对这些挑战,研究团队引入了一个新的测评数据集FortisAVQA和强大的多模态视听认知模型MAVEN,它利用多方面循环协同去偏策略来减轻偏差学习。研究通过大量的实验结果,验证了MAVEN模型的强大性能和MCCD去偏差策略的广泛有效性。

论文标题:

FortisAVQAandMAVEN:aBenchmarkDatasetandDebiasingFrameworkforRobustMultimodalReasoning

论文地址:

https ://arxiv.org/abs/2504.00487

代码链接:

https ://github.com/reml-group/fortisavqa

数据集链接:

https ://huggingface.co/datasets/reml-group/FortisAVQA

模型链接:

https ://huggingface.co/reml-group/MAVEN

在日常生活中,我们常常需要同时理解看到的画面和听到的声音,才能准确判断发生了什么。想象这样一个场景:视频中有两个人同时演奏乐器。要回答“那个乐器的演奏声音最大?”仅靠画面或声音都不够,需要音频和视觉信息的融合推理。

因此,音视频问答(Audio-VisualQuestionAnswering,AVQA)任务是一项具有挑战性的多模态推理任务,给定一段音视频片段和一个自然语言问题,模型需综合理解音频与视觉线索,生成准确的文本答案。相比传统的视觉问答(VQA)或听觉问答(AQA),AVQA更贴近人类的多模态感知机制,但也更加具有挑战性。

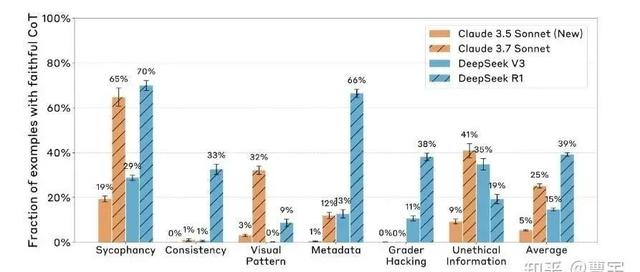

图1:现有AVQA数据集的构成以及现有方法STG和本文方法MAVEN的比较。目前的AVQA数据集中的问题是通过一组有限的预定义模板生成的,这可能与现实世界的情况不符。我们的研究发现,现有的方法,如STG,并不具备良好的鲁棒性,这可能归因于过度的偏差学习,例如记住了关键问题词和答案之间的统计规律性。

挑战一:现有数据集无法全面衡量模型鲁棒性

现有音视频问答数据集问题模板和词汇空间有限,偏离真实世界场景,且无法有效评估模型在处理罕见或不常见样本时的性能,而这对于评估模型的鲁棒性至关重要。

挑战二:现有模型鲁棒性不足

现有的AVQA方法在处理罕见问题时表现不佳,容易过拟合到训练数据中的偏差,导致在测试阶段遇到罕见问题时性能下降,说明它们可能只是记住了问题词和答案之间的统计规律,而不是真正理解了多模态信息。

FortisAVQA是第一个旨在评估AVQA模型鲁棒性的数据集。它的构建涉及两个关键过程:改写(Rephrasing)和划分(Splitting)。

对现有的MUSIC-AVQA数据集中的测试问题进行重述,让同一个问题有多种不同的表达方式。这就像是给机器出了一道道“变形题”,让模型不能只靠“背答案”来应对,而是要真正理解问题的含义。这样一来,测试集的问题数量从9129条显著增加到了211572条,问题的词汇量也从原来的93个词扩展到了465个词,更接近真实世界中的语言多样性。

图2:FortisAVQA的重述可视化。左侧面板展示了FortisAVQA中的一个重述示例,而中间和右侧面板分别展示了FortisAVQA和MUSIC-AVQA的问答分布,基于它们问题的前三个词。

为什么要划分:

在AVQA任务中,我们希望模型不仅能在常见问题上表现出色,还能在面对罕见问题时保持稳定的性能。这就需要一个能够同时评估模型在常见(in-distribution)和罕见(out-of-distribution)问题上的表现的数据集。然而,现有的数据集往往无法做到这一点。

如何进行划分:

问题分组:首先,根据问题类型对问题进行分组。这些类型在MUSIC-AVQA数据集中已经标注好了。

平衡度量:为了衡量每个问题组的平衡程度,采用了香农熵(ShannonEntropy)来量化答案分布的均匀性,保留更加不平衡的组。

动态划分:本文提出了一种基于共形预测(ConformalPrediction)的动态划分方法。这种方法的核心是通过优化问题,自动调整常见问题(head)和罕见问题(tail)的边界。具体来说,给定一个数据集,包含个类别,目标是找到一个最优的头部问题集合,使得:

即在满足头部数据覆盖性的条件下,尽可能减小头部集合大小。

这种动态划分方法能够根据数据分布自动调整常见问题和罕见问题的边界,避免了人为设定固定阈值带来的局限性。

图3:FortisAVQA中AVQA任务的统计可视化。µ(a)是一个组中的平均答案数。之前的划分机制,采用固定的经验值进行划分,导致子图(a)中所有类别都被分配给尾部。相比之下,新提出的方法通过适应数据分布提供了更大的灵活性。k是方程(2)中的比率。

图4:我们提出的多模态音频-视觉认知网络(MAVEN)示意图。

增大差异度:通过计算单模态预测和多模态预测之间的KL散度,放大它们之间的分布差异。这使得模型在生成答案时,不能仅仅依赖于某个模态的偏差,而是需要综合考虑所有模态的信息。

循环一致性:通过循环引导机制,约束每个模态的预测分布,使其保持一致性。这进一步增强了模型的鲁棒性。

因此最终的优化目标是,其中,是答案生成的损失。

MAVEN模型训练算法流程如下:

图5:MAVEN模型训练算法流程

本文通过一系列充分的实验,验证了MAVEN模型在音视频问答任务中的强大性能和鲁棒性。

图6:MUSIC-AVQA与FortisAVQA的测试集划分对比。为了减轻在大型模型上的测试开销,我们对两个数据集分别以10%和1%的比例进行了均匀采样,从而得到MUSIC-AVQA_s和FortisAVQA_s。实验在评估小模型时使用整个测试集,而在评估大型多模态模型时,使用了采样后的测试集。

实验主要在两个数据集上进行:

MUSIC-AVQA:包含31,927个训练样本、4,568个验证样本和9,129个测试样本。这些样本涵盖了9,288个音乐表演视频,问题由有限的预定义模板生成。

图7:MUSIC-AVQA测试结果

FortisAVQA:在MUSIC-AVQA的基础上扩展而来,通过问题重述和分布偏移,将测试问题数量扩展到211,572个。FortisAVQA提供了更全面的评估,包括在常见问题(head)、罕见问题(tail)的表现,用来评估模型的鲁棒性。

图8:FortisAVQA测试结果

通过一系列详细的实验,MAVEN模型在多模态音视频问答(AVQA)任务中展现出了卓越的性能和鲁棒性。实验结果表明:

MAVEN在MUSIC-AVQA数据集上达到了新的SOTA性能,显著超过了所有基线模型。

在FortisAVQA数据集上,MAVEN不仅在常见问题上表现出色,还在罕见问题上展现出了强大的鲁棒性。

MCCD策略具有很强的通用性,可以作为即插即用的模块,显著提升多种基线模型的性能。

本文介绍了FortisAVQA,一种全新的音视频问答测评数据集,以及一套全面的评估指标。通过引入合理的分布自适应划分算法,使得对AVQA模型,提供对其在分布内和分布外场景中的泛化性能的见解。

我们提出了一个生成式AVQA架构MAVEN,它结合了MCCD策略来克服训练偏差和执行鲁棒生成。据我们所知,这是第一个系统探讨来自数据集评估和模型的AVQA任务设计。

我们在MUSIC-AVQA和FortisAVQA数据集上进行了广泛的实验,评估了12种最近的多模态QA方法,并表明它们不仅在分布内情景中泛化能力有限,而且在分布外情况下泛化能力有限,同时也验证了MAVEN的强大性能和去偏差策略的有效性。

目前,FortisAVQA数据集和MAVEN模型权重已经开源至HuggingFace,期望能够为多模态问答的研究提供支持,推动该领域的进一步发展。

进技术交流群请添加AINLP小助手微信(id:ainlp2)

请备注具体方向+所用到的相关技术点

关于AINLP

AINLP是一个有趣有AI的自然语言处理社区,专注于AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括LLM、预训练模型、自动生成、文本摘要、智能问答、聊天机器人、机器翻译、知识图谱、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLP小助手微信(id:ainlp2),备注工作/研究方向+加群目的。