DiffRhythm:创作完整歌曲,支持文本转音乐和纯音乐生成,MacOS 上可运行!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

。

公众号之前已经和大家介绍过许多关于音乐生成的文章,感兴趣的小伙伴可以在公众号栏目中点击“AI音乐”获取更多信息。

DiffRhythm是第一个能够创作完整歌曲的开源基于扩散的音乐生成模型。目前已经支持文本转音乐和纯音乐生成,可以在MacOS运行!该名称结合了“Diff”(参考其扩散架构)和“Rhythm”(强调其对音乐和歌曲创作的关注)。中文名称谛韵(DìYùn)在发音上与“DiffRhythm”相似,其中“谛”(专心聆听)象征着听觉感知,“韵”(旋律魅力)代表音乐性。目前代码和模型都已经公开。

一起来听一个示例:

独立民谣叙事曲,成长阵痛主题,木吉他串联和弦排列口琴奏间(独立民谣、成长主题、原声吉他弹奏与口琴插曲)

提出了DiffRhythm,这是第一个基于端到端扩散的歌曲生成模型,能够生成带有人声和伴奏的完整歌曲。

提出了一种句子级歌词对齐机制,以提高人声清晰度,该机制以最少的监督解决超稀疏歌词人声对齐问题。

练了一个变分自动编码器(VAE),专门用于高保真音乐重建,同时表现出对MP3压缩伪影的卓越鲁棒性。此外,我们的VAE与著名的StableAudioVAE3共享相同的潜在空间,从而可以在现有的潜在扩散框架中实现无缝即插即用替换。

尽管DiffRhythm很简单,但它在歌曲生成方面取得了出色的表现。数据处理管道、在大规模数据集上训练的预训练模型以及完整的训练配方都是公开的。

论文:https ://arxiv.org/pdf/2503.01183

代码:https ://github.com/ASLP-lab/DiffRhythm

模型:https ://huggingface.co/ASLP-lab/DiffRhythm-base

试用:https ://huggingface.co/spaces/ASLP-lab/DiffRhythm

主页:https ://aslp-lab.github.io/DiffRhythm.github.io/

音乐生成领域的最新进展引起了广泛关注,但现有方法面临严重限制。一些当前的生成模型只能合成人声音轨或伴奏音轨。虽然有些模型可以生成人声和伴奏的组合,但它们通常依赖于精心设计的多级级联架构和复杂的数据管道,从而阻碍了可扩展性。此外,大多数系统仅限于生成短音乐片段,而不是完整的歌曲。此外,广泛使用的基于语言模型的方法推理速度较慢。

为了应对这些挑战,论文中提出了DiffRhythm,这是第一个基于潜在扩散的歌曲生成模型,能够在短短十秒内合成长达4分45秒的完整歌曲,同时保持较高的音乐性和清晰度。尽管DiffRhythm功能强大,但它的设计却简单而优雅:它无需复杂的数据准备,采用简单的模型结构,推理时只需要歌词和风格提示。此外,它的非自回归结构可确保快速的推理速度。这种简单性保证了DiffRhythm的可扩展性。

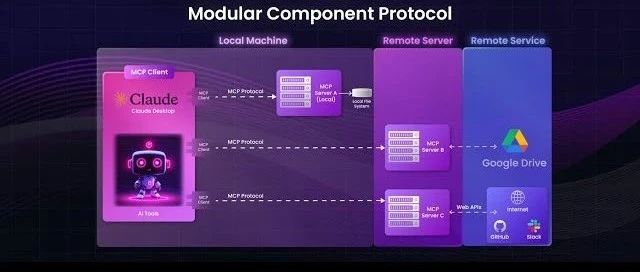

DiffRhythm的架构。风格和歌词作为外部控制信号,经过预处理得到风格嵌入和歌词token,输入到DiT生成潜在词,随后经过VAE解码器生成音频。

DiffRhythm的数据预处理管道。歌词经过G2P并放置在与其时间戳对应的位置。

DiffRhythm以44.1kHz采样率生成全长立体声音乐作品(最长4分45秒),由歌词和风格提示引导。该架构由两个连续训练的模型组成:

变分自动编码器(VAE),学习波形的紧凑潜在表示,同时保留感知音频细节,有效解决原始音频建模中的序列长度限制;

扩散变换器(DiT)在学习的潜在空间中运行,通过迭代去噪生成歌曲。

与基于LM的方法中的传统离散标记相比,我们的连续潜在表示可以捕捉更丰富的音乐细节和声音细微差别,从而实现高保真音频重建。同时,DiT强大的建模能力和连续VAE潜在序列长度的缩短确保了全长歌曲的卓越长期音乐结构一致性和声音清晰度。此外,

DiffRhythm是第一个基于全扩散的模型,能够在短短10秒内生成完整的4分45秒立体声歌曲,包括人声和伴奏。该模型的优雅设计消除了对复杂的多阶段级联建模和费力的数据预处理的需求,从而促进了可扩展性。DiffRhythm的非自回归结构确保了快速的推理速度,同时保持了高音乐质量和歌词清晰度。大量的实验结果证明了提出方法的有效性,并强调了DiffRhythm强大的歌曲生成能力。代码和预训练模型已发布。

感谢你看到这里,也欢迎点击关注下方公众号并添加公众号小助手加入官方读者交流群,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、StableDiffusion、Sora等相关技术,欢迎一起交流学习💗~