一张图片知道你在哪?o3-like 7B模型超越一流开闭源模型!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

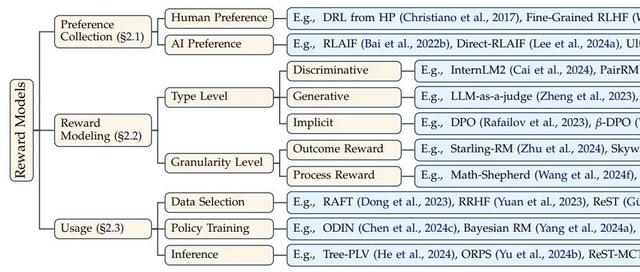

为了提高多模态大语言模型(MLLMs)的性能,近期一些方法尝试通过基于图像的数学任务、图表分析任务以及逻辑谜题任务来激活纯推理能力,而另一些方法则专注于通过传统的检测任务(如目标检测、计数和分割)来提升纯感知能力,同时也有一些工作希望在推理的时候实现文字形式的视觉内容重感知。但是目前都存在的缺陷是:MLLM在视觉推理时候都只是纯文本的形式。

o3(https ://openai.com/index/thinking-with-images/)的出现,实现了在思维链中进行视觉推理,在推理同时借助工具可以动态操作图像(旋转、缩放或变换)比如“butI’llzoominabitjusttobeabsolutelysure!”,极大提高了推理过程中的感知能力,可以挖掘细节、模糊、容易被忽视的视觉线索,形成一条完整的视觉思考证据链。其中官方有一个非常有意思示例是通过一张图片定位到图片拍摄地区曾经拍摄过的电影,在这样的场景中我们需要挖掘视觉线索——推理——挖掘视觉线索——再推理…直至推理出最终结果。因此我们认为“VisualClue-Tracking”很适合描述这个能力。

因此我们提出了一项新任务:地理定位推理(GeolocationReasoning)。这项任务在自然地提供准确位置标签的同时,要求模型在感知视觉信息的过程中,对视觉语义中的高级逻辑关系进行推理,最终实现位置的确定,非常适合实现o3-like的视觉线索跟踪推理。可以通过这些猜猜图片的在哪拍摄的游戏更深刻感受这一任务:GeoGuess(https ://www.geoguessr.com/)和TuXun(https ://tuxun.fun/)。我们专门构建了一个用于地理定位的基于规则的强化学习数据集:SeekWorld(https ://huggingface.co/datasets/TheEighthDay/SeekWorld)。数据集中包含两个训练集,一个训练集(Train-Clue-Tracking)包含我们从o3搜集的50(持续扩充中)条包含视觉线索跟踪推理的详细过程的数据,另外一个训练集(Train-No-Process)中是不含有视觉线索跟踪推理的8541条数据。前者可以用于进行Cold-Start的SFT训练,后者可以用于RL训练。此外包含两个测试集(Test-Global和Test-China)用于评测。

目前我们在持续推进以下工作,欢迎关注我们的Github:

继续扩充Cold-StartSFT数据集的规模

Cold-StartSFT(Train-Clue-Tracking)+RL(Train-No-Process)训练

评估o3在SeekWorld上的效果

评估不同感知与推理benchmark的效果

首先感受一下o3的效果,猜猜下面图片拍摄在哪?

这张图片正是拍摄于中国重庆的洪崖洞景区~

下面是一张图片,看看我们通过SeekWord-7B模型的推理得到的结果:

这里正是云南的沙溪古镇,模型给出了详细推理的流程,并定位到了云南~

我们制作了一个demo网站,上传你的图片来试试吧!:HFDemo(https ://huggingface.co/spaces/TheEighthDay/SeekWorld_APP)

Model

Global-Test

China-Test

OverallAccuracy

GPT4o-240806🔒

31.90

Doubao-1.5-vision-pro-32k-250115🔒

43.75

41.99

Gemini-2.0-flash-thinking-exp-01-21🔒🧠

56.25

29.49

41.85

QvQ-72B-max-2025-03-25🧠

48.13

31.63

39.25

Qwen-2.5-32B-VL

38.12

24.13

30.59

Cold-StartSFT+RL

DirectRL

Qwen-2.5-7B-VL[DirectRL]

51.25

31.90

40.84

Qwen-2.5-7B-VL[DirectSFT]

37.19

25.47

30.88

Qwen-2.5-7B-VL

33.44

24.40

28.57

Qwen-2.5-7B-VL+CoT

25.31

21.45

23.23

带有🔒标识的模型是专有闭源模型,而带有🧠标识的模型则具备增强的推理能力。我们采用(Reinforce++)作为RL算法。

我们目前尚未完成在Train-Clue-Tracking上的Cold-StartSFT训练,DirectSFT和DirectRL分别指在Train-No-Process上直接进行SFT和RL训练。相比于Qwen-2.5-7B-VL,SeekWorld-7B在RL训练中尝试了两项优化。其中,难度采样有效地提高了测试的准确率。长度激励仅增加了推理过程的长度,而没有提高准确率。不过幸运的是,它能更好地展示中间推理过程。我们也在尝试使用GRM进行更好的过程监督.

难度采样:我们在训练集中对不同难度级别的问题进行了采样。具体来说,由于数据集中难题数量相对较多(5655道),我们将简单题(1945道)和中等难度题(941道)的数量翻倍,分别扩充到3890道和1882道。

长度激励:我们尝试引入了一种鼓励增加推理长度的奖励机制。奖励值设定为字符数量乘以0.001,奖励值最高为1.0。

数据集包含以下特点:

包含视觉推理过程:第一个包含o3模型视觉思维链或者视觉线索跟踪能力的数据集。

全球多样化采样:涵盖了来自世界各地广泛的场景集合,确保模型能够对多样的文化、地形和背景环境实现强大的泛化能力。

针对rule-basedRL优化的图像-标签对:对于图片清洗了包含位置信息的水印,对于地理坐标标签增加了一级行政规划区的别名,防止模型被错误惩罚。

分层难度架构:包含三个不同的推理难度层级——简单、中等和困难,以逐步挑战和评估模型在地理定位方面的能力。

Dataset

DataVolume

Source

Train-Clue-Tracking

50(持续扩充中)

Collectionofvisualclue-trackingreasoningprocessfromo3

Train-No-Process(easy-medium-hard)

8541(1945-941-5655)

Panoramas&user-uploadedimagesfromGoogleMapsinrecentyears

Global-Test

320

Panoramas&user-uploadedimagesfromGoogleMapsinrecentyears

China-Test

373

ThelatestXiaohongshuAppimagescollectedonApril14,2025,anditisalmostimpossibletohavebeenpre-trained

我们热烈欢迎参与到SeekWorld项目中来!如果您对地理定位推理感兴趣,您可以向我们发送一张具有挑战性的测试图片,以此来帮助我们构建一个更全面的评估数据集。贡献方式如下:

拍摄一张带有地理线索但又不是很容易就能识别出位置的照片(例如,街景、生活照片、建筑、自然景观)。

确保该图片对应的是一个真实的地点(例如,具体到国家和一级行政区)。如果可能的话,请同时提供该地点的经纬度。并确保图片中不包含任何个人信息。

请在邮件主题中注明:[SeekWorldCrowdContribution]。然后将图片发送至我们的邮箱地址:tikibi001@163.com。

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦