仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

大家好,我是Ai学习的老章

vLLM和SGLang是大模型领域最著名、热度最高的两个推理引擎,也都是DeepSeek推荐使用的推理引擎。

vLLM45.3K星标项目:https ://github.com/vllm-project/vllm文档:docs.vllm.ai

SGLang13.4K星标项目:https ://github.com/sgl-project/sglang文档:docs.sglang.ai/

纯个人感受,我还是比较喜欢vLLM,之前多次用vLLM引擎部署过大模型:【教程】阿里最新多模态大模型Qwen2.5-VL-32B,本地部署实践

【本地部署教程】真·OpenAI&真·多模态

极简教程,4张4090,本地部署QwQ

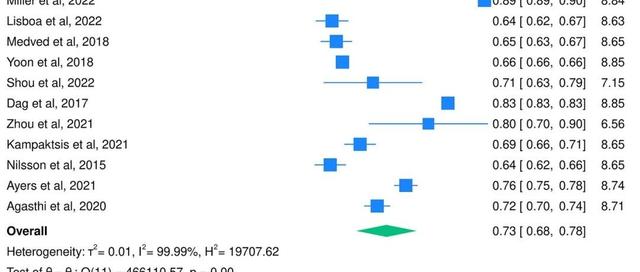

说回标题,vLLM前几天发了一个性能更新的推,测试了在8xH200上,vLLM在DeepSeekV3/R1模型的吞吐量方面领先,还期待与DeepSeek的推理引擎开源计划合作,实现进一步的提升。

这里面有两个点

一是它配图中对比了不同场景下与SGLang和TensorRT这两个推理引擎的对比数据,vLLM短进短出情况下遥遥领先,后面几个场景中SGLang甚至被TensorRT超越

二是它期待的与DeeSeek的开源合作,这是前几天DeepSeek[[2025-04-19-刚刚,DeepSeek宣布,准备开源推理引擎]]中说到其开源引擎是基于vllm魔改,准备开源

然后SGLang直接回应了这条,并置顶了回复:我们对比了vLLM0.8.4和SGLang0.4.5.post1的离线性能。基准测试结果表明,SGLang在所有情况下都优于vLLM,大多数情况下领先约10%,最大领先幅度为38%。

也有网友表示,可以轻松调整SGLang,使其性能比vLLM高出23%。

lmsysorg联合创始人LianminZheng亲自下场,表示vLLM发布的基准测试结果存在明显的误导性,SGLang官方可以测出比vLLM更好的结果。并生成这已经不是vLLM第一次分享误导性信息,应该考虑删除这篇帖子以维护声誉。

然后vLLM连续发布了两个测试结果,表示没有发布误导性的结果,它可以通过精确的命令和环境重现。

话说,类似测试、打脸、再测试属实没什么意义。各家的推理引擎都在不断进行各种优化,即便是同一版本的模型,各家进行测试时,本身就更倾向于对自家引擎的各种参数设置上多加权衡,而对竞争对手的引擎的参数可能考虑就没有那么多了。

这一波,我站SGLang,vLLM自己测试可以,在某个版本上提升多少随便怎么吹都可以,没必要拉上SGLang和TensorRT。

最后,我建议两家别吵了,同时建议大家感受一下我最近在用的Xinferecev1.5,它直接支持了vllm、sglang、llama.cpp、transformers、MLX等推理引擎,还提供了可视化界面管理各种大模型。

🎉配置与使用方式详见文档:https ://inference.readthedocs.io/zh-cn/latest/models/virtualenv.html

📦更新指南

📥pip:pipinstall’xinference==1.5.0’

🐳Docker:拉取最新版本即可,也可以直接在镜像内用pip更新。

🛠️功能增强

🧠Gradio聊天界面支持展示思考过程(需打开“解析思维过程”)

📐Vision模型支持min/max_pixels控制输入分辨率

📥模型下载支持进度显示与取消

⚙️默认并发数设置为CPU核心数

🧪支持InternVL3的AWQ推理

🏎️默认使用最新版xllamacpp引擎

制作不易,如果这篇文章觉得对你有用,可否点个关注。给我个三连击:点赞、转发和在看。若可以再给我加个🌟,谢谢你看我的文章,我们下篇再见!

搭建完美的写作环境:工具篇(12章)图解机器学习-中文版(72张PNG)ChatGPT、大模型系列研究报告(50个PDF)108页PDF小册子:搭建机器学习开发环境及Python基础116页PDF小册子:机器学习中的概率论、统计学、线性代数史上最全!371张速查表,涵盖AI、ChatGPT、Python、R、深度学习、机器学习等