清华最新研究:强化学习竟是大模型的“应试教育”,并未突破原有潜力

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

最近,LLM圈流传一个“反常识”结论:用强化学习训练的大模型,可能只是在“考试作弊”,而不是真正变聪明了!

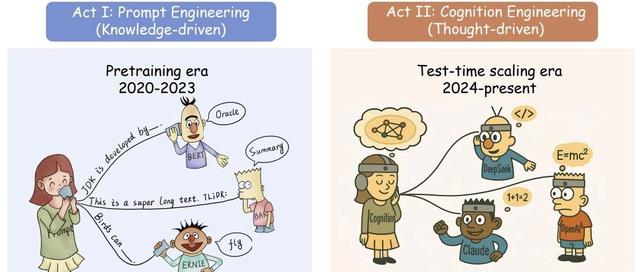

这篇来自清华和上交的论文,像一场“学术打假”,挑战了行业共识。过去人们认为,强化学习(RLVR)能让大模型(如GPT、DeepSeek-R1)在数学、编程等复杂任务中“自我进化”,解锁基础模型没有的能力。但论文通过大量实验证明:RLVR只是让模型更会“猜答案”,并未突破原有潜力。

如果把大模型比作学生,RLVR就像“题海战术+押题培训”:

短期提分快:小样本测试(如只考1次)时,RLVR模型得分更高(比如数学题正确率提升30%)。

长期潜力低:如果允许“无限次重考”(比如尝试256次),基础模型反而能解决更多难题!

关键结论:RLVR只是让模型更擅长“快速找到已知解法”,但牺牲了探索新方法的能力,像培训班教出的“应试机器”。

为了验证这一点,研究者设计了一场特殊的“考试”——pass@k测试:

规则:让模型对同一问题生成k个答案,只要有一个正确就算通过。

结果:当k=1时,RLVR模型胜出;但当k=256时,基础模型反超!

案例:在奥数题AIME24中,基础模型通过“穷举”找到了RLVR模型从未触达的正确解法。这说明:所有RLVR的“高级推理”,其实早已藏在基础模型的可能性中。

论文用“搜索树”比喻模型思维:

基础模型:树枝分散,可能覆盖更多路径(包括正确答案)。

RLVR模型:修剪枝叶,只保留“得分高”的路径,效率提升但探索受限。

数学解释:RLVR通过奖励机制(如答案正确得1分)让模型输出分布偏向高奖励路径,导致输出熵降低(多样性减少)。就像学生只背标准答案,不再思考其他解法。

如果RLVR是“应试培训”,知识蒸馏则是“拜师学艺”:

原理:让小模型学习大模型的完整推理过程(如DeepSeek-R1的解题思路)。

结果:蒸馏模型的pass@k曲线全面高于基础模型,真正扩展了能力边界。

启示:想要突破潜力,必须注入新知识,而非仅仅优化答题策略。

论文给行业泼了一盆冷水:当前RLVR无法突破基础模型的天花板。未来方向可能包括:

探索新训练范式:如何在保证效率的同时不限制多样性?

结合蒸馏与RLVR:先用蒸馏扩展能力,再用RLVR优化表现。

重新定义评估指标:不能只看“单次得分”,更要关注“潜力上限”。

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦