阿里EMO2重磅升级!手部动作生成+超逼真表情,音频驱动人像视频生成再进化!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

在之前的文章中已经和大家介绍过阿里提出的音频驱动的人像视频生成方法EMO,感兴趣的小伙伴可以点击下面链接阅读~

阿里最新EMO:只需要提供一张照片和一段音频,即可生成会说话唱歌的AI视频

此外公众号的底部菜单栏也整理了数字人相关的方法合集,欢迎大家阅读收藏~

EMO2是由阿里开发的一个音频驱动的人像视频生成框架,该项目扩展了原EMO(EmotePortraitAlive)项目,增加了手部动作生成功能,显著提升了视频的真实性和动态感。EMO2将音频驱动的人像视频生成分为两个阶段

在第一阶段,直接从音频输入生成手势,利用音频信号和手部动作之间更强的相关性。

在第二阶段,使用扩散模型来合成视频帧,结合第一阶段生成的手势来产生逼真的面部表情和身体动作

通过输入单个角色图像和声音音频(例如唱歌),EMO2可以生成不仅具有富有表现力的面部表情而且具有各种身体姿势的声音头像视频。

角色:AIGirl

演唱来源:席琳·迪翁《我心永恒》,EmmaHeesters翻唱

EMO2支持多种语言的语音,并通过直观地识别音频中的音调变化使图像栩栩如生,从而能够创建动态、性能丰富的化身。

角色:泰勒·斯威夫特

配音来源:IlizaShlesinger的脱口秀

EMO2可以生成复杂而流畅的手部动作,使化身以生动的表演栩栩如生。

角色:张元英

声音来源:想你(剪辑)

EMO2的一个潜在应用是让指定的角色在电影和游戏场景中表演相关剧本,并且表演符合他们的角色形象。

角色:黄仁勋

配音来源:众议院投票禁止TikTok

主页:https ://humanaigc.github.io/emote-portrait-alive-2

论文:https ://arxiv.org/pdf/2501.10687

论文提出了一种新颖的音频驱动的说话头部方法EMO2,能够同时生成高度富有表现力的面部表情和手势。与专注于生成全身或半身姿势的现有方法不同,我们研究了音频驱动手势生成的挑战,并确定音频特征和全身手势之间的弱对应性是一个关键限制。为了解决这个问题,作者将该任务重新定义为一个两阶段过程。在第一阶段,直接从音频输入生成手势,利用音频信号和手部动作之间更强的相关性。在第二阶段,使用扩散模型来合成视频帧,结合第一阶段生成的手势来产生逼真的面部表情和身体动作。

给定一个角色的单幅参考图像,EMO2可以通过输入一段音乐/人声音频片段来为角色制作动画,同时保留自然的面部表情和肢体动作,并与输入音频的变化相协调。

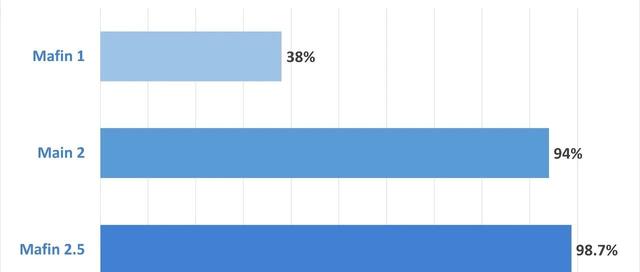

论文设计了一个基于扩散模型的双阶段共声人体视频生成框架EMO2。该框架扩展了EMO,使其能够生成整体的面部表情和上半身运动。引入了“像素先验逆运动学”(pixelspriorIK)的概念。在第一阶段,只生成手部运动,然后在第二阶段将其用作控制信号。结果表明,与其他方法相比该框架能够生成更具表现力和生动感的人体视频.

感谢你看到这里,也欢迎点击关注下方公众号并添加公众号小助手加入官方读者交流群,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、StableDiffusion、Sora等相关技术,欢迎一起交流学习💗~