细节超越SAM2!商汤开源视频抠图新标杆:MatAnyone发丝级还原!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

以下文章来源于微信公众号:码科智能

作者:视觉大模型

链接:https ://mp.weixin.qq.com/s/LUJBWmrOGsiOL48UDK8KVw

本文仅用于学术分享,如有侵权,请联系后台作删文处理

导读

南洋理工与商汤提出MatAnyone,针对视频抠像“细节丢失”“目标漂移”难题,借一致性记忆传播机制,仅首帧标注即可实现发丝级透明度预测与跨帧稳定追踪,相关成果已开源。

去年Meta开源的SAM2模型,处理能力从图像分割拓展到视频分割。其可实时处理任意长视频,视频中没见过的对象也能轻松分割追踪,具体可查看:Meta开源SAM2:模型代码、权重以及数据集通通开源!

但若想在影视剪辑、游戏制作等领域真正落地应用还需解决很多问题,比如如何抠图至头发丝级别精度,这就是普通分割无法解决的问题,需要难度更进一步的视频抠图来处理,今天我们来聊聊这个问题。

上图是SAM2的效果,但面对复杂背景和多目标干扰时,视频抠像技术始终面临”细节丢失”和”目标漂移”两大难题。

南洋理工大学与商汤科技最新发布的MatAnyone,仅需首帧标注即可实现发丝级透明度预测,且具备跨帧一致性追踪及多目标精准锁定。MatAnyone只需在第一帧通过人物遮罩指定抠像目标,即可在整个视频中实现稳定、高质量的目标提取。

MatAnyone是一个实用的支持目标分配的人体视频抠图框架,在核心区域语义和细粒度边界细节方面均有稳定的表现。

为了让视频抠像技术能被更好地使用,MatAnyone专注解决的是这样一个场景:给定目标人物在第一帧的掩膜,后续的抠像自动锁定目标完成。无需逐帧修正,准确、自然、连贯地抠出整段视频。

MatAnyone借鉴视频分割中的记忆机制,在此基础上提出了专为视频抠图设计的一致性记忆传播机制。该模块自适应地整合前一帧的记忆,对于变化幅度较大的区域(通常出现在目标边缘,如头发、衣摆),模型更依赖当前帧从记忆库中检索到的记忆信息。而对变化较小的区域(如身体内部),则更多保留上一帧的记忆信息,避免重复建模,减少误差传播。

总结一下,MatAnyone三大核心突破:一帧锁定精准可控:仅需在首帧指定目标,后续全程自动跟踪,无需逐帧调整。无论是单人特写还是复杂多目标场景,都能精准锁定指定对象。智能记忆稳定不抖:动态区分视频中的稳定区域(如身体主干)和易变细节(如发丝、衣摆)。主干部分依赖历史帧保持稳定,边缘细节实时优化。发丝级超清细节:通过真实分割数据+高质合成数据联合训练,在头发、薄纱等半透明区域实现像素级自然过渡。#论文链接https ://arxiv.org/abs/2501.14677#代码链接https ://github.com/pq-yang/MatAnyone#项目链接https ://pq-yang.github.io/projects/MatAnyone/

二、MatAnyone效果

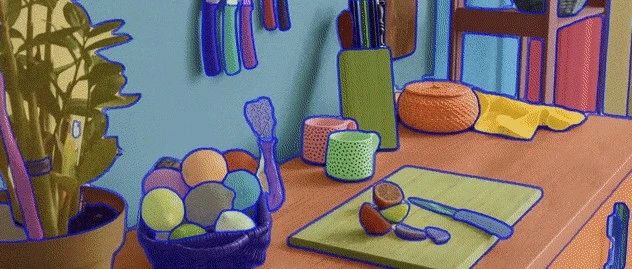

MatAnyone在视频目标分割中不仅要求核心区域的语义精准,更要求边界细节的提取(如发丝、衣角的半透明过渡),与SAM2的对比:

面对多人物或复杂背景的视频内容的实例抠图,不同模型效果对比:

当SAM2引爆图像分割革命,MatAnyone这种设置既兼顾用户可控性,又具有更强的实用性和鲁棒性,正在视频抠图领域竖起新的技术标杆。

欢迎加入《AI未来星球》,一起成长

扫描下方二维码即可加入~

你可以获得什么?

1、大白之前花费10W+购买,AI行业各场景私有数据集下载,星球内倾情分享;2、AI行业研发、产品、商业落地问题咨询(目前AI公司创业中),都可获高质量解答,有效期一年,无限次提问,有问必答。3、定期邀请AI行业各类嘉宾分享,创业/商业等方面的经验!

帮助你解决遇到的实际问题,升职加薪!

大家一起加油!