这也行?小模型指导大模型Reasoning,无需训练,成本减少40%

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

如今的大型语言模型(如GPT-4、QwQ等)就像“学霸”,遇到问题时会一步步推理,最终给出答案。但这种“学霸”有个毛病——爱纠结!比如算一道简单的数学题,它可能写下10步推导,但其实只需要3步。这就是论文提到的“过度思考”(Overthinking)问题。

现有的解决方法主要是微调模型,但这需要大量数据、可能破坏安全性,还像给学霸“洗脑”一样不可控。有没有更简单高效的方式?

论文通过实验发现,不同训练方式的模型“性格”截然不同:

RL训练型模型:像“完美主义者”,即使你给了参考答案,它还是会自己再想一遍,直到满意为止。

蒸馏型模型:像“乖学生”,看到参考答案的结束标记就立刻停笔,不管答案对不对。

更神奇的是,如果给小模型一个“划重点”任务(生成高层次的解题思路),再把这些思路塞进大模型的思考标记(和)之间,大模型就能跳过冗余步骤,直接输出答案!

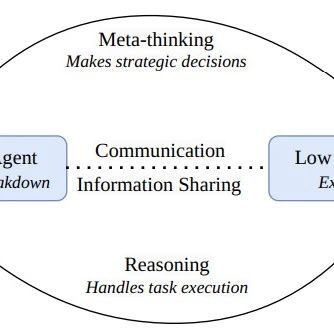

ThoughtMani的核心思路:用一个小模型当“助教”,先帮大模型梳理解题大纲,再让大模型“抄作业”。具体流程如下:

助教生成大纲:小模型根据问题生成关键步骤(比如“先算总数,再减去已知部分”),但不涉及具体计算。

塞进“思考框”:把这些大纲放在大模型的标记内,告诉它“这是参考答案”。

大模型偷懒:大模型看到大纲后,可能直接采纳,也可能稍微补充,但总体步骤大幅减少。

(流程图:小模型生成大纲→插入大模型→大模型输出精简答案)

这种方法无需训练,成本极低,还能让输出长度减少30%-40%!

论文在数学、编程等任务上测试了ThoughtMani,结果惊艳:

效率提升:在GSM-8k数学题上,输出长度从1791个token降到1075个,相当于从“小作文”变“简答题”。

安全性增强:意外发现,用外部思考还能让模型更“守规矩”,平均安全性提升10%。

省钱秘诀:小模型生成大纲的成本几乎可以忽略,整体计算开销大幅降低。

更妙的是,小模型比大模型更适合当助教!因为大模型生成的思路太细节,反而容易“带偏”大模型,而小模型简单直白的提示效果更好。

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦