DeepSeek公布最新成果,开启DeepSeek R2时代?

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

来源:机器之心

这会是DeepSeekR2的雏形吗?2025年4月4日,DeepSeek提交到arXiv上的最新论文正在AI社区逐渐升温。

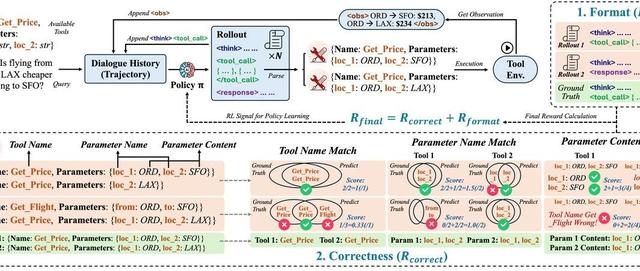

当前,强化学习(RL)已广泛应用于大语言模型(LLM)的后期训练。最近RL对LLM推理能力的激励表明,适当的学习方法可以实现有效的推理时间可扩展性。RL的一个关键挑战是在可验证问题或人工规则之外的各个领域获得LLM的准确奖励信号。

来自DeepSeek、清华大学的研究人员探索了奖励模型(RM)的不同方法,发现逐点生成奖励模型(GRM)可以统一纯语言表示中单个、成对和多个响应的评分,从而克服了挑战。研究者探索了某些原则可以指导GRM在适当标准内生成奖励,从而提高奖励的质量,这启发我们,RM的推理时间可扩展性可以通过扩展高质量原则和准确批评的生成来实现。

论文标题:Inference-TimeScalingforGeneralistRewardModeling

论文链接:https ://arxiv.org/abs/2504.02495

基于这一初步成果,作者提出了一种新学习方法,即自我原则批评调整(SPCT),以促进GRM中有效的推理时间可扩展行为。通过利用基于规则的在线RL,SPCT使GRM能够学习根据输入查询和响应自适应地提出原则和批评,从而在一般领域获得更好的结果奖励。

基于此技术,DeepSeek提出了DeepSeek-GRM-27B,它基于Gemma-2-27B用SPCT进行后训练。对于推理时间扩展,它通过多次采样来扩展计算使用量。通过并行采样,DeepSeek-GRM可以生成不同的原则集和相应的批评,然后投票选出最终的奖励。通过更大规模的采样,DeepSeek-GRM可以更准确地判断具有更高多样性的原则,并以更细的粒度输出奖励,从而解决挑战。

除了投票以获得更好的扩展性能外,DeepSeek还训练了一个元RM。从实验结果上看,SPCT显著提高了GRM的质量和可扩展性,在多个综合RM基准测试中优于现有方法和模型,且没有严重的领域偏差。作者还将DeepSeek-GRM-27B的推理时间扩展性能与多达671B个参数的较大模型进行了比较,发现它在模型大小上可以获得比训练时间扩展更好的性能。虽然当前方法在效率和特定任务方面面临挑战,但凭借SPCT之外的努力,DeepSeek相信,具有增强可扩展性和效率的GRM可以作为通用奖励系统的多功能接口,推动LLM后训练和推理的前沿发展。

这项研究的主要贡献有以下三点:

研究者们提出了一种新方法:Self-PrincipledCritiqueTuning(SPCT),用于提升通用奖励模型在推理阶段的可扩展性,并由此训练出DeepSeek-GRM系列模型。同时,他们进一步引入了一种元奖励模型(metaRM),使DeepSeek-GRM的推理效果在超越传统投票机制的基础上得到进一步提升。

实验证明,SPCT在生成质量和推理阶段的可扩展性方面,明显优于现有方法,并超过了多个强大的开源模型。

SPCT的训练方案还被应用到更大规模的语言模型上。研究者们发现推理阶段的扩展性收益甚至超过了通过增加模型规模所带来的训练效果提升。

技术细节

我们一起来看看这篇论文所讨论的技术细节。

Self-PrincipledCritiqueTuning(SPCT)

受到初步实验结果的启发,研究者提出了一种用于逐点通用奖励模型的新方法,能够学习生成具有适应性和高质量的原则,以有效引导批评内容的生成,该方法被称为自我原则批评调整(SPCT)。

如图3所示,SPCT包含两个阶段:

1.拒绝式微调(rejectivefine-tuning),作为冷启动阶段;

2.基于规则的在线强化学习(rule-basedonlineRL),通过不断优化生成的准则和评论,进一步增强泛化型奖励生成能力。

此外,SPCT还能促使奖励模型在推理阶段展现出良好的扩展能力。

研究者们观察到,高质量的准则能够在特定评判标准下有效引导奖励的生成,是提升奖励模型表现的关键因素。然而,对于通用型奖励模型而言,如何自动生成适应性强、指导性强的准则仍是一个核心难题。

为此,他们提出将准则的作用由传统的理解阶段的辅助性输入,转变为奖励生成过程中的核心组成部分。具体而言,这项研究不再将准则仅作为模型生成前的提示信息,而是使模型能够在生成过程中主动生成并运用准则,从而实现更强的奖励泛化能力与推理阶段的可扩展性。

在该研究的设定中,GRM可以自主生成准则,并在此基础上生成对应的批评内容,其过程可形式化表示为:

其中,p_θ表示由参数θ所定义的准则生成函数,该函数与奖励生成函数r_θ共享同一模型架构。这样的设计使得准则可以根据输入的query和响应自适应生成,从而动态引导奖励的生成过程。此外,准则及其对应批评的质量与细粒度可以通过对GRM进行后训练进一步提升。

当模型具备大规模生成准则的能力后,GRM便能够在更合理的准则框架下输出更细致的奖励评价,这对于推理阶段的可扩展性具有关键意义。

基于规则的强化学习

为同步优化GRM中的原则生成与批判生成,DeepSeek提出SPCT框架,整合了拒绝式微调与基于规则的强化学习。拒绝式微调作为冷启动阶段。

拒绝式微调(冷启动阶段)的核心目标是使GRM能够生成格式正确且适配多种输入类型的原则与批判。

不同于Vu等人(2024)、Cao等人(2024)和Alexandru等人(2025)将单响应、配对响应和多响应格式的RM数据混合使用的方案,DeepSeek采用第2.1节提出的逐点GRM,能以统一格式为任意数量响应生成奖励。

数据构建方面,除通用指令数据外,DeepSeek还通过预训练GRM对RM数据中不同响应数量的查询-响应对进行轨迹采样,每个查询-响应对采样次。拒绝策略也采用统一标准:拒绝预测奖励与真实值不符(错误)的轨迹,以及所有次轨迹均正确(过于简单)的查询-响应对。形式化定义为:令表示查询x第i个响应的真实奖励,当预测逐点奖励满足以下条件时视为正确:

这里需确保真实奖励仅包含一个最大值。然而,与Zhang等人(2025a)的研究类似,DeepSeek发现预训练GRM在有限采样次数内难以对部分查询及其响应生成正确奖励。

因此,他们选择性地在GRM提示中追加(称为暗示采样),期望预测奖励能与真实值对齐,同时保留非暗示采样方式。对于暗示采样,每个查询及其响应仅采样一次,仅当预测错误时才拒绝轨迹。相较于Li等人(2024a)和Mahan等人(2024)的研究,我们观察到暗示采样轨迹有时会简化生成的批判(尤其在推理任务中),这表明GRM在线强化学习的必要性和潜在优势。

通过基于规则的在线RL,研究者对GRM进行了进一步的微调。与DeepSeekR1不同的是,没有使用格式奖励。相反,为了确保格式和避免严重偏差,KL惩罚采用了较大的系数。从形式上看,对给定查询x和响应的第i次输出o_i的奖励为:

逐点奖励是从o_i中提取的。

奖励函数鼓励GRM通过在线优化原则和批判来区分最佳响应,从而实现有效的推理时间扩展。奖励信号可以从任何偏好数据集和标注的LLM响应中无缝获取。

SPCT的推理时扩展

为了进一步提高DeepSeek-GRM在使用更多推理计算生成通用奖励方面的性能,研究者探索了基于采样的策略,以实现有效的推理时可扩展性。

利用生成奖励进行投票。回顾第2.1节中的方法,逐点GRM的投票过程定义为奖励总和:

其中,是第i个响应(i=1,…,n)的最终奖励。由于S_i,j通常设置在一个较小的离散范围内,例如{1,…,10},因此投票过程实际上将奖励空间扩大了k倍,并使GRM能够生成大量原则,从而有利于提高最终奖励的质量和粒度。

一个直观的解释是,如果每个原则都可以被视为判断视角的代表,那么更多的原则可能会更准确地反映真实的分布情况,从而提高效率。值得注意的是,为了避免位置偏差和多样性,在采样之前会对回答进行洗牌。

元奖励模型指导投票。DeepSeek-GRM的投票过程需要多次采样,由于随机性或模型的局限性,少数生成的原则和评论可能存在偏差或质量不高。因此,研究者训练了一个元RM来指导投票过程。

引导投票非常简单:元RM对k个采样奖励输出元奖励,最终结果由k_meta≤k个元奖励的奖励投票决定,从而过滤掉低质量样本。

奖励模型Benchmark上的结果

不同方法和模型在奖励模型基准测试上的整体结果如表2所示。

不同方法在推理阶段的扩展性能结果如表3所示,整体趋势可见图1。

表4展示了SPCT各个组成部分所做的消融实验结果。

研究者们还进一步研究了DeepSeek-GRM-27B在推理阶段和训练阶段的扩展性能,通过在不同规模的LLM上进行后训练进行评估。所有模型均在RewardBench上进行测试,结果如图4所示。

更多研究细节,可参考原论文。

推荐阅读

MIT新晋副教授何恺明《计算机视觉进展》课程,附Slides与资料下载

西电IEEEFellow团队出品!最新《Transformer视觉表征学习全面综述》

如何做好科研?这份《科研阅读、写作与报告》PPT,手把手教你做科研

奖金675万!3位科学家,斩获“中国诺贝尔奖”!

最新2022「深度学习视觉注意力」研究概述,包括50种注意力机制和方法!

【重磅】斯坦福李飞飞《注意力与Transformer》总结,84页ppt开放下载!

2021李宏毅老师最新40节机器学习课程!附课件+视频资料

欢迎大家加入DLer-大模型技术交流群!

👆长按识别,邀请您进群!