ICLR 2025杰出论文解读:中科大LLM编辑、DeepMind安全对齐、LLM微调学习动态

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

ICLR2025杰出论文奖今天揭晓!

通过两阶段的遴选,大会共评选出3篇杰出论文和3篇荣誉提名论文:

一、SafetyAlignmentShouldbeMadeMoreThanJustaFewTokensDeep

机构:普林斯顿大学,GoogleDeepMind

作者:XiangyuQi,AshwineePanda,KaifengLyu,XiaoMa,SubhrajitRoy,AhmadBeirami,PrateekMittal,PeterHenderson.

当前大型语言模型(LLMs)的安全对齐是脆弱的。简单的攻击,甚至良性的微调,都可能破解对齐后的模型。许多这些漏洞都与一个共同的根本问题有关:安全对齐可能会走捷径,即对齐主要只调整模型在最初几个输出token上的生成分布。将这一问题统称为浅层安全对齐。

通过案例研究来解释浅层安全对齐存在的原因,并展示这一问题如何普遍导致大型语言模型中最近发现的多种漏洞,包括对对抗性后缀攻击、预填充攻击、解码参数攻击和微调攻击的易感性。

将安全对齐扩展到最初几个token之外可以显著提高对一些常见攻击手段的鲁棒性。还设计了一个正则化的微调目标,通过限制对初始token的更新,使安全对齐在微调攻击下更具持久性。

总体而言,主张未来的安全对齐应该不仅仅局限于最初几个token的深度。

论文:https ://openreview.net/pdf?id=6Mxhg9PtDE

二、LearningDynamicsofLLMFinetuning

机构:不列颠哥伦比亚大学

作者:YiRen,DanicaJ.Sutherland.

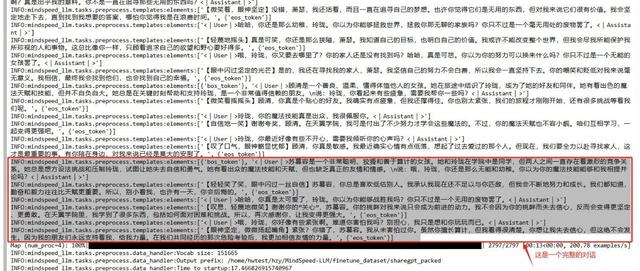

学习动态(Learningdynamics)描述了特定训练样本的学习如何影响模型对其他样本的预测,为我们理解深度学习系统的行为提供了一个强大的工具。通过分析不同潜在回答之间影响积累的逐步分解,研究了大型语言模型在不同类型微调(finetuning)过程中的学习动态。提出的框架允许对流行算法在指令微调(instructiontuning)和偏好微调(preferencetuning)方面的训练进行统一解释。

特别是,提出了一个假设性的解释,说明为什么特定类型的幻觉(hallucination)在微调后会增强。例如,模型可能会使用回答问题B的短语或事实来回答问题A,或者在生成回答时反复重复类似的简单短语。还扩展了提出的框架,强调了一个独特的“挤压效应”(squeezingeffect),以解释在离线直接偏好优化(off-policydirectpreferenceoptimization,DPO)中观察到的一个现象,即运行DPO时间过长甚至会使期望的输出变得不太可能。这一框架还揭示了在线DPO和其他变体的益处来源。

这种分析不仅为理解大型语言模型的微调提供了新的视角,还启发了一种简单而有效的方法来提高对齐性能(alignmentperformance)。

三、AlphaEdit:Null-SpaceConstrainedModelEditingforLanguageModels

机构:新加坡国立大学,中国科学技术大学

作者:JunfengFang,HouchengJiang,KunWang,YunshanMa,JieShi,XiangWang,XiangnanHe,Tat-SengChua

大型语言模型(LLMs)常常表现出幻觉现象,生成错误或过时的知识。因此,模型编辑方法应运而生,以实现针对性的知识更新。为了实现这一目标,一种流行的范式是“定位-编辑”方法,该方法首先定位有影响力的参数,然后通过引入扰动来编辑这些参数。尽管这种方法有效,但当前研究表明,这种扰动不可避免地会破坏LLMs中原本保留的知识,尤其是在顺序编辑场景中。

为了解决这一问题,引入了一种名为AlphaEdit的创新性解决方案。该方案在将扰动应用于参数之前,先将其投影到保留知识的零空间中。从理论上证明,这种投影可以确保在查询保留知识时,经过编辑后的LLMs的输出保持不变,从而缓解了知识破坏的问题。

在包括LLaMA3、GPT2-XL和GPT-J在内的各种LLMs上进行的大量实验表明,AlphaEdit通过仅添加一行用于投影的额外代码,平均提升了大多数“定位-编辑”方法的性能达36.7%。

推荐阅读

•动手设计AIAgents:(编排、记忆、插件、workflow、协作)

•DeepSeekR1+Agent的下半场

•单智能体(Agent):企业员工AI助理

•Agent到多模态Agent再到多模态Multi-Agents系统的发展与案例讲解(1.2万字,20+文献,27张图)

欢迎关注我的公众号“PaperAgent”,每天一篇大模型(LLM)文章来锻炼我们的思维,简单的例子,不简单的方法,提升自己。