中科院提出DEER:让Reasoning提前退出,推理提速50% 准确率涨10%

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

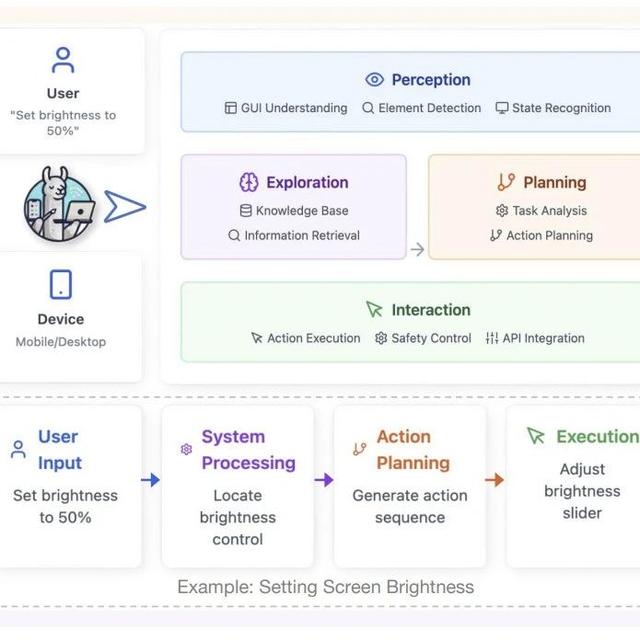

当LLM“想太多”怎么办?

想象你考试时反复验算同一道题,最后反而改错了答案——这就是当前大型语言模型(如ChatGPT的“推理模式”)的困境。它们会像强迫症患者一样生成冗长的推理步骤,不仅拖慢速度,还可能“想太多”导致出错。

论文:DYNAMICEARLYEXITINREASONINGMODELS链接:https ://arxiv.org/pdf/2504.15895

效率低:生成1000字分析只为一个选择题答案

易跑偏:过度推理可能引入错误信息(比如强行给“1+1”编造复杂证明)

75%的题目存在“珍珠推理点”(即提前退出也能答对)

36.7%的题目只需不到一半的推理步骤即可答对

盯梢关键词:监测“Wait”“Alternatively”等思考转折词

诱导试答:遇到转折点时让LLM先“交卷”

信心评估:若试答置信度够高,直接终止思考(其中的置信度计算(简单理解:AI对自己答案的“自信程度”平均值)

举个栗子🌰:AI在解数学题时突然出现“Wait”,DEER会立刻让它输出当前答案。如果此时答案置信度高达99%,就果断喊停,避免后续无效思考。

推理长度缩短31-43%:相当于从写作文变成列提纲

准确率提升1.7-5.7%:少即是多的完美诠释

编程任务更夸张:代码生成长度减少64.9%,通过率反升

用“Alternatively”代替“Wait”作刹车信号,准确率更高但效率稍降

看论文中的经典案例:

原版推理:LLM反复验证导致死循环,最终超时未作答

DEER版:在第一次正确推理后立即刹车,成功得分

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦