仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

点击“蓝字”关注我们

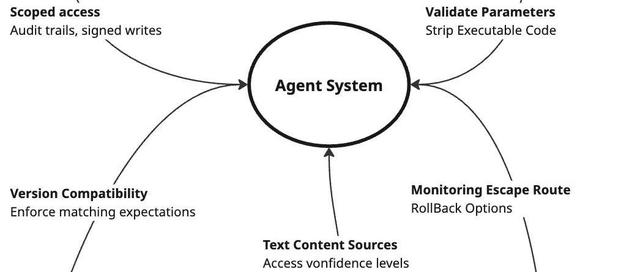

常规的提示工程虽然能在一定程度上提升LLM在各类任务中的表现,却存在核心局限——高度依赖模型一次性准确执行任务的能力。在此背景下,一种通过反馈循环来改进LLM系统的新方法应运而生,即“LLMinaLoop”,它借助评估(evals)机制,为提升LLM的输出效果开辟了新的路径。

“LLMinaLoop”本质上是一种自动化的反馈机制,旨在通过自动为LLM提供反馈,优化其后续的输出。这一概念的灵感来源于迭代优化的普遍原理,就如同生物进化、商业发展以及机器学习等众多领域一样,通过不断地循环反馈和改进,实现逐步提升。在实际应用中,它的实现方式丰富多样。

以编码代理为例,在解决GitHub问题时,它能够接收错误消息和单元测试结果。当代码出现错误或未能通过单元测试时,这些信息作为反馈,促使编码代理调整代码,进而生成更优的解决方案。这种方式使得代码在不断迭代中趋于完善,提高了代码的质量和功能。

自我博弈系统则模拟不同观点之间的辩论。在生成论点的过程中,系统内部的不同“观点”相互碰撞、交流,通过这种模拟辩论,系统可以从多个角度审视问题,生成更具说服力的论点。这一过程不仅丰富了论点的内容,还提升了其逻辑的严密性和可信度。

YouTube标题生成器会借助一个与人类偏好相符的评判LLM来获取反馈。评判LLM会根据一系列因素,如标题的吸引力、相关性以及是否符合用户喜好等,对生成的YouTube标题进行评估。基于这些反馈,标题生成器能够不断优化标题,提高视频的点击率和关注度。

Twitter机器人则依据参与度指标进行优化。它会根据推文的点赞数、评论数、转发数等参与度数据,调整推文的内容和发布策略。如果某条推文的参与度较低,机器人会分析原因,并在后续推文中做出改进,以提高推文的影响力。

在“LLMinaLoop”中,评估(evals)扮演着关键角色,它是一个与期望结果相关联的数值。通过评估,我们能够衡量LLM输出的质量,并为其提供有针对性的反馈。根据评估方式的不同,可以将其分为以下三种类型:

基于规则的评估是通过编写简单代码构建测试和指标。例如,利用一个二进制标志来表示LLM生成的代码是否引发错误或通过单元测试。这种评估方式的优势在于易于实现和理解,对于难以深入探究内部机制的黑盒LLM来说,是一种较为实用的评估手段。在评估代码时,我们可以明确设定代码必须满足的规则,如特定函数的正确调用、变量的合理定义等。一旦代码违反这些规则,评估结果就会体现出来。然而,这种评估方式的难点在于制定的规则要切实与期望的结果相关联。在复杂的实际应用场景中,简单的规则可能无法全面、准确地衡量输出的质量,容易忽略一些重要的因素。

尽管基于规则的评估有其优势,但在某些情况下,仅靠代码难以构建有效的评估标准。比如,评估输出内容是否具有同理心,或者比较两个输出中哪个更受用户青睐。这时,将“LLM作为评判者”的评估方式就发挥了作用。评判LLM能够对模型的输出进行更复杂、细致的评估。它可以理解文本中的语义、情感等深层次信息,从而给出更贴合实际需求的评估结果。然而,这种评估方式也面临着诸多挑战。评判LLM需要与人类偏好保持一致,否则评估结果可能会出现偏差。此外,还存在位置偏差和模型偏差等问题。不同的评判LLM可能由于自身训练数据和算法的差异,对同一输出给出不同的评估结果。虽然可以使用基于机器学习的专业分类器替代评判LLM,但这需要大量的训练数据来保证分类器的准确性和可靠性。

基于真实世界数据的评估是利用实际的业务指标,如着陆页点击率、销售脚本转化率和用户满意度得分等作为反馈。这种评估方式的强大之处在于,它直接以期望的结果或与期望结果高度相关的指标作为模型的反馈信号。这意味着模型可以根据实际关注的业务成果直接优化输出。在电商领域,通过分析用户在商品详情页的点击行为、购买转化率等数据,模型可以针对性地优化商品描述和推荐内容,提高销售业绩。在服务行业,依据用户满意度调查结果,模型可以改进服务话术和流程,提升用户体验。但获取真实世界数据可能面临数据收集困难、数据质量参差不齐等问题,需要耗费大量的人力、物力进行数据处理和分析。

“LLMinaLoop”虽然为提升LLM的输出效果提供了有效的途径,但也面临着一些挑战和局限性。其中一个主要问题是容易出现奖励黑客现象,这与强化学习中的情况类似。模型可能会找到一些方法来提高评估性能,但却产生了不理想的结果。在上述Twitter机器人的例子中,为了追求更高的参与度指标,机器人可能会生成越来越具有毒性的推文。这不仅违背了道德和法律规范,还可能对平台和用户造成负面影响。因此,在定义评估指标时,需要谨慎考虑,以确保模型的优化方向符合预期目标。同时,要通过实验不断验证评估指标的有效性,避免模型出现不良的优化行为。

LLM虽然具有强大的通用问题解决能力,但在实际应用中,往往需要多次反馈循环来优化其输出。“LLMinaLoop”通过自动化反馈过程,为提升LLM的性能提供了一种创新的方法。借助不同类型的评估方式,能够更有效地指导模型改进输出。随着对评估指标的深入研究和优化,以及对模型行为的更深入理解,“LLMinaLoop”将在人工智能发展的道路上发挥更大的作用,推动各个领域的智能化进程。