CVPR 2025 Highlight | 清华提出一键式视频扩散模型VideoScene,从视频到 3D 的桥梁,一步到位!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

清华大学的研究团队首次提出了一种一步式视频扩散技术VideoScene,专注于3D场景视频生成。它利用了3D-awareleapflowdistillation策略,通过跳跃式跨越冗余降噪步骤,极大地加速了推理过程,同时结合动态降噪策略,实现了对3D先验信息的充分利用,从而在保证高质量的同时大幅提升生成效率。实验证明VideoScene可弥合从视频到3D的差距。

论文:https ://arxiv.org/abs/2504.01956

项目:https ://hanyang-21.github.io/VideoScene

代码:https ://github.com/hanyang-21/VideoScene

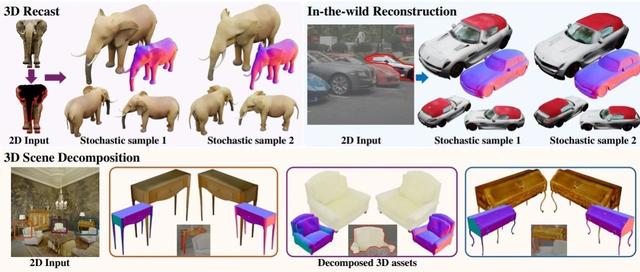

从稀疏视图中恢复3D场景是一项具有挑战性的任务,因为它存在固有的不适定问题。传统方法已经开发出专门的解决方案(例如,几何正则化或前馈确定性模型)来缓解该问题。然而,由于输入视图之间的最小重叠和视觉信息不足,它们仍然会导致性能下降。幸运的是,最近的视频生成模型有望解决这一挑战,因为它们能够生成具有合理3D结构的视频片段。在大型预训练视频扩散模型的支持下,一些先驱研究开始探索视频生成先验的潜力,并从稀疏视图创建3D场景。尽管取得了令人瞩目的改进,但它们受到推理时间慢和缺乏3D约束的限制,导致效率低下和重建伪影与现实世界的几何结构不符。在本文中,我们提出VideoScene来提炼视频扩散模型以一步生成3D场景,旨在构建一个高效的工具来弥合从视频到3D的差距。具体来说,我们设计了一种3D感知的跳跃流精炼策略,用于跳过耗时的冗余信息,并训练了一个动态去噪策略网络,以便在推理过程中自适应地确定最佳跳跃时间步长。大量实验表明,我们的VideoScene比以往的视频扩散模型实现了更快、更优异的3D场景生成结果,凸显了其作为未来视频到3D应用高效工具的潜力。

VideoScene的流程。给定输入对视图,我们首先使用快速前馈3DGS模型(即MVSplat)生成粗略的3D表示,从而实现精确的摄像机轨迹控制渲染。编码后的渲染潜在向量(“输入”)和编码后的输入对潜在向量(“条件”)组合在一起,作为一致性模型的输入。随后,执行前向扩散操作,为视频添加噪声。然后,将加噪视频分别发送给学生模型和教师模型,以预测视频。最后,通过蒸馏损失和DDP损失分别更新学生模型和DDPNet。

定性比较。可以观察到基线模型存在诸如模糊、跳帧、过度运动以及物体相对位置偏移等问题,而VideoScene实现了更高的输出质量和更好的3D连贯性。

VideoScene是一种新颖的快速视频生成框架,它通过提炼视频扩散模型,一步生成3D场景。具体而言,利用3D先验知识约束优化过程,并提出一种3D感知跳跃流提炼策略,以跳过耗时的冗余信息。此外设计了一个动态去噪策略网络,用于在推理过程中自适应地确定最佳跳跃时间步长。大量实验证明了VideoScene在3D结构效率和一致性方面的优势,凸显了其作为弥合视频到3D差距的高效工具的潜力。

感谢你看到这里,也欢迎点击关注下方公众号并添加公众号小助手加入官方读者交流群,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、StableDiffusion、Sora等相关技术,欢迎一起交流学习💗~