阿里发布多模态UniME:硬负样本+知识蒸馏=性能天花板,准确率暴涨27%

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

为什么传统模型不够用?

多模态模型(比如大家熟悉的CLIP)在图像-文本匹配任务中表现不错,但存在三大硬伤:

文本截断:只能处理77个token,长文本直接“被砍头”;

孤立编码:图片和文本分开处理,缺乏深度交互;

组合性差:像“红色汽车+蓝色天空”这种复杂描述,模型容易“丢三落四”。

而最近爆火的多模态大模型(如LLaVA、Qwen-VL),虽然能理解复杂指令,但它们的“嵌入表示能力”却鲜有人研究——就像学霸会解题,但不会总结考点。

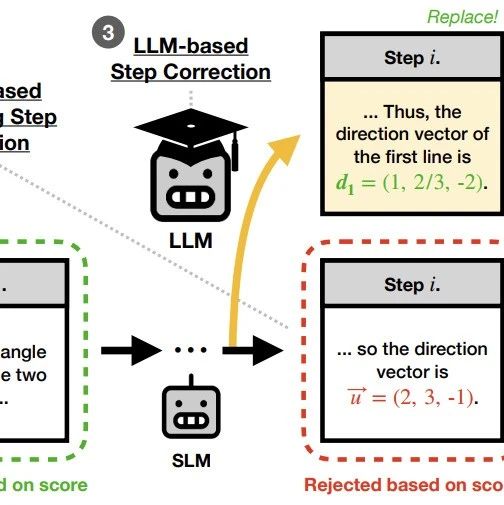

论文提出了UniME(通用多模态嵌入模型),用两阶段训练法突破瓶颈:

目标:提升语言组件的判别能力。

方法:用一个强大的纯文本模型(老师)教多模态模型(学生)如何生成高质量的文本嵌入。

散度(学生嵌入分布老师嵌入分布)

痛点:普通训练用的负样本太简单(比如用“猫”匹配“狗”),模型学不到真本事。

解决方案:

过滤假负样本:比如“红色汽车”和“猩红轿车”其实是同义词,不能当负样本;

专挑硬骨头:在每批数据中,给每个样本找8个最像正样本的“高仿负样本”(比如“红色汽车vs红色卡车”)。

论文在多个任务中验证了UniME的优越性:

结果:UniME在36个数据集上平均精度比CLIP高27.4%,比当前最优模型VLM2Vec高3.3%。

关键发现:硬负样本让模型在“刁钻问题”上表现更稳。

长文本:在Urban1K数据集上,UniME比EVA-CLIP高18.1%,因为传统模型被77个token限制“憋坏了”;

组合检索:比如区分“猫追老鼠”和“老鼠追猫”,UniME准确率提升9.1%。

搜索增强:电商平台用UniME可以更精准匹配图文商品;

内容审核:识别图文不一致的违规内容(比如“健康食品”配垃圾食品图);

教育领域:自动生成图文并茂的考点总结。

动态硬负样本:自动调整采样策略,避免人工调参;

多模态知识蒸馏:不仅蒸馏文本,还要蒸馏视觉特征;

轻量化部署:让UniME能跑在手机端,随时随地“辨图识文”。

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦