Tiny Reasoning模型:LoRA+RL=9美元训练费,性能碾压同行

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

低成本也能训练“聪明”小模型?Tina的野心

当前大语言模型动辄千亿参数,训练成本高达数百万美元,但Tina团队反其道而行——用1.5B参数的“迷你”模型,搭配创新方法,实现低成本高效推理。

核心问题:如何让小模型像学霸一样会解题?传统方法要么依赖昂贵的人工标注数据,要么需要全参数训练(相当于给模型换全身器官),成本极高。Tina的目标是——只给模型“微整形”,花小钱办大事。

论文:Tina:TinyReasoningModelsviaLoRA链接:https ://arxiv.org/pdf/2504.15777

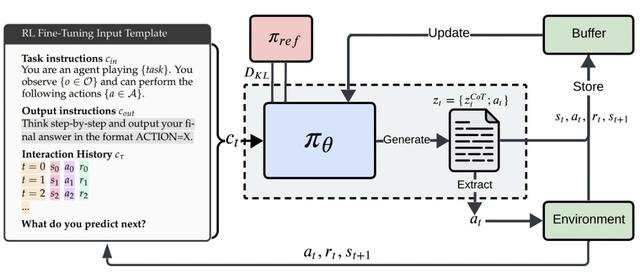

LoRA技术:想象给模型穿一件可调节的轻便外套。传统训练要修改所有参数(相当于换全身衣服),而LoRA只需在关键层叠加两个小矩阵(外套),训练成本骤降。

公式简化版:原模型输出=基础参数×输入LoRA增强后=基础参数×输入+小矩阵A×小矩阵B×输入

强化学习(RL):让模型像考试刷题一样,通过试错学习解题步骤。每做对一步得奖励,最终形成“推理肌肉记忆”。

Tina在多个数学推理任务(如AIME、AMC)中表现亮眼:

成本:最佳模型训练+评估仅需9美元(约一杯奶茶钱),比传统方法便宜260倍。

性能:部分任务准确率超全参数模型20%,例如AIME24达到43.33%Pass@1(人类考生水平约50-60%)。

“格式学习”假说:LoRA擅长让模型快速掌握“答题格式”。比如数学题需要分步骤推导,LoRA调整模型输出结构,而保留原有知识库,相当于教会学生“先写解,再分步计算”的应试技巧。

训练阶段转折点:

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦