直播预约 | LUFFY:让推理模型实现“即学即用”的强化学习训练方法

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

LUFFY:让推理模型实现“即学即用”的强化学习训练方法

2025.4.2920:00北京时间

paper:LearningtoReasonunderOff-PolicyGuidancelink:https ://arxiv.org/abs/2504.14945

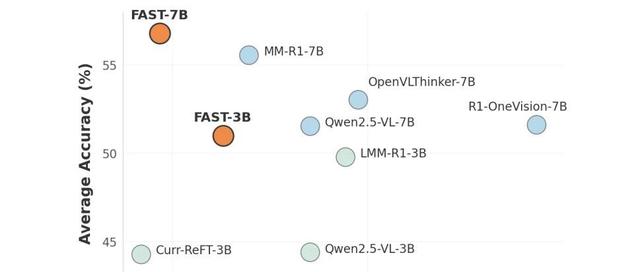

大型推理模型(LRMs)的最新进展表明,通过使用简单的基于规则的奖励进行强化学习(RL),可以形成诸如多步推理和自我反思等复杂行为。然而,现有的零强化学习(zero-RL)方法本质上是”同策略”(on-policy)的,这限制了模型只能从自身输出中学习,无法获得超出其初始能力的推理能力。我们提出了LUFFY(在离策略指导下学习推理,LearningtoreasonUnderoFF-policYguidance),这是一个通过离策略推理轨迹来增强零强化学习的框架。LUFFY在训练过程中通过结合离策略示范和同策略推演,动态平衡模仿和探索。值得注意的是,我们提出了通过正则化重要性采样进行策略塑造,以避免混合策略训练中的表面和僵化模仿。LUFFY在六个数学基准测试中平均提高了7.0分,在分布外任务中提升6.2分。它还大幅超越了基于模仿的监督微调(SFT),特别是在泛化能力方面。分析表明,LUFFY不仅能有效模仿,还能探索超越示范的空间,为使用离策略指导训练可泛化的推理模型提供了一条可扩展的路径。

颜建昊,西湖大学张岳老师的博士三年级学生。主要研究兴趣在基于大模型的后训练技术,包括强化学习、在线学习以及模型编辑等。在读博之前,颜建昊曾在微信AI任研究员,曾赢得WMT机器翻译比赛。

李雅夫博士,现任上海浦江实验室研究员,研究方向涵盖大语言模型推理、可信人工智能与机器翻译。他于浙江大学与西湖大学联合培养攻读博士学位,先后在爱丁堡大学与武汉大学获得人工智能硕士和电子信息工程学士学位。李雅夫博士在ACL、EMNLP、ICLR等顶级会议上发表多项研究成果,引用逾1800次,曾荣获ACL2023最佳论文提名,并担任ACL领域主席及多个国际顶会与期刊的审稿人。博士期间,他曾获得国家奖学金,入选腾讯犀牛鸟精英人才计划并获得杰出奖学金。

欢迎加入NICE每周分享交流群,可与NICEer唠嗑,以及第一时间收到后续NICE分享报告的通知。加群通过小助手认证,群内无广告。