重磅发布 | 复旦《大规模语言模型:从理论到实践(第2版)》全新升级,聚焦AI前沿

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

机器之心发布

机器之心编辑部

《大规模语言模型:从理论到实践(第2版)》是一本理论与实践并重的专业技术书,更是AI时代不可或缺的知识工具书。任何人都能在本书中找到属于自己的成长路径。

在人工智能浪潮席卷全球的今天,大语言模型正以前所未有的速度推动着科技进步和产业变革。从ChatGPT到各类行业应用,LLM不仅重塑了人机交互的方式,更成为推动学术研究与产业创新的关键技术。

面对这一飞速演进的技术体系,如何系统理解其理论基础、掌握核心算法与工程实践,已成为每一位AI从业者、研究者、高校学子的必修课。

2023年9月,复旦大学张奇、桂韬、郑锐、黄萱菁研究团队面向全球学术界与产业界正式发布了《大规模语言模型:从理论到实践》。短短两年,大语言模型在理论研究、预训练方法、后训练技术及解释性等方面取得了重要进展。业界对大语言模型的研究更加深入,逐渐揭示出许多与传统深度学习和自然语言处理范式不同的特点。例如,大语言模型仅需60条数据就能学习并展现出强大的问题回答能力,显示了其惊人的泛化性。然而,本书作者们也发现大语言模型存在一定的脆弱性。例如,在一个拥有130亿个参数的模型中,仅修改一个特定参数,就可能导致模型完全丧失生成有意义信息的能力。

这些发现促使本书的作者「复旦大学NLP团队」张奇、桂韬、郑锐、黄萱菁几位老师对本书第1版进行大幅修订升级(增加内容超过40%),系统整合AI领域最新研究成果与技术进展,为广大读者带来更前沿、更实用的知识体系与工程实践指导。无论你是渴望深入理解LLM原理的学者,还是希望将AI能力融入产品的工程师,亦或是对人工智能充满兴趣的学习者,这本书都将为你提供系统、权威且极具实操价值的知识指引。

第二版核心升级

聚焦前沿技术

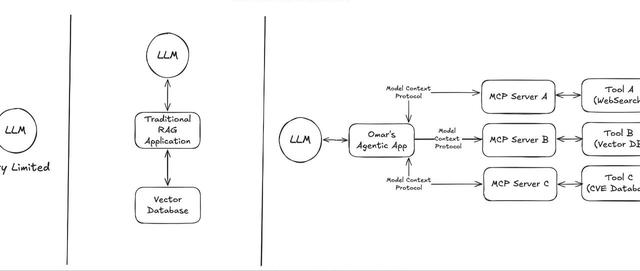

深度剖析MoE(混合专家模型)、强化学习、多模态、智能体、RAG(检索增强生成)、效率优化等技术趋势,紧跟AI最新发展。

重构知识体系

覆盖预训练、微调、强化学习、应用开发、效率优化等全流程,体系更加完善,逻辑更清晰。

提升实践价值

新增逾40%的前沿研究成果与技术案例,增设工程实践指南与评估体系模块,助力理论落地。

扩展章节内容

新增多模态大语言模型、智能体、RAG、大模型效率优化等实用章节,并对指令微调和强化学习部分进行了大幅修改。

本书架构

围绕LLM理论基础、预训练、指令理解、大模型增强、大模型应用五大部分展开。

第1部分介绍大语言模型的基础理论:包括语言模型的定义、Transformer结构、大语言模型框架、混合专家模型等内容,并以LLaMA使用的模型结构为例介绍代码实例。

第2部分介绍大语言模型的预训练,包括大语言模型预训练数据和分布式训练。该部分介绍了预训练需要使用的数据分布和数据预处理方法。除此之外,还介绍模型分布式训练中需要掌握的数据并行、流水线并行、张量并行及ZeRO系列优化方法。并以DeepSpeed为例介绍如何进行大语言模型预训练。

第3部分介绍大语言模型如何理解并服从人类指令,包括指令微调和强化学习。重点介绍模型微调技术、指令微调数据的构造策略,以及高效微调方法,如LoRA、DeltaTuning等方法。强化学习章节重点讲解其基础理论、策略梯度方法(REINFORCE算法、广义优势估计、PPO算法、PLOO算法、GRPO算法),推理模型的强化学习(以DeepSeek-R1和Kimik1.5为例),RLHF等,并结合实际案例,以DeepSpeed-Chat和verl框架为例,详细说明如何训练类ChatGPT系统。

第4部分围绕提升大语言模型的能力展开详细探讨,内容涵盖多模态大语言模型、大模型智能体和检索增强生成。多模态大语言模型章节重点介绍其基础理论、架构设计与训练策略,并探讨其在实际场景中的应用实践。智能体章节聚焦其发展历程与大语言模型智能体的架构设计,深入分析智能体的实现原理,并以LangChain和Coze为例详细阐述具体实践。RAG章节介绍其核心思想与实现方式,涵盖检索增强框架的设计、检索模块与生成模块的协作机制,以及其在具体任务场景中的应用方法与实践。

第5部分围绕如何应用大语言模型展开讨论,内容涵盖大语言模型效率优化、大语言模型评估,以及大语言模型典型应用的开发与部署。效率优化章节重点介绍模型压缩与优化、训练效率优化和推理效率优化等提升模型效率的关键技术。大语言模型评估章节探讨其基本概念和难点,阐述评估体系的构建、评估方法的设计及实际评估的实施。大语言模型应用章节介绍典型的大语言模型应用场景,详细介绍其开发流程、开发工具及本地部署的实践方法。

新增章节亮点

多模态大语言模型:介绍典型架构及其与LLM的融合方法、多模态训练策略。

大模型智能体:剖析涵盖感知、规划、记忆机制及工具调用能力的核心架构,训练与实践方法。

检索增强生成(RAG):解析系统设计模式、训练优化策略、评估体系全流程。

大模型效率优化:围绕模型压缩、低精度训练、高效推理框架(如vLLM)等全链路技术实践展开。

大语言模型基础:新增混合专家模型(MoE)相关内容。

强化学习:新增对「TheBitterLesson」的理解、长思维链、推理模型的强化学习等内容。

作者团队简介

本书作者团队由来自复旦大学的张奇、桂韬、郑锐、黄萱菁等多位人工智能领域的优秀学者组成。团队长期专注于自然语言处理、大规模预训练模型、智能体、多模态学习等前沿方向,具备丰富的理论研究与工程实践经验。

张奇,复旦大学计算机科学技术学院教授、博士生导师。兼任上海市智能信息处理重点实验室副主任,中国中文信息学会理事、CCF大模型论坛常务委员,CIPS信息检索专委会常务委员、CIPS大模型专委会委员。近年来在国际重要学术期刊和会议上发表论文200余篇。获得WSDM2014最佳论文提名奖、COLING2018领域主席推荐奖、NLPCC2019杰出论文奖、COLING2022杰出论文奖。

桂韬,复旦大学副研究员。研究领域为预训练模型、类人对齐和智能体交互。在国际重要学术期刊和会议上发表论文50余篇,主持国家自然科学基金计算机学会和人工智能学会的多个人才项目。获得钱伟长中文信息处理科学技术一等奖、NeurIPS2023大模型对齐Track最佳论文奖,入选第七届「中国科协青年人才托举工程」、上海市启明星计划。

郑锐,博士毕业于复旦大学计算机科学技术学院,师从张奇教授。曾任字节跳动豆包大模型团队算法工程师,现就职于某前沿科技公司,研究方向为大模型对齐、复杂推理能力提升。获得NeurIPSWorkshoponInstructionFollowing2024最佳论文奖。在ICLR、ICML、NeurIPS、ACL等国际会议上发表多篇论文。

黄萱菁,复旦大学特聘教授、博士生导师。主要从事人工智能、自然语言处理和大语言模型研究。兼任中国计算机学会理事、自然语言处理专委会主任、中国中文信息学会理事、计算语言学学会亚太分会主席。在国际重要学术期刊和会议上发表论文200余篇,获优秀论文奖8项。获得钱伟长中文信息处理科学技术一等奖、上海市育才奖,以及人工智能全球女性学者、福布斯中国科技女性等多项荣誉。

专家点评

自《大规模语言模型:从理论到实践》首版问世以来,便受到了学术界与产业界的广泛关注。此次全新升级的第二版,内容更加丰富、体系更加完善,得到了多位人工智能领域权威专家的高度认可(按姓氏拼音排序):

「随着ChatGPT的问世,大语言模型展现出巨大潜力,对人工智能发展产生了深远影响。面对这一迅速发展的技术,如何快速理解其理论并参与实践是我们必须要面对的挑战。本书在第1版的基础上增加了多模态、智能体、RAG等章节,并对指令微调和强化学习部分进行了大幅修改,旨在帮助读者深入理解大语言模型的原理,提供实操指导,值得阅读。」

——柴洪峰中国工程院院士

「本书深入解析了大语言模型的基本原理,分析了当前几种有代表性的大语言模型的学理特点,分享了作者在这一领域的实践经验。本书的出版恰逢其时,是学术界和产业界不可多得的读物,将助力读者进一步探索和应用大语言模型。」

——蒋昌俊中国工程院院士

「本书全面解析了大语言模型的发展历程、理论基础与实践方法,对大语言模型预训练、指令微调、强化学习、多模态、智能体、RAG等前沿领域的研究进展有较好的覆盖。此外,本书深入探讨了大语言模型的实际应用场景与评价方法,为研究者提供了系统的理论指导与实践经验。相信本书对从事相关研究的学者和大语言模型开发者具有重要的参考价值。」

——周伯文上海人工智能实验室主任、首席科学家、清华大学惠妍讲席教授

《大规模语言模型:从理论到实践(第2版)》的出版上市,希望可以让读者快速掌握大语言模型的研究与应用,更好地应对相关技术挑战,为推动这一领域的进步贡献力量。

©THEEND

转载请联系本公众号获得授权

投稿或寻求报道:liyazhou@jiqizhixin.com