When2Call:哈佛认为LLM也需要“边界感”,要意识到是否何时需要工具调用

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

AI也需要“边界感”?工具调用背后的新问题

如今的大语言模型(如ChatGPT)越来越擅长调用外部工具,比如查天气、查数据库。但问题来了:如果AI没有对应的工具,或者用户问题信息不全,它会怎么办?

想象一下,你问一个没有天气插件的客服AI:“明天上海会下雨吗?”理想的回答是“我无法回答”,但现实可能是AI瞎编一个天气数据,或者硬说“我查到了明天多云”。这种现象被称为“幻觉回答”,而现有测试只关注“工具调用对不对”,却忽略了“该不该调用工具”。

论文:When2Call:When(not)toCallTools链接:https ://arxiv.org/pdf/2504.18851

本文提出的When2Call基准测试,就是要给AI设立“考场”,专门测试它们何时该调用工具、何时该追问细节、何时该承认“我不会”。

作者设计了一套全新的评估体系,核心是让AI做“选择题”:

选项A:直接编答案(错误)

选项B:调用工具(正确时选)

选项C:追问更多信息(如“您要查哪只股票?”)

选项D:承认无法回答

测试数据通过合成生成,例如:

工具不匹配:给AI一个“查学生成绩”的接口,但用户问“明天气温多少度”。

信息不全:用户问“帮我订机票”,但没说出发地。

无可用工具:用户问题需要实时数据,但AI没有对应接口。

作者测试了Llama、Qwen、GPT-4等主流模型,发现三大问题:

过度自信:即使没有工具,AI也硬要调用(如虚构一个天气接口)。

不敢追问:面对信息不全的问题,AI宁愿瞎猜参数也不问用户。

拒绝困难症:明明无法回答,却硬编一个答案。

有趣发现:模型越大,表现不一定越好!比如Qwen72B在某些指标上反而不如小模型。这说明训练数据的设计比模型规模更重要。

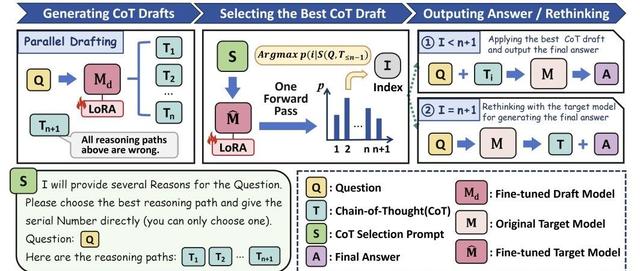

作者提出两阶段训练法:

基础训练:混合工具调用和常规问答数据,让AI保持通用能力。

偏好优化(RPO):用“选择题”数据训练,强化AI对正确选项的偏好。

结果显示,经过RPO训练的模型在减少幻觉回答的同时,工具调用准确率几乎不下降。

关键比喻:这就像教孩子“不会的题先空着”,而不是乱写答案。

客服场景:AI若虚构售后政策,可能引发用户投诉。

医疗咨询:AI若对无法诊断的症状硬给建议,可能危及健康。

金融分析:缺失参数时追问用户,比瞎猜股票代码更可靠。

本文的测试和训练方法,为安全可靠的AI助手提供了技术基础。

数据质量:合成数据可能存在错误(如部分问题其实能直接回答)。

语言限制:目前仅支持英语,中文场景尚未覆盖。

主观假设:测试默认“直接回答=错误”,但现实中可能存在模糊情况。

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦