图像编辑革命,浙大提出Insert Anything,告别PS抠图,万物皆可插入!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

以下文章来源于微信公众号:AIGCStudio

作者:AIGCStudio

链接:https ://mp.weixin.qq.com/s/keRr5T8qguXNT00UJuRekQ

本文仅用于学术分享,如有侵权,请联系后台作删文处理

导读

本文将为大家介绍一个通用图像插入框架InsertAnything,它可在灵活控制下将参考图像中的对象自然融合至目标场景。该方法基于新构建的AnyInsertion数据集训练,结合扩散变换器与上下文编辑机制,在多个任务上表现优异,展现出广泛的应用潜力。

浙江大学、哈佛大学、南洋理工大学联合提出了统一的图像插入框架InsertAnything,支持多种实际场景,包括艺术创作、逼真的脸部交换、电影场景构图、虚拟服装试穿、配饰定制和数字道具更换,下图展示了其在各种图像编辑任务中的多功能性和有效性。

论文:https ://arxiv.org/pdf/2504.15009

主页:https ://song-wensong.github.io/insert-anything

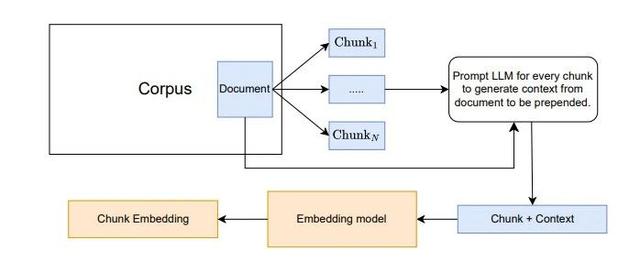

本研究提出了“InsertAnything”,这是一个基于参考的图像插入统一框架,可在用户指定的灵活控制指导下将参考图像中的对象无缝集成到目标场景中。我们的方法并非针对单个任务训练单独的模型,而是在我们新的AnyInsertion数据集上训练一次——该数据集包含12万个提示图像对,涵盖人物、物体和服装插入等多种任务——并可轻松推广到各种插入场景。如此具有挑战性的设置需要捕捉身份特征和精细细节,同时允许在样式、颜色和纹理方面进行灵活的局部调整。为此,我们建议利用扩散变换器(DiT)的多模态注意力机制来支持蒙版和文本引导的编辑。此外,论文引入了一种上下文编辑机制,将参考图像视为上下文信息,采用两种提示策略使插入的元素与目标场景协调一致,同时忠实地保留其独特特征。在AnyInsertion、DreamBooth和VTON-HD基准上进行的大量实验表明,提出的方法始终优于现有的替代方案,凸显了其在创意内容生成、虚拟试穿和场景合成等实际应用中的巨大潜力。

InsertAnything是一个基于参考的图像插入统一框架,它通过支持蒙版和文本引导控制,克服了专用方法的局限性,适用于各种插入任务。利用新开发的包含12万个提示图像对的AnyInsertion数据集以及DiT架构的功能实现了创新的上下文编辑机制,该机制采用双联画和三联画提示策略,能够有效地保留身份特征,同时保持插入元素与目标场景之间的视觉和谐。在三个基准测试上进行的大量实验表明,提出的方法在人物、物体和服装插入方面始终优于最先进的方法,为基于参考的图像编辑树立了新标杆,并为现实世界的创意应用提供了通用的解决方案。

欢迎加入《AI未来星球》,一起成长

扫描下方二维码即可加入~

你可以获得什么?

1、大白之前花费10W+购买,AI行业各场景私有数据集下载,星球内倾情分享;2、AI行业研发、产品、商业落地问题咨询(目前AI公司创业中),都可获高质量解答,有效期一年,无限次提问,有问必答。3、定期邀请AI行业各类嘉宾分享,创业/商业等方面的经验!

帮助你解决遇到的实际问题,升职加薪!

大家一起加油!