小心!你的手机正在偷偷『学做人』——LLM如何让它自主订咖啡、抢优惠?| 手机端GUI Agent综述

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

手机自动化的革命:从「机械操作」到「智能大脑」

想象一下,你对着手机说「帮我订一杯拿铁」,手机自动打开外卖APP、选好咖啡、填写地址并支付——整个过程无需任何手动操作。这就是LLM(大语言模型)驱动的手机GUI代理带来的未来!

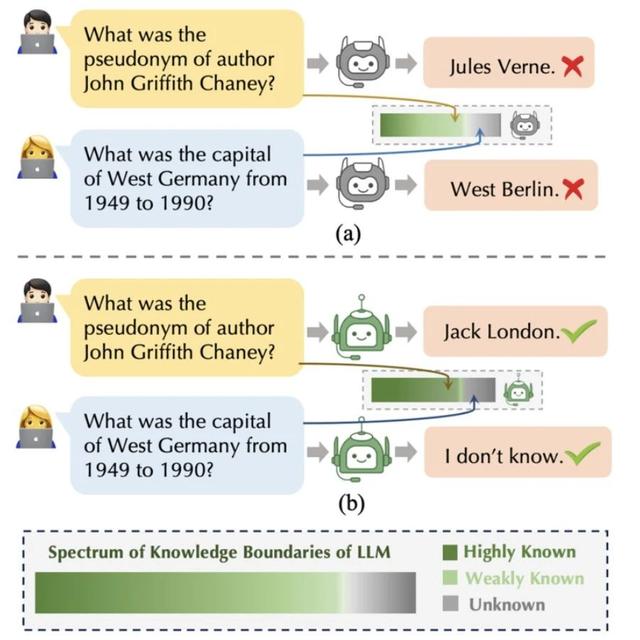

传统自动化(比如iOS的快捷指令)依赖预设脚本,像是「按图索骥」,一旦界面变化就会失效。而LLM赋予了手机「理解意图」「动态决策」的能力,让它像人类一样「看屏幕、点按钮、做判断」。

论文指出,LLM通过语言理解、多模态感知(结合文字、图像、界面结构)和强化学习,让手机自动化从「固定流程」升级为「智能服务」。例如,vivo的PhoneGPT能通过对话完成餐厅预订,荣耀的YOYO能根据用户习惯自动比价购物。

传统自动化技术有四个致命缺陷:

死板:脚本只能处理特定APP的固定界面,换个按钮位置就失效。

维护贵:每次APP更新都要重写脚本,费时费力。

听不懂人话:无法理解复杂指令(比如「明早下雨就关闹钟」)。

看不懂屏幕:难以识别动态弹窗、图标等非标准控件。

举个例子,传统自动化工具可能连「微信扫码登录」都做不到,因为扫码按钮的位置和样式因场景而异。而LLM能像人类一样「观察屏幕」,结合上下文找到正确操作路径。

LLM驱动的手机代理有两大核心技术:

通过精心设计的提示词,让预训练模型「无师自通」。例如,将屏幕截图+界面结构+用户指令打包成提示,模型就能生成下一步操作(如点击某个按钮)。

用手机交互数据对模型微调,让它更懂GUI。例如,CogAgent模型通过高分辨率图像识别小图标,ScreenAI学习界面布局与功能关联。

论文还提到一个关键概念:POMDP(部分可观测马尔可夫决策过程)。简单说,手机代理像玩游戏一样,每步根据当前界面(状态)选择操作(动作),逐步逼近目标。这种动态决策让它能应对网络延迟、弹窗干扰等现实问题。

单代理:一个「全能AI」独立完成任务,适合简单操作(如打开设置)。

多代理:多个AI分工协作。例如,PlanningAgent定计划,DecisionAgent执行操作,ReflectionAgent检查纠错,像一支「特工小队」。

Plan-Then-Act(先计划后执行):先制定文字版步骤,再转化为具体操作。比如GPT-4V先规划「打开美团→搜索咖啡店→选择拿铁」,再调用视觉模型定位按钮。

论文列举了多个关键数据集:

Rico:最早的手机界面数据库,包含1.6万个APP截图和结构数据。

AndroidintheWild:30万条真实用户操作记录,覆盖357个APP。

GUIOdyssey:专为跨APP任务设计(如「用地图查路线→用打车软件叫车」)。

评估标准则关注「任务成功率」「操作准确性」「资源消耗」等。例如,LlamaTouch测试床能模拟不同手机型号和网络环境,确保代理的泛化能力。

尽管前景光明,LLM手机代理仍面临四大挑战:

数据瓶颈:需要更多元、跨语言的交互数据。

手机算力限制:如何让大模型在低配设备上流畅运行?

隐私与安全:自动操作可能泄露支付密码等敏感信息。

个性化适配:如何让AI理解不同用户的习惯?(比如「晚睡族」的勿扰模式设置)

论文建议未来结合小型语言模型(SLM)和边缘计算,在本地高效处理任务,同时保护隐私。

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦