仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

自我进化的新范式:用「左右互搏」训练模型!

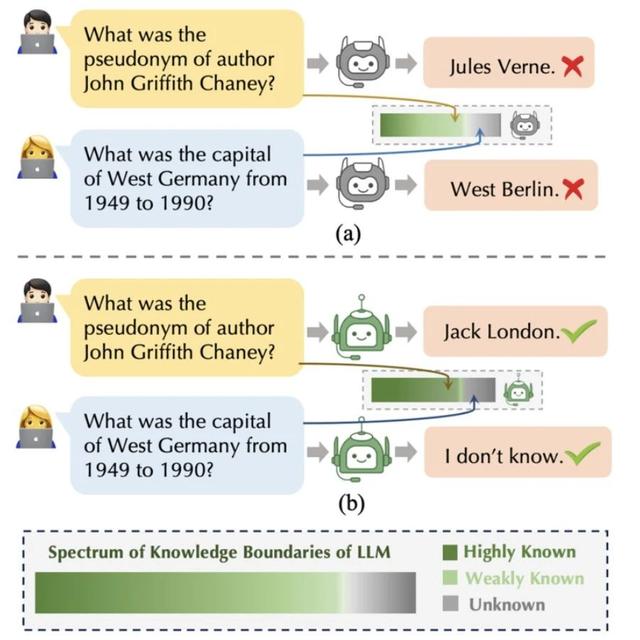

想象两个AI在玩「猫鼠游戏」:一个AI专门制造隐蔽的数学推理错误(比如偷偷把方程里的加号改成减号),另一个AI则化身「福尔摩斯」,火眼金睛揪出错误。这对冤家通过反复对抗,最终双双升级——造假者越来越狡猾,鉴假者越来越敏锐。这就是论文提出的SPC(自我博弈批评器),它让AI摆脱对人工标注的依赖,像人类棋手一样通过「左右互搏」实现进化。

论文:SPC:EvolvingSelf-PlayCriticviaAdversarialGamesforLLMReasoning链接:https ://arxiv.org/pdf/2504.19162

现有推理存在三大难题:

人工标注贵:给每个推理步骤打标签需要数学专家,成本极高

模型更新快:今天标注的数据,明天可能因为模型升级就失效

只能打分不会指导:传统验证模型只能给步骤「判对错」,无法提供具体改进建议

而SPC的对抗训练模式完美避开这些坑:两个AI互相生产训练数据,无需人工介入,还能实时适应最新模型。

这套系统有两个核心角色:

诡计生成器:把正确步骤偷偷改成错误版本,比如故意算错平方根,还要让错误看起来合情合理

鉴假批评家:像老师批改作业一样,逐句检查推理漏洞

它们的训练过程就像打游戏:

生成器成功骗过批评家→生成器+1分,批评家-1分

批评家成功识破诡计→批评家+1分,生成器-1分

通过这种「奖励机制」,两个AI在数万次对抗中螺旋上升。

实验数据让人眼前一亮:

在ProcessBench测试集上,SPC的准确率从70.8%一路涨到77.7%

面对超长推理链时(DeltaBench测试),SPC比传统方法准确率高出近20%

应用到实际解题中,Qwen等主流模型的数学题正确率最高提升23%

更神奇的是,SPC还能实时纠错:当AI在解题过程中刚犯错误,SPC就立即喊停要求重算,而不是等写完所有步骤再打分。

这项技术不仅能提升数学推理:

学术论文自动查错:揪出公式推导中的隐蔽错误

代码审查:发现程序员都容易忽略的逻辑漏洞

假新闻识别:训练鉴假专家打击AI生成的虚假信息

但作者也提醒:如果「诡计生成器」被恶意利用,可能成为制造虚假信息的工具。因此,如何平衡技术进步与社会伦理,将是接下来需要思考的问题。

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦