Transformer原作、斯坦福、清华交大三篇论文共识:基座模型边界锁死RL能力上限

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

作者:蛙哥https ://zhuanlan.zhihu.com/p/1898757199200780434

RL真的让大模型变聪明了吗?我最近读的这几篇论文还挺有意思,底层的逻辑应该是有共识的,就是模型能力的上限在预训练阶段就确定了,当前的RL只是优化选择路径,并没有提升智力上限。

这三篇文章来自不同团队,用的模型也不一样,但从我的视角看,都指出了一个核心事实——大模型的推理能力,其实早在预训练阶段就已经形成了,RL更像是个“采样放大器”。RL不一定让模型更聪明,只是让它更擅长挑选已有的好答案。

斯坦福的《CognitiveBehaviorsthatEnableSelf-ImprovingReasoners》分析的是RL效果的分歧。

研究者发现,同样的RL训练,一个模型(比如Qwen-2.5)提升特别明显,另一个(Llama-3.2)基本没反应。为啥?他们提出了一个概念:认知行为。也就是说,一个模型本身有没有“回溯”“验证”“设子目标”这些能力,决定了它能不能从RL中学到东西。没有这些基础,RL训再久也没用。Qwen2.5和Llama3.2的差别就是Qwen2.5里有大量的所谓认知行为,也就是推理轨迹,而Llama3.2没有,所以你怎么RLLlama3.2他一点都激活不起来推理能力。后来尝试给Llama3.2基座灌了一批推理轨迹数据,再用RL来激活就能力就上来了。国内智源当前正在推进的OpenSeek项目,也buyin了这个点,目前正在预训练阶段大量的刷推理轨迹数据,让模型在基座上就见到足够多的推理路径或者叫“模版”,后训练RL的时候他们相信即使轨迹的内容不对,但是路径的模版足够丰富,也能带来极大的能力提升。

清华《DoesReinforcementLearningReallyIncentivizeReasoningBeyondtheBaseModel?》直接把“RL会提升推理上限”的说法拿出来批判。

他们做了个大规模的pass@k分析,结果是:那些被RL训出来的“好答案”,其实底座模型早就能生成,只是裸用基座被挑中的概率低了点。RL只是让模型更偏向去生成高reward的路径,并没有真正增加推理能力的多样性。这篇论文的几个主要发现

•RLVR未引入新的推理路径:通过手动检查链式思维推理路径,发现RLVR训练的模型生成的推理路径在基模型的输出分布中已存在,表明RLVR并未引入全新的推理能力。说明智力上限在预训练,RL只是激活。

•RLVR提高采样效率但缩小推理边界:RLVR训练使模型倾向于生成高奖励的路径,从而提高了在小k值(如pass@1)下的表现。然而,这种偏向性减少了模型的探索能力,导致在大k值下(如pass@256)基模型的表现反而优于RLVR模型。就是说用基座是的多了,肯定能找到一个更优的答案比RLVR的模型结果更好。

•不同RL算法表现相近,均未达到最优:比较了PPO、GRPO和Reinforce++等RL算法,发现它们在采样效率上的差异较小,且都未达到基模型推理边界所定义的最优采样效率。说明目前RL不注入新数据的情况应该都差不多。

•知识蒸馏能引入新知识,区别于RLVR:与RLVR不同,知识蒸馏可以引入新的推理模式,扩展模型的推理边界。这表明蒸馏在提升模型推理能力方面具有更大的潜力。说明在同样的方法情况下,模型能力提升,还是需要新的数据。

清华这篇论文我的看法是还说明了一个问题,即使推理能力是在基座模型里决定的,但是当前RLVR技术也很难找到最优的推理路径给出最优解,也是个局部最优。所以VR这类方法看起来也是阶段性的方法而已,长期来看如何给RL定义真实世界的评估反馈,才是最终解。

Transformer原作参与的《RethinkingReflectioninPre-training》讲的是“反思”能力,也就是模型能不能在推理过程中发现自己犯了错然后纠正。

作者用一堆刻意掺了错误的推理链去测试模型,发现模型在还没做RL的时候就已经能自己修正不少错误了。训练token越多、模型越大,这种能力越明显。作者用基座模型OLMo-2-7B来证明在未进行RL的阶段,通过在推理阶段适时的塞入一个提示词“wait”,就能触发模型的反思能力,达到RL后模型的效果。

这个效果让我想起来一个叫entropix的开源项目,这个项目通过在推理阶段引入基于熵和变熵的动态采样机制,显著提升了模型在推理任务中的表现,比如根据模型当前的情况,插入CoT提示引导模型深入思考,或者重新采样尝试新的生成路径,出发点和这篇论文大体相似,可惜这个项目去年底就停更了。

总结下来,这三篇文章其实达成了一个RL模型的共识:

1、能力来源(source):

语言模型的推理能力=f(模型架构,token量,训练数据多样性,泛化能力)

2、RL的作用(作用机制):

RL≈一个奖励驱动的路径偏移器

•将已存在于模型分布中的推理路径偏移为更高reward的选项

•提高成功率,但不生成新“知识”或“能力”

3、提升路径(有效方向):

想要获得新的reasoning能力≠强化训练

需要更强的知识/经验(知识注入+架构优化+认知行为引导)

RL不是创造能力,而是优化选择。真正决定模型能走多远的,是底座模型的本体素质,在架构稳定的情况下,最终还是数据。

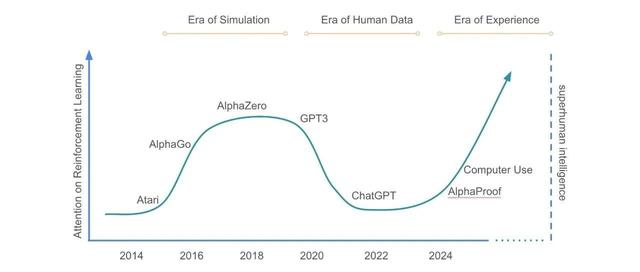

其实前几天OpenAI姚顺雨的《TheSecondHalf》和DeepMind的《TheEraofExperience》这两篇文章里提到的下半场AI训练要关注的评估和体验,我觉得也是和这三篇论文的基调一致。一方面是通过体验与真实世界更好链接,更多的现实世界的数据来源,提高模型基础边界上限;另一方面足够准确的定义评估模型,通过RL技术让模型可以学习到最佳的上限路径,真正把模型能力发挥出来。

进技术交流群请添加AINLP小助手微信(id:ainlp2)

请备注具体方向+所用到的相关技术点

关于AINLP

AINLP是一个有趣有AI的自然语言处理社区,专注于AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括LLM、预训练模型、自动生成、文本摘要、智能问答、聊天机器人、机器翻译、知识图谱、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLP小助手微信(id:ainlp2),备注工作/研究方向+加群目的。