以星为舵:LLM的Post-Train与Test-Time奖励学习综述

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

想象你正在教一个小孩做数学题,每次他答对了,你就给一颗星星贴纸;答错了,就温柔地指出问题。久而久之,小孩会越来越擅长解题,因为他知道哪些行为能获得奖励。

AI的学习也是如此!

这篇论文提出,奖励信号(Reward)就像AI的“导航星”,在训练后和实际使用中不断引导模型优化行为,让它变得更符合人类需求、更擅长复杂推理。

传统模型像“死记硬背的学生”,只通过大量数据学习固定模式;而奖励学习让其变成“主动思考的学霸”,通过动态反馈调整行为。

论文提到,奖励学习的关键是:

奖励信号来源:人类打分、AI自我评价、规则验证(如代码能否运行)

奖励形式:分数(80分)、文字评价(“这段推理有逻辑错误”)、隐式信号(对比答案好坏)

学习策略:强化学习(如PPO算法)、直接优化偏好(如DPO算法)

举个🌰:ChatGPT生成答案后,系统用奖励模型给答案打分,高分答案被保留,低分答案被淘汰,模型逐渐学会“讨好”评分标准。

方法:用奖励信号调整模型参数(类似老师批改试卷)

典型案例:RLHF(人类反馈强化学习)、GRPO(用规则奖励训练数学推理)

关键公式:PPO算法(平衡学习速度与稳定性)

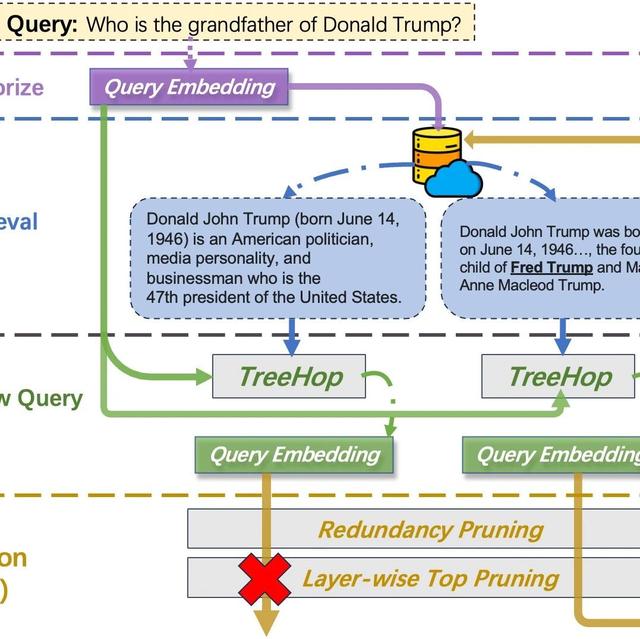

方法:生成多个答案,选奖励最高的(比如生成10个答案,挑最好的)

典型案例:Best-of-N采样、奖励引导解码(类似考试时排除错误选项)

方法:生成答案后,用奖励信号迭代修正(比如先写初稿,再根据反馈修改)

典型案例:Self-Refine(自我反思)、外部工具验证(用编译器检查代码)

论文指出,奖励模型的设计是核心,但面临两大选择:

人类反馈:质量高但成本昂贵(需人工标注)

自动化反馈:可大规模获取但可能“不靠谱”

AI自我评价:让AI自己给答案打分(类似学生自评)

规则验证:代码能否运行、答案格式是否符合要求

工具反馈:用编译器、搜索引擎等外部工具检查结果

关键矛盾:自动化反馈虽高效,但可能教会“钻空子”(比如生成能通过单元测试但实际无效的代码)。

方法:给解题步骤打分(过程奖励),而不仅是最终答案

案例:DeepSeek-R1模型通过规则奖励(如格式正确性)训练出长链推理能力

方法:用编译器反馈作为奖励,训练模型生成可运行代码

案例:CodeRL模型根据单元测试结果优化代码

方法:结合图像、文本的奖励信号,比如图片与描述是否匹配

案例:VLM-R1模型通过强化学习优化视觉问答

其他还包括偏好对齐、Agent等方向。

奖励作弊AI可能找到“刷分捷径”,比如生成看似合理但错误的答案。论文提到,这就像学生为了高分死记硬背,却不真正理解知识。

持续学习当前模型训练后固定不变,未来需让AI在真实环境中动态学习(比如医疗AI根据患者生理信号调整策略)。

通用奖励模型开发能跨任务、多场景的“全能裁判”,而非针对单一任务的专用模型。

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦