社交Agent: 通过RL学习自适应Thinking,根据场景在“秒回”和“深思”间灵活切换

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

当模型开始“察言观色”…

现在的聊天机器人,虽然能写诗、写代码,但在需要“人情世故”的场景里,表现就像钢铁直男——要么无脑秒回,要么长篇大论说废话。比如商业谈判中,对手抛出一个试探性问题,Agent如果花5分钟写小作文分析,可能直接冷场;但若只会敷衍回复,又可能错失良机。

论文指出,现有大模型的思维模式是“一根筋”:要么完全不动脑(直觉反应),要么无论多简单的问题都要写800字小作文(固定长思维链)。而人类社交时,会根据场景在“秒回”和“深思”间灵活切换。

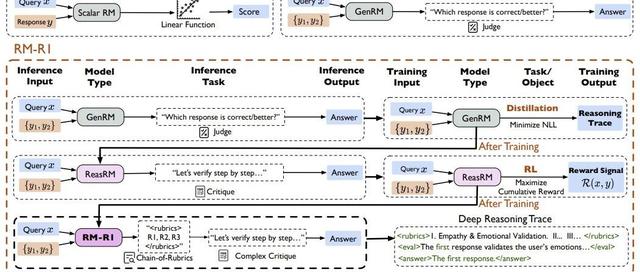

研究团队从脑科学中的分层认知控制理论获得灵感,设计了4种思维模式:

模式1(直觉反应):直接输出答案,适合日常寒暄

模式2(意图分析):分析对方潜台词,比如“他说这话是想压价吗?”

模式3(战略适应):结合历史对话制定策略,像谈判高手

模式4(前瞻推演):模拟多种可能性,像下棋一样走一步看三步

比如在咖啡店偶遇前任的场景:

模式1:“好久不见”(礼貌但空洞)

模式4:“观察对方肢体语言→分析情感状态→模拟三种回应策略→选择最可能达成和解的方案”

核心创新是AMPO强化学习算法,用游戏段位机制理解:

模式级优势:根据场景难度自动选模式

样本级优势:确保同一模式下输出质量

奖励优先当不同模式效果差异大效率优先当效果相同时选最省的模式

在模拟社交任务SOTOPIA上,AMPO的表现强的一:

任务成功率:比当前最强的GRPO算法高7%,比GPT-4高15.6%

效率提升:推理链长度减少32.8%,相当于把800字小作文精简成500字

更惊艳的是思维模式的动态分布:

对话前几轮用深度模式4占53%,后期简化到模式1占50%

遇到“双方目标冲突”的困难场景时,深度模式使用率是简单场景的3倍

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦