LLM+RL遭严重质疑,随机/错误等虚假奖励也能提升至标准效果?

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

这篇论文的简单结论就是教孩子数学题,不告诉TA对错,反而随机给糖或故意奖励错误答案——结果孩子成绩突飞猛进!这听起来荒谬,但论文在AI领域观察到了类似现象:

虚假奖励四大奇招:

随机奖励:闭眼乱给分(21. 4%提升)

格式奖励:只要答案带方框符号就给分(16. 4%提升)

错误答案奖励:专挑错误答案奖励(24. 6%提升)

1样本训练:仅用1个例子训练(24. 4%提升)

震惊对比:这些“乱来”的操作,效果竟接近用标准答案训练(28. 8%提升)!

关键数据:Qwen2. 5-Math-7B模型在MATH-500测试集上性能飙升

Qwen家族(如Qwen2. 5-Math):虚假奖励通吃,性能全线飘红

其他顶流模型(Llama3、OLMo2):虚假奖励基本无效,甚至性能倒退

残酷真相:

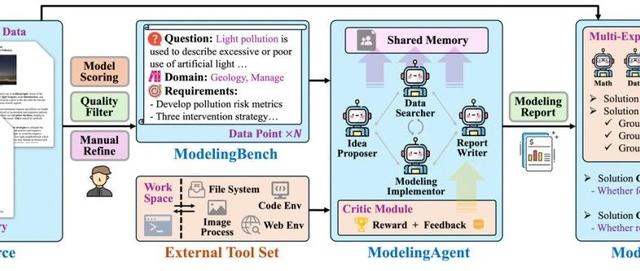

为什么Qwen如此特别?论文发现了它的秘密——代码推理(CodeReasoning):

脑内编译器:Qwen解题时会自动生成Python代码(如计算距离、进制转换),尽管没有真实执行环境!

RLVR的魔法:虚假奖励训练后,Qwen的代码使用率从66. 7%飙升至90%+,正确率同步暴涨!

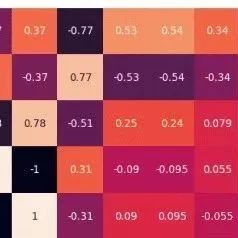

给随机分数也能学习?论文揪出“幕后推手”——GRPO算法的剪切偏差(ClippingBias):

数学理解:

传统认知:随机奖励梯度期望应为零→模型不该更新

实际发现:剪切操作引入不对称更新,偏向模型已有行为

通俗理解:算法比较保守,强化模型原本擅长的套路(如Qwen的代码推理),而非探索新方法。

论文给咱们社区投下深水炸弹:

警惕Qwen中心化:当前大量RLVR研究仅用Qwen验证,可能得出错误结论!

预训练决定上限:RLVR更像是“激活潜力”,而非“传授新知”。

新研究方向:

如何识别不同模型的“隐藏技能”?

能否设计通用奖励机制?

作者疾呼:“请用多样模型验证您的方法!”。看来审稿reviewer的多样性模型实验建议是很有必要的!

备注:昵称-学校/公司-方向/会议(eg. ACL),进入技术/投稿群

id:DLNLPer,记得备注呦