直播预约 | 推理模型的“过思考”现象与高效推理,2.5h的深度分享

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

本期GenTalk学术分享邀请了刘梓辰(新加坡国立大学博士生)、齐朋辉(新加坡国立大学博士生)、杨晨旭(中科院信工所博士生)和陈星好(香港理工大学博士生)在2025年6月6日15:00-17:30为我们带来“推理模型的“过思考”现象与高效推理”的主题报告,由夏鹤明(香港理工大学博士生)进行主持,由NICE学术、MLNLP社区进行支持。详细信息如下:

近年来,以OpenAIo1、DeepSeek-R1等为代表的大语言模型在链式推理能力上取得了显著突破,使其在数学推导、代码生成等复杂任务中展现出卓越性能。然而,目前的推理模型普遍存在“过思考”(Overthinking)现象,即模型在面对简单问题时仍可能生成冗长的推理步骤,产生大量冗余中间字符。这不仅显著增加推理延迟,还带来不必要的计算资源消耗,制约了大语言模型的实际部署效率。本次分享简要分析引起“过思考现象”的潜在因素,并总结目前大模型高效推理的相关研究思路。

刘梓辰,ResearchEngineer@SeaAILab,PhD@NUS。研究方向为RL,RLforLLMs。

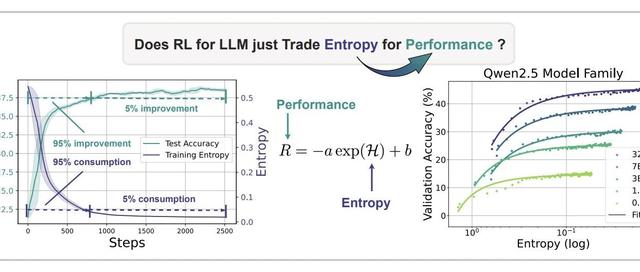

UnderstandingR1-Zero-LikeTraining:ACriticalPerspective

https ://arxiv. org/pdf/2503. 20783

https ://github. com/sail-sg/understand-r1-zero

杨晨旭,中国科学院大学信息工程研究所博士三年级学生。研究方向为大模型的高效推理、解码策略。

摘要依托于测试时扩展定律(test-timescalinglaw),当前的大语言模型通过延长生成长度在多项推理任务中实现了显著的性能提升。然而,这类模型在推理过程中普遍存在“过思考”(overthinking)问题,不仅显著降低了生成效率,还可能引入冗余的自我验证和思路切换,导致原本能够正确回答的问题反而被修改为错误答案。为此,我们提出了DEER方法,在模型思维切换的关键节点提示其生成中间答案,并在置信度足够高时提前终止推理过程。DEER以简单有效的方式缓解了“过思考”问题,在涵盖10个基准任务和11个推理模型的实验中,推理长度平均减少了19. 1%至80. 1%,同时准确率提升了0. 3%至5. 0%。

DynamicEarlyExitinReasoningModels

https ://arxiv. org/abs/2504. 15895

https ://github. com/iie-ycx/DEER

齐朋辉,SeniorResearchEngineer@SeaAILab,PhD@NUS。研究方向为RL,LLMReasoning,MLSys。

OptimizingAnytimeReasoningviaBudgetRelativePolicyOptimization

https ://arxiv. org/pdf/2505. 13438

https ://github. com/sail-sg/AnytimeReasoner

陈星好,香港理工大学博士一年级学生,研究方向为大语言模型推理,高效大语言模型。

摘要传统思维链(CoT)推理依赖自然语言显式表达推理步骤,导致计算效率低下且难以支持抽象认知过程。本文针对新兴的潜在思维链推理(LatentCoT)范式,首次提出系统性综述与多维分析框架。通过解耦推理过程与语言表达,潜在CoT在隐式空间中进行类思维运算,显著提升推理速度并支持非语言化认知表征。我们从方法创新(Token-wisestrategies,internalmechanisms)可解释性分析与应用实践构建分类体系,期望为推动LLM推理领域的这一新方向提供结构化的理论与实践基础。

ReasoningBeyondLanguage:AComprehensiveSurveyonLatentChain-of-ThoughtReasoning

https ://arxiv. org/abs/2505. 16782

https ://github. com/EIT-NLP/Awesome-Latent-CoT

夏鹤明,PhD@PolyU。研究方向包括EfficientNLP,ToolLearning,Vision-LanguageUnderstanding。

进群预约不错过:备注【昵称-单位-方向-NICE入群】

“GenTalk真知论坛学术分享”活动是由中国中文信息学会大模型与生成专业委员会定期举办的学术交流活动,旨在邀请一线学者进行学术分享,期待最精彩的思想火花碰撞。