英伟达发现RL Scaling!创造力暴涨,做基座模型做不了的事!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

RL是“真进化”还是“假勤奋”?

过去学界争论不休:强化学习(RL)到底让语言模型学会了新推理能力,还是仅仅更高效地调用已有能力?

“好比背单词:是词汇量真的扩大了,还是考试技巧提升了?”

此前研究认为RL效果有限,甚至可能损害多样性(如下图中的Diminish现象)。

但本文发现:问题出在训练时间太短(通常仅几百步)!

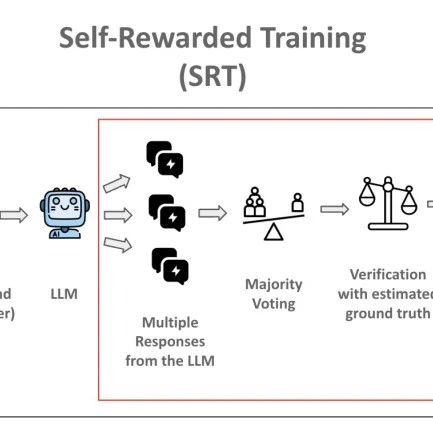

论文提出ProRL(延长强化学习),让RL训练突破2000步以上,结果惊人:

基座模型死活解不开的题(如逻辑谜题),ProRL模型竟能100%通关!

创造力暴涨:模型生成全新解题路径(通过CreativityIndex量化)。

“就像我们突然‘开窍’——不是多试几次蒙对答案,而是真正找到了新解法!”

延长RL训练会遭遇模型摆烂(熵坍塌)和性能倒退,团队用了一下方法稳住长期训练:

基于ProRL训练的Nemotron-Research-Reasoning-Qwen-1. 5B模型,以极小体积吊打同行:

数学:碾压同参数基座模型(+14. 7%),追平7B大模型

代码:超越专业编程模型DeepCoder-1. 5B(+6. 5%)

逻辑题:正确率暴增54. 8%!

这个还真像自己还在上小学。。同桌参加高考还超过大部分考生。。可以啊,这个效果!

ProRL效果最好的场景:基座模型原来搞不定的事!

基座模型表现越差的任务,RL提升越大

OOD泛化:训练中未见的任务(如盒子搬运),ProRL模型轻松解决

难度飙升:面对翻倍的题目复杂度(如节点数激增的图染色),性能依然坚挺

低成本高智能:1. 5B模型达到7B性能,让边缘设备部署优质AI成为可能

免增训练数据:RL探索替代数据标注,降低AI开发门槛

警告:需防范能力滥用,且训练耗能仍高(16kGPU小时)

备注:昵称-学校/公司-方向/会议(eg. ACL),进入技术/投稿群

id:DLNLPer,记得备注呦