“LSTM+强化学习”组合拳打遍顶会!码住这11个idea,论文录用率飙升300%!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

如何高效处理复杂时序任务?不妨考虑LSTM+强化学习。这种技术结合了LSTM的时序数据处理能力,以及强化学习的动态决策优化能力,天然适合众多需要处理部分可观测环境,以及时序依赖的决策场景。

因此LSTM+强化学习目前已覆盖相当多的领域,比如火爆的金融预测。再加上行业对动态、自适应决策系统的需求激增,关于这方向的研究日渐火热,各大顶会顶刊皆有成果发布,研究前景非常之可观。

对于论文er来说,这方向未来的创新可围绕模型架构优化、跨领域应用扩展、实际场景难题攻克等方向展开。另外还需注意LSTM+强化学习对算力的高要求,建议使用参数共享等降低复杂度。我这边整理了11篇LSTM+强化学习前沿论文(有代码),需要参考的可无偿获取。

扫码添加小享,回复“强化长短”

免费获取全部论文+开源代码

方法:论文提出了一种结合LSTM和强化学习的自动化股票交易系统。通过LSTM提取股票数据的时间序列特征,再用强化学习的PPO算法进行训练,从而优化交易策略。

创新点:

使用LSTM提取股票数据的时间序列特征,再将特征输入强化学习模型,提升特征表达能力。

强化学习部分采用PPO算法,并结合LSTM网络进行训练,增强模型对动态市场的适应性。

在美国、中国、印度和英国的股票市场进行实验,验证了模型在不同市场环境下的有效性和鲁棒性。

方法:论文提出了一种基于注意力机制和强化学习的智能食品安全预测模型(RL-ALSTM)。该模型通过双层LSTM网络提取食品检测数据的时间序列特征,并结合注意力机制和强化学习(DQN)进一步增强特征表达能力,从而实现对食品安全合规率的高精度预测。

创新点:

提出了一种基于LSTM和强化学习的食品安全预测模型,能够有效提取食品检测数据的时间序列特征。

引入注意力机制,增强模型对关键信息的关注能力,提升预测精度。

在多个数据集上验证了模型的有效性,结果表明该方法优于传统的LSTM和机器学习方法。

扫码添加小享,回复“强化长短”

免费获取全部论文+开源代码

方法:论文提出了一种基于PFL和MAADRL的算法,用于优化城市水处理厂的多个取水泵站的调度。通过LSTM建模环境并结合强化学习优化调度策略,在满足约束条件下,显著降低能耗,最高节能10. 6%。

创新点:

采用个性化联邦学习(PFL)与长短期记忆网络(LSTM)结合,提升模型对不同泵站数据的适应性。

引入多智能体注意力机制,优化智能体间的协作,提高调度效率。

实现显著节能效果,相比其他基准方法最高节能10. 6%。

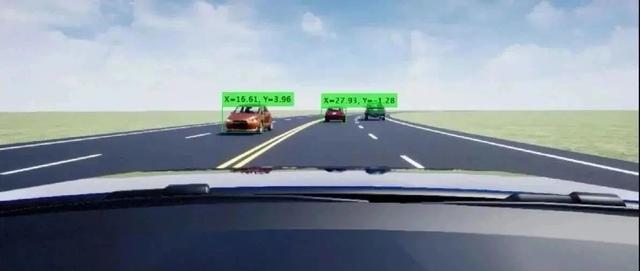

方法:论文提出RPP-LSTM算法,结合LSTM与DQN,利用强化学习让无人机能够基于当前和历史环境信息做出决策,避免单步局限,提升其复杂环境路径规划能力与适应性。

创新点:

引入LSTM网络作为Q值网络,使无人机路径规划能够利用历史信息,提升决策的准确性和路径的平滑性。

提出分层奖励和惩罚函数,针对无人机路径规划的具体问题优化路径选择,提高路径规划的合理性。

通过实验验证,相比传统基于前馈神经网络(FNN)的算法,RPP-LSTM在复杂环境中的适应性和鲁棒性显著提升。

扫码添加小享,回复“强化长短”

免费获取全部论文+开源代码