CVPR 2025 | 香港中文大学 MMLab 提出文生图模型 T2I - R1,文生图进入 R1 时刻!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

香港中文大学MMLab提出了一种基于双层次CoT推理框架与强化学习的新型文本生成图像模型T2I-R1,该模型结合了语义级和token级的链式思维(CoT)推理过程,并通过强化学习进行增强。T2I-R1旨在通过在图像生成的不同阶段应用CoT推理策略,提升生成质量和文本与图像的对齐度。

论文:https ://arxiv. org/pdf/2505. 00703

代码:https ://github. com/CaraJ7/T2I-R1

大型语言模型的最新进展已经证明了思维链(CoT)和强化学习(RL)如何提升性能。然而,将此类推理策略应用于视觉生成领域仍未得到广泛探索。本文提出了T2I-R1,这是一种新颖的推理增强型文本到图像生成模型,它由强化学习驱动,并采用双层CoT推理过程。具体而言,我们确定了两个可用于增强不同生成阶段的CoT层级:

用于提示高级规划的语义层CoT;

用于逐块生成过程中低级像素处理的token层CoT。

为了更好地协调这两个CoT层级,引入了具有生成奖励集合的BiCoT-GRPO,它可以在同一训练步骤中无缝优化两个生成CoT。通过将推理策略应用于基线模型Janus-Pro,该方法取得了卓越的性能,在T2I-CompBench上提高了13%,在WISE基准上提高了19%,甚至超越了最先进的模型FLUX. 1。

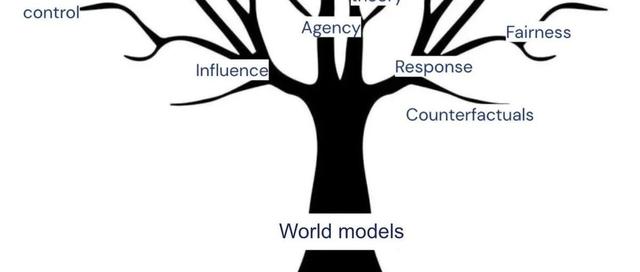

图像理解和生成任务中认知能力(CoT)的图示。在图像理解任务中,认知能力(CoT)是文本推理过程。在自回归视觉生成任务中,我们定义了两个级别的认知能力(CoT):语义级认知能力(CoT)和标记级认知能力(CoT)。语义级认知能力(CoT)是图像生成之前的高级规划,以文本的形式呈现。标记级认知能力(CoT)是逐个图像块(patch)的中间生成过程,关注图像块内的局部像素细节,以图像标记的形式呈现。

T2I-R1图像生成过程可视化。所有提示都需要推理,或包含不常见的场景。我们观察到,T2I-R1能够成功推断出提示背后的真实意图,或对不常见的场景(文中突出显示)进行合理的想象,从而与基线模型Janus-Pro相比,产生了令人满意的结果。

BiCoT-GRPO框架。在步骤1中,指示模型根据图像提示生成语义级CoT。在步骤2中,基于图像提示和语义级CoT生成图像,中间生成过程作为token级CoT。生成的图像由视觉专家团队评估以获得奖励。从每个提示生成N张图像,以计算群体相对奖励并进行GRPO训练。

生成奖励集合示意图。使用GPT-4omini在训练前提取对象及其属性。每个专门的奖励模型都会接收定制的信息输入,用于奖励计算。将所有奖励的平均值作为最终奖励。

可视化结果。提供了四个模型针对同一问题的图像生成结果:基础模型、仅优化语义级CoT的模型、仅优化token级CoT的模型以及同时优化两个级别CoT的模型。

单个提示图像多样性的可视化结果。展示了仅对token级CoT进行优化的结果,以及同时对语义级和token级CoT进行优化的结果。

论文介绍的T2I-R1是首个基于双层CoT推理过程的推理增强型文本转图像模型。作者识别了用于高级规划的语义级CoT和用于逐块生成的token级CoT。通过提出的BiCoT-GRPO进一步整合了它们,这是一个在同一训练步骤中整合了两级CoT的强化学习框架。通过利用同时具备视觉理解和生成能力的ULM,提出的方法无需使用单独的专用模型,同时实现了显著的性能提升,在T2I-CompBench上提升了13%,在WISE基准上提升了19%,甚至超越了FLUX. 1。定性分析表明,T2I-R1能够更好地理解复杂的提示,推理用户意图,并以更高的鲁棒性处理不常见场景,从而为以推理为中心的生成系统建立了新的范式。

感谢你看到这里,也欢迎点击关注下方公众号并添加公众号小助手加入官方读者交流群,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、StableDiffusion、Sora等相关技术,欢迎一起交流学习💗~