(CVPR 2025)大模型太贵?不如让小模型先看看图再决定用不用大模型!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

论文题目:AStitchinTimeSavesNine:SmallVLMisaPreciseGuidanceforAcceleratingLargeVLMs

论文地址:https ://arxiv. org/pdf/2412. 03324

代码地址:https ://github. com/NUS-HPC-AI-Lab/SGL

本文提出了一种名为SGL(SmallVLMGuidanceforLargeVLMs)的训练无关方法,通过利用小型VLM的全局注意力图来指导大型VLM中的视觉令牌裁剪。这种方法有效地解决了现有方法在低令牌保留率下性能不佳的问题。

研究发现,通过聚合小型VLM所有层的注意力图,可以得到与大型VLM全局注意力图非常接近的结果。这一发现使得可以用小型VLM的注意力图来代替大型VLM的注意力图,从而减少计算开销。

SGP技术利用小型VLM的全局注意力图来评估视觉令牌的重要性,并据此裁剪大型VLM中的非关键视觉令牌。这可以显著减少大型VLM的计算负担,同时保留关键信息。

本文的主要研究方法是提出了一种名为SGL(SmallVLMGuidanceforLargeVLMs)的训练无关方法,该方法通过利用小型VLM的全局注意力图来指导大型VLM中的视觉令牌裁剪。具体来说,首先使用小型VLM对输入图像和文本提示进行推理,聚合所有层的注意力图以计算视觉令牌的重要性分数。然后,根据这些分数对大型VLM中的视觉令牌进行排序和裁剪,从而减少计算量并保留关键信息。此外,还引入了早期退出机制SEE(SmallVLMEarlyExiting),通过评估小型VLM的预测结果来决定是否需要调用大型VLM,进一步提高了推理效率。这种方法能够在保持竞争力的性能的同时,显著降低大型VLM的计算成本。

本图展示了SGL方法的动机和核心思想,通过三个子图(a、b、c)详细阐述了研究背景、关键发现以及小型VLM在指导大型VLM中的作用。在子图(a)中,作者对比了单层注意力图和聚合所有层注意力图在视觉令牌裁剪上的效果差异。在子图(a)中,作者对比了单层注意力图和聚合所有层注意力图在视觉令牌裁剪上的效果差异。子图(c)进一步强调了小型VLM和大型VLM之间的性能差距相对较小,而计算复杂度差异却很大。

本图详细阐述了SGL方法的核心技术细节,包括小型VLM引导的视觉令牌裁剪(SGP)和小型VLM早期退出(SEE)的具体实现方式。图2的三个子图分别呈现了SGP的流程、注意力图的聚合过程以及SEE的推理机制,提供了对SGL方法技术细节的深入理解。(a)展示了小型VLM引导的视觉令牌裁剪(SGP)在大型VLM中的应用流程。(b)深入展示了SGP中注意力图的聚合过程。分为预填充阶段和解码阶段。(c)则描绘了小型VLM早期退出(SEE)的推理机制。在获得小型VLM的预测结果之后,通过评估其决策分数来判断是否直接终止推理流程,而无需激活大型VLM。

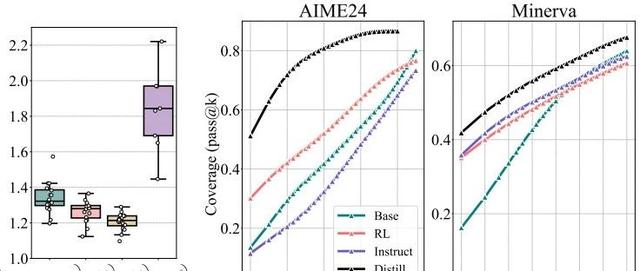

本图展示了SGL(SGP+SEE)方法的性能-效率曲线,具体来说,它呈现了不同视觉令牌保留率(18%、35%、50%和64%)下,不同大小的大型VLM(InternVL2-26B、40B、76B)在TextVQA基准测试中的表现。曲线展示了在保持一定性能水平的同时,如何通过调整视觉令牌保留率来优化推理效率。

本表展示了SGP方法与其他视觉令牌压缩方法(ToMe和FastV)在InternVL2-26B模型上的性能对比,该模型共有48层。SGP和FastV通过在不同层(第19层、第9层和第2层)裁剪不同比例的视觉令牌(分别为60%、80%和95%),实现了64%、35%和9%的平均视觉令牌保留率。ToMe则通过调整其合并比例来实现相似的保留率。在高保留率(64%)时,所有方法在各个任务上的表现相当,这表明VLMs中存在显著的视觉令牌冗余,强调了视觉令牌裁剪的重要性。在低保留率(9%)时,FastV和ToMe在所有任务中的性能显著下降,因为不准确的裁剪导致关键视觉令牌丢失。总之,本表说明了SGP方法在不同视觉令牌保留率下相比现有方法的优越性,特别是在低保留率时,能够更准确地保留关键视觉令牌并维持模型性能。

–END–

最后对大模型创新感兴趣的可公众号后台私信‘加群’或者扫描下方👇二维码进入大模型交流群!

关注“学姐带你玩AI”公众号,回复“2025大模型”

领取2025大模型创新方案合集+开源代码

往期推荐:

如何给大模型喂时序数据?基于LLMs的时间序列预测5大方法汇总

强化学习+大模型轻松发顶会!不要光想着LLM,OpenAIo1这样做才是对的

时间序列+预训练大模型!最新开源成果性能暴涨42. 8%

结合创新!高性能小模型+热门大模型=王炸,8种策略教你拿下顶会顶刊!

完美融合!LLM大模型x知识图谱2024最新SOTA!(附代码)

ACCEPT

据说点赞的都Accept了!