UIUC联合伯克利提出AlphaOne:先“深度慢想”再“秒答”,效果巨好

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

大型推理模型(如GPT-4o、DeepSeek-R1)常陷入两难:

想太多(Overthinking):反复纠结细节,浪费时间(如解数学题时过度推导)。

想太少(Underthinking):仓促作答,错误率高(如漏掉关键步骤)。

这就像人类遇到难题时,系统1(直觉快思)和系统2(深度慢思)切换失衡。

论文:AlphaOne:ReasoningModelsThinkingSlowandFastatTestTime链接:https ://arxiv. org/pdf/2505. 24863

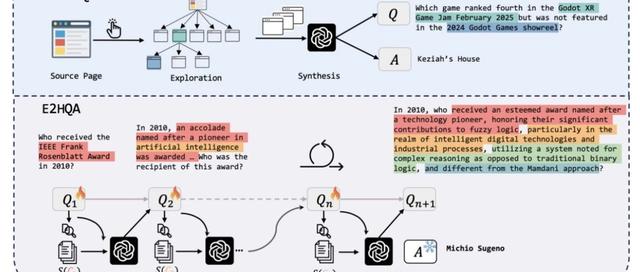

方法:用参数α动态调控推理节奏:

α时刻(AlphaMoment):设定“慢思考”阶段的最小长度(α×基准时长)。

慢思考阶段:在结构分隔符(如\n\n)后随机插入“wait”指令(概率按计划衰减),强制深度思考。

快思考阶段:α时刻后用“”替换“wait”,直接输出答案。

就像开车——复杂路段(α时刻前)降速稳行,平坦路段(α时刻后)果断加速。

与传统认知相反,论文发现:

人类习惯:先快速直觉反应,遇阻再慢思考(Kahneman理论)。

模型最优策略:先深度慢思考,再快速生成答案(线性退火调度效果最佳)。

慢思考频率越高(如“wait”插入次数比基线高2倍),模型表现越好!

在数学、编程、科学三大领域测试:

准确率提升:最高+6. 15%(1. 5B小模型提升最显著)。

效率提升:生成内容缩短14%,整体推理速度提升21%。

碾压基线:比单调加速法(s1)和单调减速法(CoD)更高效。

一些case(详见文末):

成功case:α1帮小模型破解化学混合难题(Base模型失败)。

失败case:α1仍误算高阶数学系数(人类专家可纠正)。

备注:昵称-学校/公司-方向/会议(eg. ACL),进入技术/投稿群

id:DLNLPer,记得备注呦