字节 DreamFit 虚拟试衣:任意服装随心试,多风格人体模特一键匹配生成,轻量级即插即用!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

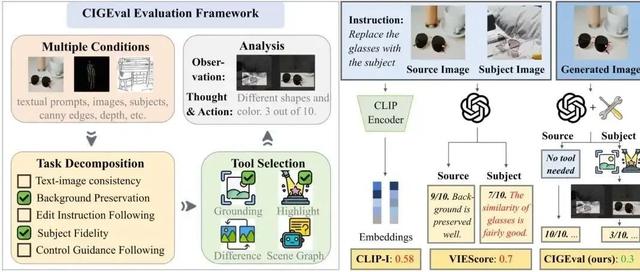

今天跟大家介绍一款由字节提出的新的虚拟试衣框架:DreamFit,这是一款结合了一种专门为以服装为中心的人类生成量身定制的轻量级任何服装编码器。DreamFit具有三个关键优势:

轻量训练:只需8340万可训练参数

任何服装:可试穿任意风格服装

即插即用:兼容各种社区插件试用

下面展示的是DreamFit以服装为中心的人体生成结果:

上图:DreamFit可以根据给定的服装图像和提示,合成具有多种风格、背景和体型的人体图像。

中图:DreamFit与ControlNet和FaceID等社区插件兼容。

下图:DreamFit与SOTA方法相比表现出卓越的性能,实现了最高水平的纹理和文本一致性。

论文:https ://arxiv. org/pdf/2412. 17644

代码:https ://github. com/bytedance/DreamFit

模型:https ://huggingface. co/bytedance-research/Dreamfit

工作流:https ://www. runninghub.cn/post/1920852726639693826/?inviteCode=kol01-rh059

基于文本或图像提示,以服装为中心生成人体的扩散模型因其巨大的应用潜力而备受关注。然而,现有方法往往面临一个难题:轻量级方法(例如适配器)容易生成不一致的纹理;而基于微调的方法训练成本高昂,并且难以维持预训练扩散模型的泛化能力,从而限制了其在不同场景下的性能。为了应对这些挑战,论文提出了DreamFit,它集成了一个专为以服装为中心的人体生成量身定制的轻量级Anything-Dressing编码器。

DreamFit具有三大主要优势:

轻量级训练:通过提出的自适应注意力和LoRA模块,DreamFit将模型复杂度显著降低至83. 4M个可训练参数。

任何着装:我们的模型出奇地适用于各种(非)服装、创意风格和提示说明,能够在各种场景中始终如一地提供高质量的结果。

即插即用:DreamFit专为与任何用于传播模型的社区控制插件顺利集成而设计,确保轻松兼容并最大限度地减少采用障碍。

为了进一步提升生成质量,DreamFit利用预训练的大型多模态模型(LMM),通过细粒度的服装描述来丰富提示,从而缩小训练和推理之间的提示差距。我们对768×512高分辨率基准和自然场景图像进行了全面的实验。DreamFit超越了所有现有方法,彰显了其以服装为中心的人体生成领域的领先优势。

DreamFit是一个以服装为中心的新型人体图像生成框架,旨在解决现有方法的低效和局限性。通过利用基于LoRA层的轻量级、即插即用的AnythingDressing编码器,DreamFit显著降低了模型复杂性和内存占用,从而促进了更高效、可扩展的训练流程。

该方法将大型多模态模型集成到推理过程中,有效缩小了训练和推理文本提示之间的领域差距,并提高了生成图像的整体质量和一致性。在公开和内部基准测试中开展的大量实验表明,DreamFit不仅达到了最佳性能,还在各种场景中展现出卓越的泛化能力。

感谢你看到这里,也欢迎点击关注下方公众号并添加公众号小助手加入官方读者交流群,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、StableDiffusion、Sora等相关技术,欢迎一起交流学习💗~