SIGIR 25:知之为知之 SIM-RAG 反思与主动检索

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

在人工智能的世界里,语言模型一直在努力变得更聪明,但有时候它们也会“说瞎话”——也就是生成一些看似合理但实际上并不准确的内容。这种现象被称为“生成幻觉”,是当前AI的一大痛点。

当你问一个复杂问题时,AI需要从海量信息中找到答案。这就像是在迷宫里找出口,可能需要多次尝试才能找到正确路径。但目前的多轮检索系统有个问题:它们要么在已经找到足够信息时还继续搜索,浪费资源;要么在信息不足时就贸然给出错误答案。

https ://arxiv. org/pdf/2505. 02811

KnowingYouDon’tKnow:LearningWhentoContinueSearchinMulti-roundRAGthroughSelf-Practicing

传统的RAG系统,也就是单轮RAG,就像是一个只会“一锤子买卖”的检索员。用户问一个问题,它就用这个问题或者语言模型生成的查询词去知识库中检索一次,然后给出答案。这种系统对于那些简单直接的问题来说,效果还不错。但一旦遇到需要多步推理、整合多个文档信息或者澄清模糊点的复杂问题,它就无能为力了。

于是,多轮RAG应运而生。它就像是一个会“反复思考”的侦探,通过多轮检索和推理来逐步完善答案。但多轮RAG也面临着一个核心难题:怎么判断检索到的信息已经足够回答问题了呢?换句话说,就是怎么知道自己“已经知道”或者“还需要继续找”呢?

SIM-RAG的核心思想是模拟人类的“元认知”能力,让AI在复杂任务中动态评估自己的知识边界,并根据需要调整检索和推理策略。整个框架由三个主要模块组成:

Reasoner(推理器):这是一个语言模型,负责根据当前问题和上下文生成答案和推理过程。

Retriever(检索器):这是一个搜索引擎,负责根据Reasoner生成的查询词检索外部知识。

Critic(裁判):这是一个轻量级的判别模型,负责评估Reasoner生成的答案是否足够可靠。

这三个模块协同工作,形成了一个迭代推理框架,模拟人类在面对复杂问题时的思考过程。

训练的第一步是“自我练习”。在这个阶段,SIM-RAG让AI进行多轮检索和推理的模拟练习。具体来说,AI会从一个已知答案的问题开始,尝试通过多轮检索和推理找到正确答案。每一步的推理结果都会被记录下来,并标记为“成功”或“失败”。这些标记的数据就是训练Critic的“教材”。

这个过程就像是AI在进行“内心独白”,通过不断地尝试和反思,生成反映其当前能力水平的合成训练数据。这种数据比人工标注的数据更具针对性,因为它直接反映了AI在实际任务中的表现。

有了这些合成数据后,下一步就是训练Critic。Critic的任务是判断Reasoner生成的答案是否足够可靠。通过大量标记了“成功”或“失败”的数据,Critic能够学习如何评估AI的推理过程和答案的可靠性。

这个Critic就像是AI的“外脑”,帮助AI避免“过度自信”和“过度检索”的问题。它通过提供自然语言的反馈(“接受”或“拒绝”),让AI能够根据反馈动态调整自己的行为。

在实际使用中,SIM-RAG的推理过程是一个迭代循环:

生成答案:Reasoner根据当前问题和上下文生成一个答案和推理过程。

评估答案:Critic评估这个答案是否足够可靠。如果可靠,就作为最终答案返回;如果不可靠,就进入下一步。

检索信息:Reasoner生成一个新的查询词,Retriever根据这个查询词检索新的外部知识。这些新知识会被加入到上下文中,供下一轮推理使用。

这个过程会不断重复,直到Critic认为答案足够可靠,或者达到预设的最大迭代次数。通过这种方式,SIM-RAG能够动态调整检索和推理策略,逐步完善答案。

为了全面评估SIM-RAG的能力,研究者们选择了三个具有代表性的问答(QA)数据集,覆盖了从单跳(single-hop)到多跳(multi-hop)的复杂推理任务:

TriviaQA:单跳问答任务,需要从维基百科中的一条证据中推理出答案。

HotpotQA:多跳问答任务,需要整合多条文档中的信息来回答问题。

2WikiMultiHopQA:多跳问答任务,专注于区分细微相关的实体并整合细粒度证据。

这些数据集不仅考验了SIM-RAG在多轮检索中的能力,还测试了它在信息不足时的推理能力。实验中,研究者们使用了两种不同的语言模型(Llama3-8B和GPT-4)作为Reasoner,并分别训练了两个版本的Critic(SIM-RAGfull和SIM-RAGlite),以验证框架的灵活性和效率。

实验结果非常令人振奋!SIM-RAG在所有三个数据集上都表现出色,尤其是在复杂的多跳问答任务中,SIM-RAGfull版本(使用GPT-4作为Reasoner)的性能显著优于所有基线方法。例如,在HotpotQA和2Wiki数据集上,SIM-RAGfull的EM(ExactMatch)和F1分数均达到了最高水平,分别比其他方法高出数个百分点。

对于单跳问答任务(TriviaQA),虽然一些基线方法在简单任务上表现更好,但SIM-RAG仍然展现出了强大的适应性。特别是SIM-RAGfull版本,其EM分数比标准RAG方法高出16个百分点,显示出即使在简单任务中,SIM-RAG也能通过Critic的引导避免“过度自信”或“过度检索”的问题。

实验还深入分析了Critic的作用。研究发现,即使是一个轻量级的Critic(如SIM-RAGlite中的783M模型),也能显著提升系统的性能。例如,在HotpotQA数据集上,SIM-RAGlite的性能比Self-RAG高出近10个百分点,而训练参数仅为Self-RAG的十分之一。这表明,Critic在多轮检索中起到了关键的“刹车”作用,能够有效避免检索过程中的错误累积。

此外,研究还发现,Critic的预测准确性在不同数据集上有所不同。在复杂的多跳问答任务中,Critic能够更准确地拒绝错误答案,而在简单的单跳问答任务中,Critic的接受率更高。这反映了SIM-RAG框架的灵活性和适应性,能够根据不同任务的特点调整检索和推理策略。

为了进一步验证SIM-RAG的设计合理性,研究者们进行了多项消融研究:

Critic模型选择:研究发现,使用更强大的模型(如GPT-4)作为Critic在简单任务上表现良好,但在复杂任务上,轻量级的Critic(如Flan-T5)表现更优。这表明,对于复杂推理任务,一个专门训练的Critic比通用的LLM更有效。

内省轮次(InnerMonologueTurns):实验发现,增加内省轮次(即多轮检索和推理的次数)可以显著提升SIM-RAG的性能。这表明,通过多次迭代,SIM-RAG能够逐步完善答案,直到Critic认为答案足够可靠为止。

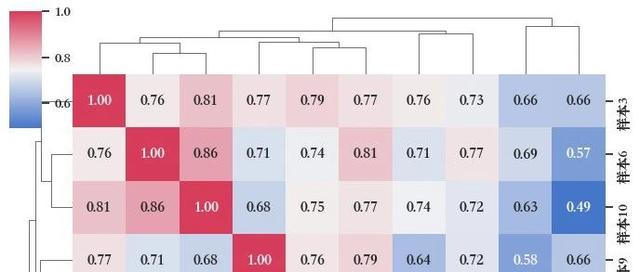

自练习数据的价值:通过可视化自练习过程中生成的内省轨迹,研究发现这些数据不仅涵盖了信息不足的情况,还捕捉了过度检索带来的干扰。这进一步证明了自练习数据在训练Critic时的价值,使其能够有效评估信息的充分性。

SIM-RAG的设计非常轻量级,它通过添加一个Critic模块来优化多轮RAG,而不需要修改语言模型的参数。这种设计不仅保持了系统的模块化,还使得训练过程更加高效。实验表明,即使是轻量级的Critic(如783M的Flan-T5),也能显著提升系统性能。

尽管SIM-RAG在与预训练语料库相关的任务上表现出色,但在领域特定的任务中,尤其是那些包含大量专业术语的任务中,可能会面临挑战。这是因为Reasoner的预训练知识可能无法完全覆盖这些特定领域的信息。

#学习大模型&讨论Kaggle#

△长按添加竞赛小助手

每天大模型、算法竞赛、干货资讯

与36000+来自竞赛爱好者一起交流~