少样本视觉异常检测,无需训练,突破跨领域限制检测!(附论文及源码)

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

以下文章来源于微信公众号:码科智能

作者:码科智能

链接:https ://mp. weixin.qq. com/s/EABxH59OVAKUoTr-XgFUVg

本文仅用于学术分享,如有侵权,请联系后台作删文处理

导读

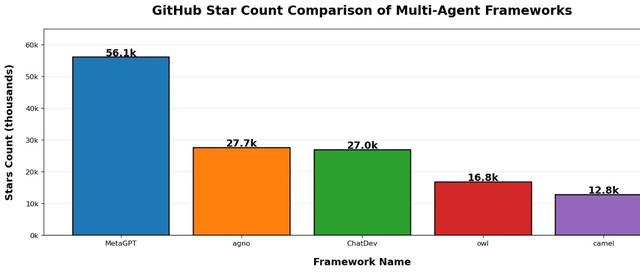

在视觉异常检测(VAD)广泛应用于工业、医疗等领域,但现有方法多为“一类一模型”,难以跨领域推广。中科院自动化所提出的UniVAD方法打破这一局限,通过统一模型实现无需训练的泛化异常检测,适用于多领域异常识别,显著提升了VAD的通用性与可扩展性。

UniVAD仅提供一个正常样本作为参考,即可得到准确结果

视觉异常检测(VAD)旨在识别图像中偏离正常模式的异常样本,涵盖多个领域,包括工业、半导体和医疗领域。由于这些领域之间存在领域差距,现有的VAD方法通常采用定制的检测算法和模型架构,难以在不同领域推广。即使在同一领域内,当前的VAD方法也经常遵循“一类一模型”的范式,需要大量正常样本来训练特定类别的模型,限制了VAD的通用性及可扩展性等问题。

例如,工业异常检测的最先进的方法之一PatchCore,在工业数据集MVTecAD上的AUC达到84. 1%,但当应用于元件异常检测的数据集时,其性能显著下降至62. 0%。为了解决这些限制,中科院自动化所研究人员提出了一种无需训练的泛化异常检测方法UniVAD,它利用统一模型跨多个领域检测异常,而无需特定领域的数据训练。

模型及在线链接如下,代码待开源:

UniVAD是首个无需训练的统一视觉异常检测(VAD)方法,无需特定领域的训练,即可检测多个领域的异常,包括工业、Logical和医学图像。与现有的VAD方法(每个领域都需要单独的模型)不同,UniVAD利用统一方法,在测试期间仅使用目标类别的少量正常样本即可检测异常。

UniVAD与现有方法的比较。

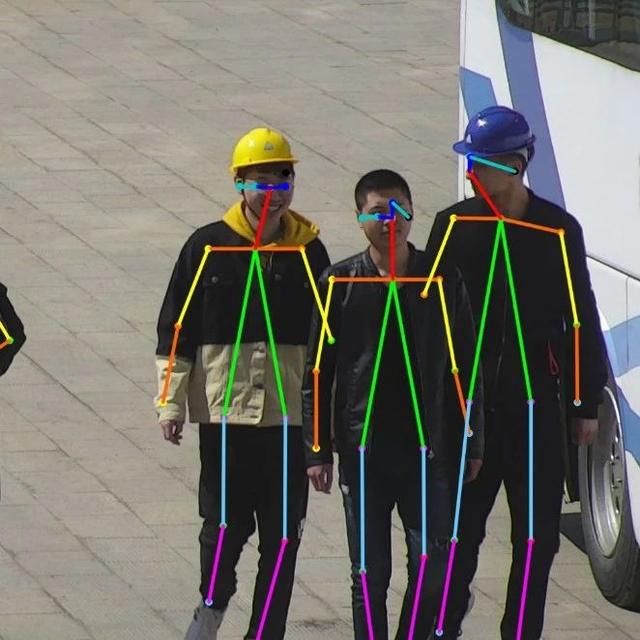

给定一张输入图像,UniVAD首先使用文上下组件聚类模块为每个实体生成掩码。然后,UniVAD应用组件感知补丁匹配模块和图增强组件建模模块来检测结构和逻辑异常。两个专家模块的输出被结合起来,产生最终的统一异常检测结果。

UniVAD的整体架构

上下文组件聚类(C3)模块是一个创新的方法,它通过结合视觉基础模型和聚类技术,在只有少量正常样本的情况下,实现对图像中各个组件的精确分割。C3模块首先识别图像中的对象并生成内容标签,然后生成掩码,并对这些掩码进行细化和过滤,以确保在不同图像间保持一致性。通过使用Kmeans聚类算法和交集比(IoU)计算,C3模块能够有效地分割和识别图像中的多个对象,为进一步的异常检测提供了基础。如下图所示:

组件感知补丁匹配(CAPM)方法通过结合组件约束和图像-文本特征相似性比较,扩展了传统的补丁特征匹配。该方法首先使用预训练的网络提取查询图像和正常图像的特征图,然后通过插值获得补丁特征。利用C3模块提供的组件掩码,CAPM在每个组件内进行特征匹配,提高了异常检测的准确性。此外,CAPM还结合了图像-文本特征匹配,通过计算查询图像补丁与正常和异常状态文本特征之间的余弦相似度,进一步增强了异常检测能力。最终,CAPM将三种异常得分相加,得出结构异常得分图,用于异常检测。这种方法有效地解决了传统补丁匹配方法在区分前景背景和不同对象组件时的局限性,提高了异常检测的性能和准确性

2. 模型效果示例

螺母带有异常

欢迎加入《AI未来星球》,一起成长

扫描下方二维码即可加入~

真诚分享AI落地过程(AI商机->项目签约->算法开发->产品开发->实施运维)中的各方面经验和踩过的坑。

你可以获得什么?

1、大白之前花费10W+购买,AI行业各场景私有数据集下载,星球内倾情分享;2、AI行业研发、产品、商业落地问题咨询(目前AI公司创业中),都可获高质量解答,有效期一年,无限次提问,有问必答。3、定期邀请AI行业各类嘉宾分享,创业/商业等方面的经验!

帮助你解决遇到的实际问题,升职加薪!

大家一起加油!