真实联网搜索Agent,7B媲美满血R1,华为盘古DeepDiver给出开域信息获取新解法

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

机器之心发布

机器之心编辑部

大型语言模型(LLM)的发展日新月异,但实时「内化」与时俱进的知识仍然是一项挑战。如何让模型在面对复杂的知识密集型问题时,能够自主决策获取外部知识的策略?

论文链接:https ://github. com/pangu-tech/pangu-ultra/blob/main/pangu-deepdiver-report. pdf

arxiv链接:https ://arxiv. org/abs/2505. 24332

该项研究的主要发现如下:(1)对于复杂信息获取任务,端到端AgenticRL训练相比直接蒸馏老师轨迹能更好地实现SearchIntensityScaling,从而带来平均10PCT效果提升;(2)基于真实互联网搜索API和数据集进行训练,相比基于Wikipedia,能够学到更多有效推理模式;(3)基于SearchIntensityScaling,DeepDiver的检索和推理能力可以从客观题泛化至主观生成任务。

下文将详细解读DeepDiver的创新之处,包括其数据构建方法,AgenticRL训练过程,以及SearchIntensityScaling如何带来显著性能提升。

为什么要提出DeepDiver?

当前RAG技术主要分为两大流派:

Prompt-based方法:如FLARE[ 1]、Search-o1[ 2]等,通过复杂prompt流程指导模型,优势在于即插即用,但缺乏灵活性和智能性。

SFT-based方法:如Self-RAG[ 3]、AutoRAG[ 4]等,通过构建人工合成数据教会模型拆解问题、生成检索词,但行为方式、获取信息的策略完全取决于SFT数据分布,泛化能力有限。

LLM预训练已内化大量Wiki知识,使得模型不需真正检索就能回答问题

Wiki环境过于「干净」,缺乏真实互联网的噪声和信息冲突,这使得目前主流的基于wiki环境的LLM会主动地学习如何收集关键信息,但如何解决冲突,如何在真实互联网环境中去噪,验证信息真实度,以及如何反思和纠正内容等高阶能力则会被忽略。

这些受限的训练语料和环境,阻碍了LLM学习动态地决定何时何地进行搜索,以及如何根据需求调整搜索深度和频率。研究团队将这种缺失的能力定义为SearchIntensityScaling(SIS)——一种在充满模糊、信息冲突的高噪音环境下,LLM为了突破困境而涌现出的信息检索能力,通过SIS,模型会根据问题难易程度动态的调整搜索频率和深度,而不是妥协于验证不足的答案上。为此,研究团队认为只有在真实互联网环境下,用真实互联网数据进行探索式训练,才能使模型涌现真正的高阶信息检索和推理能力。

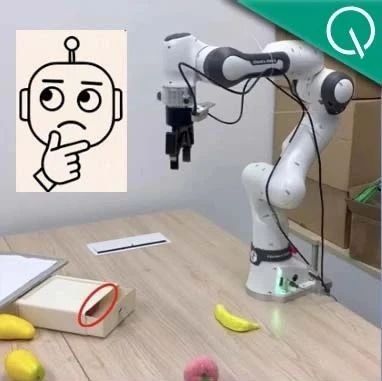

图1:四种关键信息搜索行为示意图:

(a)收集关键信息,(b)解决冲突,(c)验证与去噪,(d)反思与纠正

WebPuzzle

真实互联网环境下的高质量数据集

为了让模型能够使用真实的互联网数据进行训练,本文提出了WebPuzzle。

来看几个WebPuzzle中的问题示例:

他是一名NBA状元秀球员,他曾效力于76人、掘金、活塞等队,他入选了最佳新秀一阵,然而他没拿到过总冠军,他有超过170+次数的两双数据,他是谁?

–答案:JoeSmith(艾佛森并不满足两双数据的描述)

她凭借多个经典古装角色深入人心,她曾经签约了海外的唱片公司推出过多语种音乐专辑,她主演的某部古装剧更因播放量创纪录被国家馆藏机构收录,更令她凭此剧斩获某电视节最高奖项,她是谁?

–答案:刘亦菲

2020年10月至2024年4月期间,华为公司与孝感市政府进行了几次合作洽谈?每次洽谈的主要领导是谁?

–答案:2次洽谈,第一次是2020年时任市委书记、市长吴海涛与湖北公司总经理孟少云。第二次是2024年市委副书记、市长吴庆华与华为技术有限公司高级副总裁杨瑞凯。

尝试用搜索引擎解答这个问题,会发现需要多轮搜索和推理才能得出正确答案。

数据收集与处理

WebPuzzle主要从两个数据源采集:

Wiki猜谜类数据:研究团队收集了大部分LLM的cutoffknowledgedate后的Wiki语料,在语料中选取特定实体作为谜底,然后罗列出与该实体有关的特性作为谜面,再将其中部分特性隐藏化、模糊化(如示例中的「超过170+次数」,「签约了海外的唱片公司」分别代表「172次两双数据」,「签约了日本的唱片公司」),增加解题难度。

真实用户问题:基于现网真实用户问题及其搜索返回结果,构建多篇网页交叉验证的问题。

图2:WebPuzzle数据构建流程,包括候选生成和难度标注两个主要阶段

测试集经过了人工标注后,最终版WebPuzzle包含24k训练样本和275条高质量评测样本,涵盖不同难度等级的跨页问答和猜谜题目。

DeepDiver训练流程

迭代检索与强化学习在真实互联网环境下的结合

DeepDiver基于迭代式RAG框架构建,该框架要求模型在收到用户请求后,自行在多个轮次交替式的推理和搜索,具体来说,在每个轮次中:

1. 推理(Reasoning):针对历史轮次进行反思、推理、总结

2. 决策:根据推理的内容,决策当前轮次是搜索(Search)或回答(Answer)

整体训练流程分为两个主要阶段:

冷启动阶段(Cold-startSFT)

通过蒸馏teacher模型的回复,使模型掌握基本的解题套路。使用5. 2k高质量数据对模型进行初步训练,包括:

2kWebPuzzle数据

2. 2k通用推理数据(数学、逻辑推理等)

1k真实用户问题与搜索结果拼接数据

强化学习阶段(ReinforcementLearning)

在冷启动模型的基础上,使用GRPO算法让模型自主探索,对高质量探索路径给予奖励。这一过程完全由outcomereward信号引导,没有distillation或SFT范式的step-wise数据干预。

图3:DeepDiver训练流程概览,包括rollout生成和GRPO模型更新

Reward机制设计

DeepDiver采用了两种互补的奖励函数设计:

1. 宽松奖励(训练初期):使用0-10分评分标准,模型输出满足部分条件(得分≥6)即可获得奖励,稳定训练初期。

2. 严格奖励(训练后期):模型回答需通过三轮严格评估,每轮由三个不同LLMgrader校验,只有至少2轮校验通过的情况下才会给予奖励。实验展示出严格奖励在训练后期有助于突破训练瓶颈。

针对搜索引擎使用,研究团队设计了额外奖励机制:当一组rollouts中所有不使用搜索的尝试都失败,而如果有使用搜索的尝试成功时,给予这些rollout额外奖励,纠正模型过度依赖内部知识的倾向。

实验结果

7BDeepDiver媲美671BDeepSeek-R1

主要评测结果

研究团队在WebPuzzle及多个基准上进行了评测,包括C-simpleQA[ 8]、FRAMES-zh[ 9]和Bamboogle-zh[ 10],结果令人振奋:

表1:各模型在不同数据集上的表现对比,括号中的数字表示搜索轮次

三大关键发现:

1. DeepDiver大幅优于蒸馏模型:在WebPuzzle上,DeepDiver-Pangu-7B达38. 1%,远远超过了蒸馏版本的模型,提升明显;使用了同样训练方法的DeepDiver-Qwen2. 5-7B准确率达37. 6%,比R1蒸馏版提升近8个百分点;这说明了基于真实互联网的强化学习环境和训练语料能够大幅提升模型的信息索取能力。

3. 优异的跨任务泛化能力:虽然模型主要在WebPuzzle上训练,但在其他数据集上同样表现卓越,验证了整个DeepDiver框架和SIS带来的强大的泛化能力。

图4:训练阶段搜索轮次与奖励值的相关性,搜索强度增加伴随训练奖励上升

深入分析

SearchIntensityScaling的魅力

排除知识记忆因素的公平对比

在主试验中,研究团队发现DeepDiver在非WebPuzzle的榜单上尽管提升明显,但是仍然落后于DeepSeekR1,QwQ等模型。该团队提出一个问题,DeepDiver落后于这些模型到底是因为InformationSeeking的能力不如这些Baseline,还是因为这些Baseline的参数量较大,预训练阶段已经内化了这些榜单的知识源?

为验证DeepDiver在信息检索方面的真实能力,他们设计了「公平对比」实验:排除模型仅靠内部知识就能回答的问题,只比较需要外部检索的问题上的表现。

图5:排除内部知识可解问题后的评估结果对比

结果表明,在难以通过内部知识解决的问题上,DeepDiver超越或匹敌所有基线模型,甚至包括DeepSeek-R1。这证实了DeepDiver在WebPuzzle完整数据集上未能全面超越671B基线模型的主要原因,是参数规模而非检索能力限制。而对于检索能力本身而言,DeepDiver则表现出了非常强大的能力,能够让7B模型与超大规模LLM性能相当。

与基于Wiki环境和语料的训练方法的同期工作的对比

为了与同期工作进行对比,尽管DeepDiver完全使用中文训练,研究团队仍在英文基准测试中借助英文搜索引擎进行了评估,并与同期工作进行比较,如下表所示,其中R1-Searcher是基于Wiki环境和语料训练,DeepResearcher是基于Wiki语料和真实搜索环境训练:

表2:英文评估数据集上使用英文搜索引擎环境的对比结果

结果显示,基于真实互联网语料和环境训练的DeepDiver,尽管没有在训练中接触英文训练语料和搜索环境,DeepDiver凭借SIS在绝大多数任务上仍超越了基于Wiki训练的基线模型,凸显了SIS的强大性能和解决难题时的适应能力。

搜索强度与问题难度的关系

DeepDiver展现出卓越的搜索强度自适应能力,随着问题难度增加,模型会增加搜索轮次:

表3:WebPuzzle不同子集的性能表现

特别是与DeepSeek-R1相比,DeepDiver在超难子集上取得显著领先:平均2. 6轮搜索带来3.7个百分点的优势,而DeepSeek-R1仅使用1. 59轮搜索就妥协于一个不那么令人满意的结果。

两阶段奖励函数设计的关键作用

在训练过程中,研究团队发现后期性能常陷入瓶颈。通过对比不同奖励函数的效果,他们得出重要结论:

图6:不同奖励函数的训练效果,宽松奖励稳定初期训练,严格奖励突破后期瓶颈

宽松奖励有助于稳定强化学习初期阶段,而严格奖励则能在后期突破性能瓶颈。切换到严格奖励后,WebPuzzle上的得分提高了近9个百分点(从29. 1%升至37. 6%)。

开放式长文问答任务的惊人泛化

DeepDiver仅在WebPuzzle封闭式问题上训练,但能够出色泛化到开放式问答任务:

表4:ProxyQA数据集上的表现对比

在长文生成评测基准ProxyQA上,DeepDiver得分达32. 72%,比R1蒸馏模型高出9. 47个百分点,同时生成更长、更全面的回答,展现出卓越的知识密集型长文生成能力。在没有cherrypicking的情况也能一眼看出DeepDiver和蒸馏模型生成结果的区别。

Information-Seeking各类行为分析和统计

研究团队详细统计了不同模型在各类数据集上的信息搜索行为:

表5:多个模型在WebPuzzle和基于wiki数据集上的行为统计

结果表明,WebPuzzle比现有Wiki数据集更具挑战性,需要更复杂的信息搜索行为。而DeepDiver模型相比其他基线模型表现出更多样化和复杂的信息搜索行为,展示了在真实网络环境中训练的优势。

未来展望与局限性

尽管DeepDiver获得了正向的实验结果,但研究团队仍然认识到以下几点局限和未来研究方向:

1. WebPuzzle的持续演化:随着LLM预训练的不断扩展,如何持续构建有效的benchmark来适配与时俱进的LLM,是一项长期挑战。

2. 开放式任务的RL框架优化:为开放式问题设计更有效的RL框架,解决长文生成等任务的奖励设计难题。

3. 冷启动SFT与RL的动态衔接:探索自适应流程,让LLM按需动态地从SFT切换到RL,提升训练效率。

4. 工具生态的扩展:除搜索引擎外,扩充浏览器引擎、Python解释器、本地知识库等工具,进一步增强信息获取能力。

5. 模型规模和序列长度的扩展:基于昇腾平台,在更大模型规模上进行验证,推动产品应用和落地部署。

6. SIS影响机制的系统性分析:探究基座模型能力、训练数据构成、算法设计等多种关键因素对实现SIS效果的影响规律,深入分析和进行消融实验。

总结

DeepDiver系统地探讨了LLM在真实互联网环境下解决知识密集型问题的能力。通过强化学习与真实互联网搜索引擎的结合,该研究实现了SearchIntensityScaling,使模型能根据任务难度自适应调整搜索强度。在WebPuzzle和多项基准测试中,7B规模的DeepDiver展现出与671BDeepSeek-R1相当的表现,验证了该方法的有效性。AgenticRL训练技术在Agent发展中逐步显现出重要价值,本工作提供了搜索引擎环境下的具体参考。

References:

©THEEND

转载请联系本公众号获得授权

投稿或寻求报道:liyazhou@jiqizhixin. com