苹果研究发现:DeepSeek-R1/o3/Claude都是假“思考”!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

关于大型推理模型LRMs(o3-mini、DeepSeek-R1、Claude-3. 7-Sonnet),苹果公司发表了一篇研究发现尽管这些模型具备复杂的自我反思机制,但在问题复杂性超过一定阈值后,其推理能力会完全崩溃,这揭示了当前LRMs在发展可泛化推理能力上的根本局限性。

《思考的幻觉:通过问题复杂性的视角理解推理模型的优势与局限》

Apple研究人员设计了一个可控的实验测试平台,利用算法谜题环境来评估LRMs的推理能力。这些谜题环境允许精确控制问题复杂性,同时避免了现有基准中的数据污染问题。

四种谜题环境的示意图。各列展示了谜题从初始状态(顶部)经过中间状态(中部)到目标状态(底部)的演变过程,包括:汉诺塔(圆盘在柱子间的转移)、跳棋(彩色棋子的位置互换)、过河问题(将实体运过河)以及积木世界(堆叠重构)。

通过调整问题规模N(如圆盘数量、棋子数量等)来控制问题复杂性,并生成25个样本以报告每个模型的平均性能。

1、三种复杂性模式

低复杂性任务:标准LLMs的表现优于LRMs,推理模型在token效率上不如标准模型。

中等复杂性任务:LRMs开始展现出优势,能够生成更长的思考链,从而提高性能。

高复杂性任务:两种模型的性能都完全崩溃。尽管LRMs在一定程度上延迟了性能崩溃,但最终仍无法避免。

2、推理模型的性能崩溃

性能崩溃:随着问题复杂性的增加,所有推理模型的准确率逐渐下降,直到在特定复杂性阈值后完全崩溃。

推理努力的反直觉下降:在接近崩溃点时,尽管问题复杂性增加,模型的推理努力(以推理时的token数衡量)却开始下降,这表明LRMs在面对高复杂性问题时存在根本的推理能力限制。

通过提取和分析模型的中间解决方案,研究了推理痕迹中的模式和特征。

左下角和中间:在低复杂性情况下,非思考模型更准确且token效率更高。随着复杂性的增加,推理模型表现更好,但需要更多的token。右下角:对于正确解决的情况,Claude3. 7Thinking在低复杂性时倾向于早期找到答案,而在高复杂性时则更晚找到答案。在失败的情况下,它通常会专注于一个早期的错误答案,浪费剩余的token预算。这两种情况都揭示了推理过程中的低效性。

复杂性依赖的推理模式:

在简单问题中,推理模型通常能早期找到正确解决方案,但会继续探索错误的替代方案(“过度思考”现象)。

在中等复杂性问题中,模型在探索了大量错误路径后才找到正确解决方案。

在高复杂性问题中,模型完全无法找到正确解决方案。

精确计算的局限性:(a)和(b)即使在提供了明确的解决方案算法的情况下,推理模型在执行逻辑步骤时仍表现出局限性,这表明它们在验证和执行逻辑步骤方面存在根本问题。

不同谜题类型的行为差异:(c)和(d)例如,Claude3. 7Sonnet模型在汉诺塔问题中可以执行多达100步的正确移动,但在过河问题中却只能执行4步正确的移动,这可能表明模型在训练过程中对某些问题类型的接触较少。

推荐阅读

•动手设计AIAgents:(编排、记忆、插件、workflow、协作)

•DeepSeekR1+Agent的下半场

•单智能体(Agent):企业员工AI助理

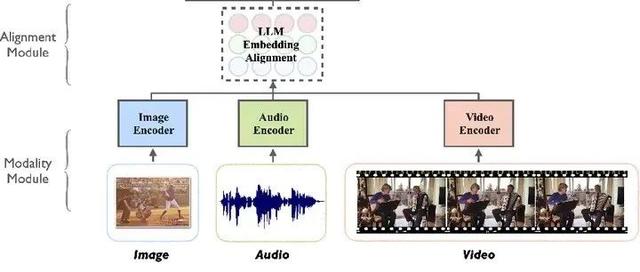

•Agent到多模态Agent再到多模态Multi-Agents系统的发展与案例讲解(1. 2万字,20+文献,27张图)

欢迎关注我的公众号“PaperAgent”,每天一篇大模型(LLM)文章来锻炼我们的思维,简单的例子,不简单的方法,提升自己。