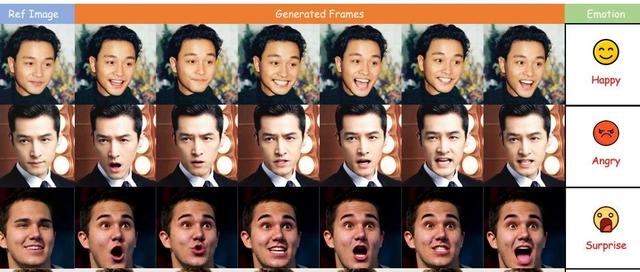

告别’纸片人’试衣!阿里&浙大提出3DV-TON,用3D几何骨架+动态纹理场,让虚拟模特’活’出真实衣褶!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

阿里联合浙大提出3DV-TON,可生成高保真度和时间一致的视频试穿结果,3DV-TON是一种基于几何和纹理3D引导的新型扩散框架。可处理各种类型的服装和身体姿势,同时准确还原服装细节并保持一致的纹理运动。

通过利用SMPL作为参数化人体几何结构,并使用单幅图像重建的3D人体作为可动画化的纹理3D引导,提供特定帧的外观条件,3DV-TON缓解了现有方法过度关注外观保真度而导致的结果不一致这一关键限制。该框架能够在不同的姿势和视角下学习几何上合理的人体,同时保持服装纹理运动的时间一致性。

论文:https ://arxiv. org/pdf/2504. 17414

主页:https ://2y7c3. github.io/3DV-TON

代码:(Comingsoon…)

视频试穿将视频中的服装替换为目标服装。现有方法在处理复杂的服装图案和多样的身体姿势时难以生成高质量且时间一致的结果。论文提出了3DV-TON,这是一个基于扩散的新型框架,用于生成高保真度和时间一致的视频试穿结果。提出的方法采用生成的可动画的纹理3D网格作为明确的帧级指导,从而缓解模型在运动连贯性扩展时过分关注外观保真度的问题。这是通过在整个视频序列中直接参考一致的服装纹理运动来实现的。所提出的方法具有用于生成动态3D指导的自适应流程:

选择初始2D图像试穿的关键帧,

重建和制作与原始视频姿势同步的纹理3D网格的动画。

然后论文介绍了一种矩形蒙版策略,该策略成功地减轻了动态人体和服装运动过程中服装信息泄露造成的伪影传播。为了推进视频试穿研究,推出了HR-VVT,这是一个高分辨率基准数据集,包含130个涵盖多种服装类型和场景的视频。定量和定性结果均表明,论文提出的方法性能优于现有方法。

3DV-TON的整体流程。给定一段视频,首先使用3D引导流程自适应地选择帧I,然后重建带纹理的3D引导,并使其与原始视频(即V)对齐,从而进行动画制作。对服装图像C和试穿图像Ct使用引导特征提取器,并使用去噪UNet中的自注意力机制进行特征融合。

3DV-TON是一种基于几何和纹理3D引导的新型扩散框架。通过利用SMPL作为参数化人体几何结构,并使用单幅图像重建的3D人体作为可动画化的纹理3D引导,提供特定帧的外观条件,3DV-TON缓解了现有方法过度关注外观保真度而导致的结果不一致这一关键限制。该框架能够在不同的姿势和视角下学习几何上合理的人体,同时保持服装纹理运动的时间一致性。对现有数据集以及论文新引入的HR-VVT进行的定量和定性评估,证明了其在视频试穿任务中的最佳性能。

感谢你看到这里,也欢迎点击关注下方公众号并添加公众号小助手加入官方读者交流群,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、StableDiffusion、Sora等相关技术,欢迎一起交流学习💗~