伯克利斯坦福联手造出「科研预言家」:77%准确率押注研究想法前景

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

论文:PredictingEmpiricalAIResearchOutcomeswithLanguageModels链接:https ://arxiv. org/pdf/2506. 00794

AI研究就像开盲盒——90%的论文想法看似惊艳,实际一试就翻车!但验证一个想法平均要烧103小时人力+大量算力。人类专家主要靠经验押注,新手容易踩坑。

关键问题:AI能否在实验前预测哪个想法更靠谱?

在两个相互竞争的研究想法之间进行比较(例如,两种越狱方法),预测哪一个在一组基准测试中表现更好。

研究者可以通过实际实现这两个想法来获得真实的评估结果;因此,某个想法只有在真正有效的情况下才能获胜,而不是因为它“看起来”新颖或令人兴奋。

研究团队给GPT-4. 1开了个“科研速成班”:

高可信度的「科研题库」。研究团队从ACL、NeurIPS、CVPR等顶会(覆盖NLP、ML、CV、机器人等领域)中,系统性提取了7585个想法对比案例(训练集6000对+测试集1585对)。每个案例包含:研究目标(如“破解LM的攻击方法对比”)、两个竞争想法的详细描述、基于3-4个基准测试的客观结果标签(通过多数投票确定胜负)。

「科研规律」预测训练:采用监督微调(SFT)策略,使用6000个历史想法对训练GPT-4. 1,目标是学习“想法描述→基准表现”的映射关系。

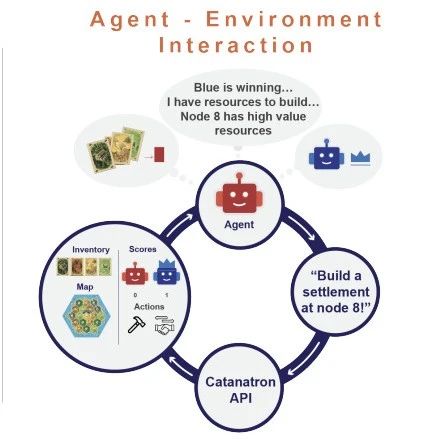

为模型配备「智能文献助手」:为LLM论文检索代理模块,检索代理会自动生成查询、搜索相关论文、总结全文内容并过滤无关信息,帮助模型获取间接知识。

神奇设定:模型不借助任何实验验证,只能靠“推理”押注!

公开题库测试:经过训练的AI系统准确率77%,而现有的顶尖模型(如Claude3. 5)纯靠猜(50%左右准确率)。

人类专家团战:25位NLP专家组队分析45道题,5人一组讨论45分钟,结果……多数投票准确率仅48. 9%!AI以64. 4%完胜。

不吃“名校情结”这一套:给失败想法贴上“DeepMind出品”等名校标签后,AI准确率基本不受影响。

用未发表的35个AI原创点子测试(比如让ChatGPT自己想研究课题),AI预测器仍拿下63. 6%准确率!这意味着:

AI可辅助AI科研:帮模型筛选高潜力点子,避免无效烧钱。

破除“花架子迷信”:人类偏爱复杂数学包装的想法,而AI更关注实际效果。

这套系统像“科研加速器”:

短期:帮实验室优先验证高潜力想法,省下百万级算力成本。

长期:接入AI科研全流程(生成想法→预测效果→自动实验),让AI自己迭代升级!

解释力与可靠性:当前系统是黑箱标签预测,还需破解“为什么这个想法能成”。

备注:昵称-学校/公司-方向/会议(eg. ACL),进入技术/投稿群

id:DLNLPer,记得备注呦