InstructSAM, 无需训练! 根据指令检测及分割一切目标!(附论文及源码)

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

以下文章来源于微信公众号:遥感与深度学习

作者:遥感与深度学习

链接:https ://mp. weixin.qq. com/s/FiCPh7F19PZUdFuxeVsI7Q

本文仅用于学术分享,如有侵权,请联系后台作删文处理

导读

本文提出一种无需训练的指令驱动目标计数、检测与分割方法InstructSAM,并构建了遥感领域开放词汇与开放式基准数据集EarthInstruct。该方法通过计数约束的掩码-标签匹配,实现高效、置信度无关的目标识别,显著提升零样本泛化能力。

题目:InstructSAM:ATraining-FreeFrameworkforInstruction-OrientedRemoteSensingObjectRecognition

论文:https ://arxiv. org/abs/2505. 15818

主页:https ://VoyagerXvoyagerx. github.io/InstructSAM/

年份:2025

单位:中科院空天院,哈工大,上海交通大学,卧龙岗大学

注:本篇由论文原作者审阅

基于自然语言指令的目标识别已成为计算机视觉领域的一种强大范式。然而,语义多样的训练数据的缺乏,限制了视觉语言模型在遥感领域的零样本泛化能力。

本文提出了InstructSAM,一种无需训练的框架,用于指令导向的目标计数、检测和分割(InstructCDS)任务;以及涵盖开放词汇(open-vocabulary)、开放式(open-ended)和开放子类别(open-subclass)设定的基准数据集EarthInstruct。通过将目标检测重新建模为计数约束的掩码-标签匹配问题,InstructSAM实现了无需置信度的目标识别,并且推理时间几乎不受目标数量的影响。

开放词汇:识别用户指定的类别(如\“足球场\“、\“停车场\“)。

开放目标:识别所有可见目标。

开放子类别:识别父类中的目标。

除了上述三种基本指令设定外,EarthInstruct允许针对不同数据集设计专用提示,以指导LVLM根据特定标注规则识别目标,从而应对多样化的用户需求和现实世界的数据集偏差。

NWPU-VHR-10和DIOR数据集的标注偏差示例

为了应对训练数据缺乏、指令复杂多样的挑战,InstructSAM将指令导向的目标检测分解为三个更容易实现的步骤:

指令导向的目标计数:大型视觉语言模型(LVLM)解释用户指令并预测目标类别和数量。

类别无关掩码生成:SAM2自动生成高质量的掩码提案,与指令处理并行。

计数约束的掩码-标签匹配:遥感CLIP模型计算预测类别与掩码提案之间的语义相似性。通过将目标检测和分割问题重新建模为掩码-标签匹配问题,融合语义相似性与全局计数约束,使用二元整数规划(BIP)求解器得到匹配结果。

推理中间步骤可视化

不同指令设定下的识别结果对比

本文选取Qwen2. 5-VL-7B和GPT-4o作为目标计数器,SAM2作为候选掩码生成模型,GeoRSCLIP进行相似度计算。

最先进的性能:在EarthInstruct基准上,InstructSAM在多个指令设置和任务种类上的零样本表现,超过了在遥感目标检测和分割数据上训练过的模型。

无需训练与置信度:无需特定任务上的训练或微调,预测过程无需置信度阈值过滤。

高效推理:推理时间几乎不受目标数量的影响,显著减少了输出词元数和总运行时间。

强大的泛化能力:在配备通用CLIP模型时,能够有效识别自然图像中的目标。

开放词汇识别结果

开放目标识别结果

开放子类别识别结果

推理时间分析

在开放式目标识别的指令设定下,InstructSAM展现出近乎常数(和预测的边界框数量无关)的推理时长,而其他方法的推理时间会随目标数量线性增长。与将边界框表示为自然语言词元(token)的方法不同,InstructSAM-Qwen相比Qwen2. 5-VL减少了89%的输出词元数和32%的总推理时间。随着模型规模的扩大,这一优势更加显著,凸显了InstructSAM框架的高效性。

泛化至自然图像

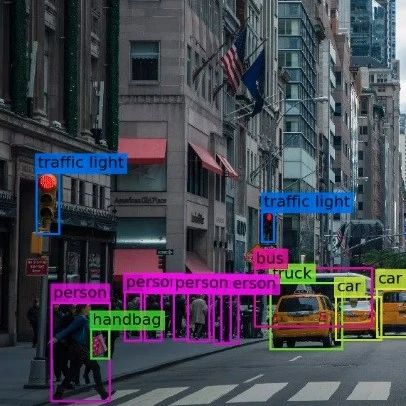

InstructSAM的基础模块可以根据使用需求灵活替换。使用通用CLIP模型时,InstructSAM也可以识别自然图像中的目标。

提示词工程

根据数据集的标注规则设计提示词,可以显著提高GPT-4o的开放词汇目标计数的性能,甚至和闭集的Faster-RCNN模型(使用先检测后计数的方法)相当。

无需置信度的方法

传统检测器的最终预测结果往往需要使用一个固定的置信度阈值来过滤低质量的预测框。而面对训练集分布以外的输入,一个固定的置信度的阈值无法让所有图像和所有类别的性能都达到最优。InstructSAM使用计数作为约束,无需使用置信度阈值进行过滤,对不同图像和不同类别目标的适应性更强。

局限性与未来方向

InstructSAM的性能依赖于基础模型(LVLM、SAM、CLIP)的能力。未来随着这些遥感基础模型的进步,特别是在语义信息更丰富的遥感数据上训练,可以进一步提升InstructSAM的能力。

欢迎加入《AI未来星球》,一起成长

扫描下方二维码即可加入~

真诚分享AI落地过程(AI商机->项目签约->算法开发->产品开发->实施运维)中的各方面经验和踩过的坑。

你可以获得什么?

1、大白之前花费10W+购买,AI行业各场景私有数据集下载,星球内倾情分享;2、AI行业研发、产品、商业落地问题咨询(目前AI公司创业中),都可获高质量解答,有效期一年,无限次提问,有问必答。3、定期邀请AI行业各类嘉宾分享,创业/商业等方面的经验!

帮助你解决遇到的实际问题,升职加薪!

大家一起加油!