字节、港理工提出超强统一视觉生成模型 Many-for-Many,支持10+任务,8B参数“逆袭”商业视频生成引擎。

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

字节、港理工提出超强统一视觉模型Many-for-Many,如何凭它让8B模型“逆袭”商业引擎?

字节跳动与香港理工大学提出统一框架Many-for-Many,它借助众多视觉生成和操作任务的训练数据,为不同任务训练单个模型。具体做法是设计轻量级适配器统一不同任务的条件,采用联合图像-视频学习策略逐步训练。该框架通过联合学习形成统一模型,提升视频生成性能,还引入深度图辅助模型感知3D空间。模型有8B和2B两种版本,均能执行10多种任务,其中8B模型在视频生成任务上性能比肩开源甚至商业引擎。

论文:https ://arxiv. org/pdf/2506. 01758

项目:https ://github. com/leeruibin/MfM. git

主页:https ://leeruibin. github.io/MfMPage/

扩散模型在许多视觉生成和操作任务中展现了令人印象深刻的性能。许多现有方法专注于针对特定任务训练模型,尤其是文本转视频(T2V)生成;而许多其他研究则侧重于对预训练的T2V模型进行微调,以用于图像转视频(I2V)、视频转视频(V2V)、图像和视频操作等任务。然而,训练一个强大的T2V基础模型需要大量高质量的标注,这非常昂贵。此外,许多现有模型只能执行一项或多项任务。

本研究引入了一个统一的框架,即多对多(many-for-many),它利用来自许多不同视觉生成和操作任务的可用训练数据,为这些不同的任务训练一个模型。具体而言,论文设计了一个轻量级适配器来统一不同任务中的不同条件,然后采用联合图像-视频学习策略从头开始逐步训练模型。通过联合学习方法最终构建了一个统一的视觉生成和操作模型,并提升了视频生成性能。此外,我们引入深度图作为条件,以帮助我们的模型在视觉生成中更好地感知三维空间。我们训练了两个版本的模型,分别使用不同的模型大小(8B和2B),每个版本都可以执行10多种不同的任务。尤其值得一提的是,我们的8B模型在视频生成任务中展现出与开源甚至商业引擎相比极具竞争力的性能。

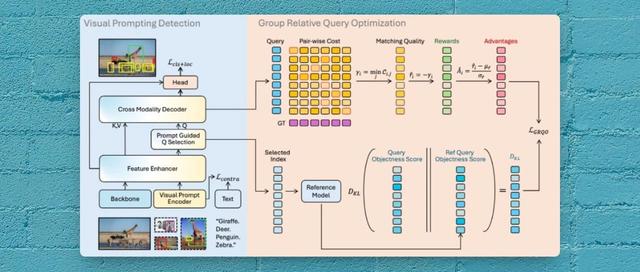

多对多(MfM)统一训练框架的整体架构如图2所示。本质上,我们的模型是一个具有3D全注意力机制的扩散变换器(DiT),并使用流匹配技术进行训练。视频和文本提示分别使用视频VAE和LLM文本编码器进行编码。为了减轻对T2V训练数据高昂标注成本的高度依赖,并充分利用来自各种视觉生成和操作任务的现有训练数据,论文引入了一个有效且轻量级的适配器,用于统一不同任务之间的各种条件。然后,我们开发了一种渐进式联合训练策略,以训练一个用于多种视觉生成和操作任务的统一模型。

一些视觉生成和操作任务的条件输入示例。在每个任务块中,从左到右,条件分别为面向任务的像素数据、深度图和掩码输入。掩码由二进制黑白像素组成,其中白色像素表示以像素数据为条件的区域,黑色像素表示待生成的区域。

MfM(多对多)模型是一个统一的视频基础模型,能够通过单一参数高效的架构处理各种视觉生成和操作任务。具体而言,论文设计了一个轻量级适配器,能够有效地将各种二维和三维条件统一到一个统一的表征空间中,从而无缝集成到我们的视频生成流程中。通过采用渐进式联合图像-视频学习和多任务训练策略,我们不仅能够在单个模型中实现多种视觉生成和操作功能,还能将其他图像任务中的知识迁移到视频生成。这种知识共享显著减少了所需的昂贵文本转视频训练数据量,并增强了基础视频生成能力。经实验验证,MfM在使用更少训练数据和模型参数的情况下,实现了与专用模型甚至商业系统相比具有竞争力甚至更优异的性能。

感谢你看到这里,也欢迎点击关注下方公众号并添加公众号小助手加入官方读者交流群,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、StableDiffusion、Sora等相关技术,欢迎一起交流学习💗~