告别微调时代:拖拽式LLMs实现12000倍加速适配,输入描述,秒级定制LLM,效果、速度全面超越

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

大型语言模型(如GPT-4、Llama、Qwen)虽具备强大的零样本能力,但实际落地常需针对特定任务定制模型行为。传统高效微调技术(如LoRA)虽减少参数量,仍需对每个新任务进行数小时至数天的训练,成为大规模部署的瓶颈。

论文:Drag-and-DropLLMs:Zero-ShotPrompt-to-Weights链接:https ://arxiv. org/pdf/2506. 16406

本文提出Drag-and-DropLLMs(DnD),彻底颠覆\“数据→梯度→权重\“的优化范式:仅需输入目标任务的未标注提示(prompt),即可在秒级生成适配的LoRA权重。DnD的核心是一个预训练的\“提示到权重\“映射器,其意义在于:

将LLM定制成本降低4个数量级;

在未见任务上实现最高30%的性能跃升;

证明神经网络权重本身可视为一种可生成的数据模态,为AI模型部署开辟全新可能。

目标:将任务提示直接映射为适配权重,绕过梯度下降。

实现三步曲:

收集多个任务(如ARC科学问答、Python代码生成)上训练的LoRA检查点(即权重矩阵)。

关键洞见:任务样本(提示)是数据集的\“指纹\“。从每个数据集采样提示批次,与对应检查点随机配对,形成{提示批次,LoRA权重}训练对。

示例:为数学数据集生成权重时,输入\“解方程x²-5x+6=0\“这类提示,而非标注答案。

使用轻量文本编码器(如Sentence-BERT)将提示映射为紧凑条件向量:其中=提示文本,=编码器参数,=输出嵌入。

设计考量:编码器需平衡语义表征能力(捕捉任务特性)与效率(避免成为新瓶颈)。

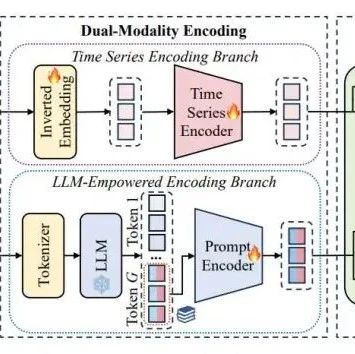

核心组件:级联超卷积解码器。

运作原理:

将条件向量作为输入,通过多级卷积块逐步扩展为完整LoRA矩阵。

每级包含三类卷积操作:宽度卷积(Con_{VW}):沿通道-长度维度融合特征高度卷积(Con_{VH}):沿长度-层维度融合特征层间卷积(Con_{VL}):跨层传递信息

通过分层特征变换,最终输出匹配Transformer各层的LoRA矩阵。

训练目标:最小化生成权重与真实LoRA权重的均方误差(MSE)。

实验覆盖四大任务类型:常识推理(ARC,BoolQ)、数学求解(GSM8K,MATH)、代码生成(HumanEval)、多模态推理(MathVista),测试模型规模(0. 5B7B)。0. 7秒,比全量微调(数小时)加速12,000倍。

常识推理:在未见测试集(如ARC-c)上,DnD比训练用LoRA平均精度提升21%。

跨域迁移:用常识推理训练的DnD,处理科学数据集时精度仍超越专用LoRA30%。

代码/数学:在HumanEval基准上,pass@1达32. 7%(比基础LoRA↑15. 1%);GSM8K数学精度66. 3%(↑23. 4%)。

DnD在7个常识推理数据集上的零样本精度全面超越训练阶段见过的LoRA适配器。DnD在代码生成(pass@k)、数学求解(GSM8K/MATH)、多模态(Math-Vision)任务上显著超越训练用LoRA。

时间开销:生成一个任务适配权重仅需0. 1

计算开销:内存占用<21GB(单卡A100),适合边缘部署。

vs少样本学习(图c):DnD仅用128个无标注提示,性能即超越需256标注样本的少样本微调(FS)和上下文学习(ICL)。

模型规模:从1. 5B扩展至7B模型,在LiveCodeBench编码基准上pass@1达33. 3%(↑20. 3%)。

多模态适配:将Qwen-VL在MathVista的精度从61. 5%提升至62. 3%,证明文本驱动的权重生成可泛化到视觉语言模型。

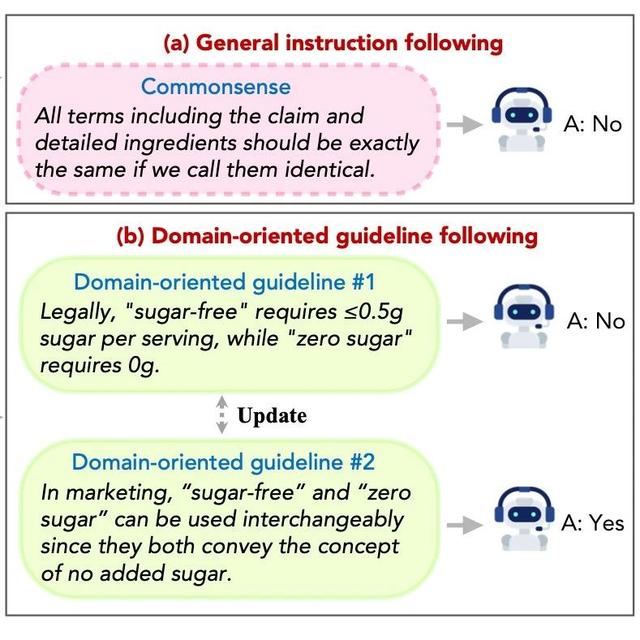

实验证据:使用\“提示+答案\“作为条件时,常识推理精度从51. 6%暴跌至27%。

归因分析:分类任务答案(如A/B/C/D)缺乏多样性,混淆数据集特征表达;而提示文本蕴含丰富任务语义。

例外:数学任务因答案复杂多样(如解题步骤),作为条件时精度达64. 0%,但仍低于提示(66. 3%)。

三维张量处理:将条件嵌入视为张量(B=批大小,N=层数,L=长度,C=通道),通过并行卷积挖掘权重矩阵的层间关联与内部结构。

对比RPG:RPG依赖循环扩散生成权重,难以处理语言提示的语义复杂性;DnD的卷积架构显式建模权重空间拓扑。

关键实验:当训练数据集从6个减至2个时,DnD性能接近随机(改进仅0. 8%)。

结论:DnD通过跨任务相关性学习\“提示→权重\“映射,数据多样性是其泛化基石。

挑战传统认知:证明梯度下降非模型适配唯一路径,权重本身可视为生成目标。

新研究框架:为\“权重即数据\“(WeightsasData)范式提供实证,开辟基于提示的模型编程(Prompt-to-WeightsProgramming)方向。

DnD通过\“提示→权重\“的直接映射,实现了LLM的秒级免训练适配,在效率(12,000倍加速)、性能(零样本任务最高提升30%)和泛化性(跨任务/模态/模型规模)上取得突破。其核心价值在于:

技术层面:验证超网络生成高维权重的可行性,级联超卷积解码器是关键创新;

范式层面:打破\“梯度下降必要论\“,确立权重作为可生成数据模态的新研究方向;

应用层面:为低延迟、高隐私的模型定制提供工具,推动LLM普惠化部署。

建议大家感兴趣的还是去读读原文吧!真的很不错~

备注:昵称-学校/公司-方向/会议(eg. ACL),进入技术/投稿群

id:DLNLPer,记得备注呦