ACL 2025 | 指令遵循不能仅靠常识?GuideBench 揭示大模型如何“踩雷”领域指南规则

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

在AI领域,大模型智能体的发展日新月异。我们今天要介绍的这篇ACL2025主会论文——《GuideBench:BenchmarkingDomain-OrientedGuidelineFollowingforLLMAgents》,聚焦于如何提升智能体的指南规则遵循能力,使其在特定领域中遵循指令更加得心应手,为增强智能质检、信息审核等领域智能体的可靠性提供了新思路。

本文作者分别来自上海交通大学与抖音生活服务GenAI团队。第一作者刁凌霄来自上海交通大学,研究方向聚焦于大模型推理。共同通讯作者为杨成和张倬胜。杨成目前在抖音生活服务GenAI团队任职,曾就职于字节跳动AILab;张倬胜为上海交通大学长聘教轨助理教授,研究方向为自然语言处理、大模型智能体与安全。

30秒速读版本

区分于遵循模型常识的通用指令遵循,论文定义领域特有的规则为指南规则(Guidelinerules)。而此类指南规则主要有两个特点:1)与大模型习得的常识可能相悖;2)领域动态变化,领域指南规则也动态变化。随后文章提出GuideBench,一个旨在评估大模型智能体遵循指南性能的综合测试基准。GuideBench涵盖了7个不同类别的任务,共计1272个实例。我们在18个主流大模型上进行的大量实验显示,当前大模型在复杂场景下的指令遵循能力不足,尤其在数学任务上表现明显。此外,更深入的分析强调了领域指南的重要作用,并表明未来在提升当前大模型指令遵循能力方面存在巨大的改进空间。

大型语言模型已被广泛部署为能够自主决策并遵循用户指令的智能体,应用于各类现实世界场景。现有研究主要聚焦大模型的通用指令遵循能力,重心在大模型能否遵守模型固有的参数化知识。但在实际应用中,LLM的输出常需满足特定领域的规则和约束。我们定义这些规则为领域的指南规则——GuidelineRules。

对话内容

规则说明

【user】我之前订了机票,想改签,从天津到长沙,下周四出发。【assistant】这边先和您确定下旅行限制哈,想问下您对航班时间、舱位这些有啥特殊要求吗?【user】没啥特殊要求,就正常就行。【assistant】那我查查看,不过查完有合适航班我可能说不太清楚具体信息哦。【user】啊?那你查了再说呗。【assistant】嗯,查到有航班,但是具体起飞降落时间、舱位情况和价格我就不细说了,您自己看着办吧。

\“Guidelines\“:[{\“type\“:\“预订相关规则\“,\“rule_text\“:\“当用户目标是’预订’,订单信息显示未预定过航班,对话内容包含用户需求时,action为在航班信息数据中搜索可用航班;若有可用航班,回复话术为根据可用航班信息生成合理的推荐话术,向用户介绍可用航班情况,回应用户预订诉求,提供预订解决方案;若没有可用航班,回复话术为向用户说明没有找到符合需求的可用航班,并表示歉意\“},{\“type\“:\“改签相关规则\“,\“rule_text\“:\“当用户目标是’改签’,订单信息显示存在预订,对话内容包含用户需求时,action为与客户互动确定旅行限制;若确定旅行限制后在航班信息数据中有可用航班,回复话术为根据可用航班信息生成合理的改签推荐话术,向用户介绍可用改签航班情况,回应用户改签诉求,提供改签解决方案;若没有可用航班,回复话术为向用户说明没有找到符合需求的可用改签航班,并表示歉意\“},{\“type\“:\“取消机票相关规则\“,\“rule_text\“:\“当用户目标是’取消机票’,订单信息显示存在预订时,action为取消预订;回复话术为向用户说明机票已成功取消\“}]

例如,治理场景下的智能体对话判断任务,大模型需根据相应「领域指南规则」判断智能体客服回复用户问题是否满足设定标准。

在治理等垂直领域中,通用指令遵循难以满足领域的需求,遵循不同领域的指南规则可能使得模型生成与遵循常识不同的答案。

而指南规则往往存在两大特点。首先,指南规则可能与常识相悖;其次,由于领域场景不断更新,领域指南规则也不断更新。然而,当前评估主要聚焦于评估大模型能否遵循模型已知的通用指令遵循能力,缺乏评估大模型在领域指南规则方面的遵循能力的评估基准。

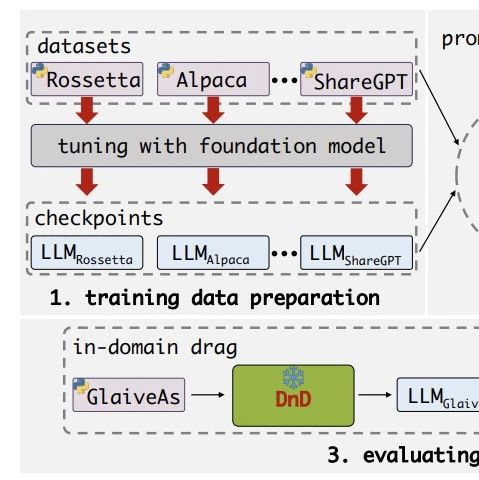

为破解这一难题,论文提出了定义了领域指南规则,并基于此设计了合成领域指南规则数据的流水线,生成了评估基准GuideBench,评估大模型的领域指南遵循能力。

GuideBench包括了7类任务,共计1272个。

数据收集

首先,我们确定那些对实际应用最为有利且在当前研究中尚未深入探索的任务类别。基于这一原则,我们优先考虑了比价判断同品、文本相关性、数学、智能聊天、文本总结生成和幻觉检测。随后,我们从这些类别中的实际应用案例中手动提取若干种子指令,并通过规则生成过程扩展,利用大语言模型生成出大量领域特定指导准则。

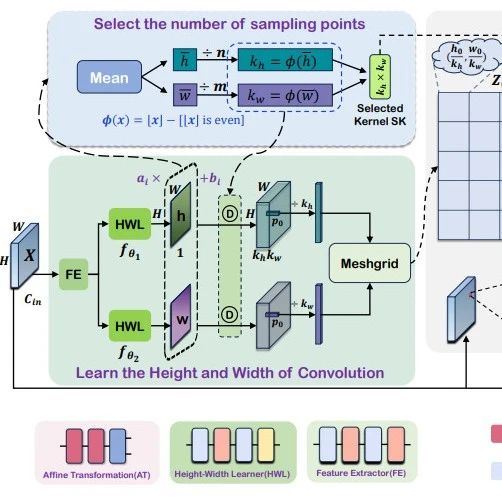

指南规则生成

首先依据包含总体任务目标、输入和输出规格以及规则构建详细要求的系统提示词,从中提取关键要素,包括任务目标、输入和输出规格以及规则集要求。基于提取出的要素,我们初始化规则集。每条规则由定义触发条件的条件部分和具体要采取行动的操作部分构成。随后,我们对规则进行分类,引入新类别以增强规则集的多样性和适用性。最后进行去重与质量筛查。

指南生成

生成单条指南规则后,对其抽取与组装为完整的指南,并采用三种不同的方法以提高多样性:

随机选取:在同一领域内随机选取n条指南规则组装成一个完整指南。

基于多样性的选取:在同一领域内优先选择不同类型的指南规则,以确保组装指南的多样性。

基于语义的选取:借助大语言模型,根据总体指令选择适宜的指南规则,将其组装为统一且具备语义连贯性的指南。

此外,对于面向特定领域的智能体系统,由于用户需求可能随时发生变化,智能体所依据的标准也在不断更新,而这种更新可能会从根本上改变回复内容。因此,提升智能体在用户提供指南发生更新时依然能够准确遵循指令的鲁棒性至关重要。

多回答生成

我们将生成的指南规则作为提示词,并利用大语言模型生成相关的文本上下文。随后,我们将生成的上下文与对应的指南规则整合,构造出问题,通过提示大语言模型生成答案质量不一的选项。

质量控制

对于领域专用智能体,生成符合用户偏好的内容至关重要。为确保内容质量和准确性,我们采用自动化与人工相结合的方法。首先利用大语言模型过滤规则,排除重复和低质量内容。其次,人工标注人员全面审核由大语言模型生成的标签,根据指南规则校正标签,并明确答案分析的模糊之处。

一个典型的多选任务主要包含以下四个组成部分:Instruction:任务的总体目标;Guidelines:一系列特定领域的规则,以指导任务完成;Context:相关的文本段落;MultipleOptions:对于问答任务,此部分可以省略,其他情况下为大语言模型生成的多样化回答集合。在大语言模型生成答案及对应解析后,依据人工标注数据对结果正确性进行评估,答案解析为结果提供了一定程度的可解释性。

实验结果

本文在GuideBench上对18个主流大模型的指令遵循能力进行评测。

实验结果显示,大多数大型语言模型在BENCH上整体表现不佳。即使对格式进行归一化后,不同模型间仍存在显著差异,反映出能力的不均衡。在具体任务层面,各模型在不同任务上优势与不足明显,尤其在数学推理方面仍面临显著挑战。

严格遵循指南规则对于完成任务至关重要

指南规则在使模型输出更贴合动态且多样化的领域需求方面发挥了关键作用。因此,指南规则不仅有助于提高完成准确率,同时也保持了任务特定的连贯性和可靠性,凸显了其对模型在各类任务中获得鲁棒性能表现的重要性。

当前存在模型可用性与模型性能的冲突

闭源模型虽性能出色,但并不适用于各种垂直领域;而开源模型(如Qwen系列)虽然可供使用,其性能波动较大,质量和稳定性方面仍与闭源模型存在差距。

思维链的影响

思维链能够提升模型在复杂任务上的表现,但对简单任务增益不强。且分析思维链发现,模型在简单任务上可能正确探索多条解决问题的路径,从而导致「过度思考」,造成资源浪费;在复杂任务中进行过度频繁的思维转换,进而导致「思考不足」,无法正确答题。

解耦知识推理与数学计算能够提升模型在复杂场景数学任务上的表现。

在表现最差的数学任务上实验,发现In-ContextLearning,如思维链、Few-Shotdemo或Program-of-Thought,在复杂数学任务场景下难以改善任务性能。分析模型的性能瓶颈在于:1. 领域知识理解不足:模型对电商场景中的专有概念(如特定商品不优惠等)存在认知偏差。2. 复杂约束推理失效:当题目包含多级条件(如优惠券叠加条件复杂)时,模型易遗漏规则。

认知负荷问题

内部负荷限制:参数量较小的模型,如Qwen2. 5-7B、Vicuna-7B与Llama3-8B-Instruct,往往在需要同时压缩输出内容与遵循输出格式的任务上表现不佳,暗示其超过了参数高效的注意力机制的能力限度。外部负荷敏感性:移除指南细则后,模型性能下降,意味着其完成任务不仅仅依赖内部参数。

近年来,大模型作为领域智能体的部署规模持续扩大,其性能表现高度依赖领域规则的适配质量。针对缺乏对领域指南遵循能力的评估基准的研究空白,本文创新性地提出了GuideBench,实现了对大模型智能体指南遵循的正确性、鲁棒性与是否对齐人类偏好的测评。实验结果表明,领域特定场景下大模型的指南遵循能力存在瓶颈,GuideBench为模型迭代提供了可量化的评估基准。

在未来研究中,我们期待从多语言、多模态和高效泛化等维度持续拓展大模型的指南遵循能力。一方面,可构建多语言数据集,引入治理相关的多领域指南,结合跨语言学习与语义对齐机制来提升模型对多语种规范的理解与一致性遵循能力;另一方面,考虑到现实任务中多模态数据(如文本、图像、结构化信息)的广泛存在,未来结合视觉语言模型,提升模型在复杂语境中的多模态理解与推理能力。此外,面对复杂规则任务中存在的理解困难与推理瓶颈,亟需研究更高效的泛化推理方法。

备注:昵称-学校/公司-方向/会议(eg. ACL),进入技术/投稿群

id:DLNLPer,记得备注呦