多模态任务大一统!蚂蚁推出Ming-Omni:图像、文本、语音三模态无缝融合,一网打尽复杂任务!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

Ming-lite-omni是Ming-omni的轻量版本,源自Ling-lite,具有28亿激活参数。Ming-lite-omni是一个统一的多模态模型,能够处理图像、文本、音频和视频,并在语音和图像生成方面表现出强大的能力。

统一全模态感知:Ming-lite-omni基于Ling构建,后者是一种MoE架构的LLM,通过模态特定的路由器解决任务冲突,并确保来自不同模态的令牌能够连贯地整合。

统一感知与生成:Ming-lite-omni实现了统一的理解和生成能力,使模型能够在生成过程中解释多模态指令和用户意图,这有助于提高生成质量并增强在多个任务中的可用性。

创新生成能力:Ming-lite-omni能够感知所有模态,并同时生成高质量文本、实时语音和生动图像,从而在包括图像感知、视听交互和图像生成在内的多样化任务中提供卓越的跨模态性能。

论文:https ://arxiv. org/pdf/2506. 09344

代码:https ://github. com/inclusionAI/Ming/tree/main

主页:https ://lucaria-academy. github.io/Ming-Omni/

试用:https ://www. modelscope.cn/models/inclusionAI/Ming-Lite-Omni

论文提出的Ming-Omni是一个统一的多模态模型,能够处理图像、文本、音频和视频,同时在语音和图像生成方面表现出色。Ming-Omni采用专用编码器从不同模态中提取token,然后由Ling(一种配备了新提出的模态专用路由器的MoE架构)进行处理。这种设计使单个模型能够在统一的框架内高效地处理和融合多模态输入,从而简化了各种任务的执行,而无需单独的模型、针对特定任务进行微调或结构重新设计。

更重要的是,Ming-Omni超越了传统的多模态模型,支持音频和图像生成。这是通过集成用于自然语音的高级音频解码器和用于高质量图像生成的Ming-Lite-Uni来实现的,这还使模型能够进行情境感知聊天、执行文本转语音以及进行多种图像编辑。我们的实验结果表明,Ming-Omni为跨所有模态的统一感知和生成提供了强大的解决方案。值得注意的是提出的Ming-Omni是所知的第一个在模态支持方面与GPT-4o匹敌的开源模型。

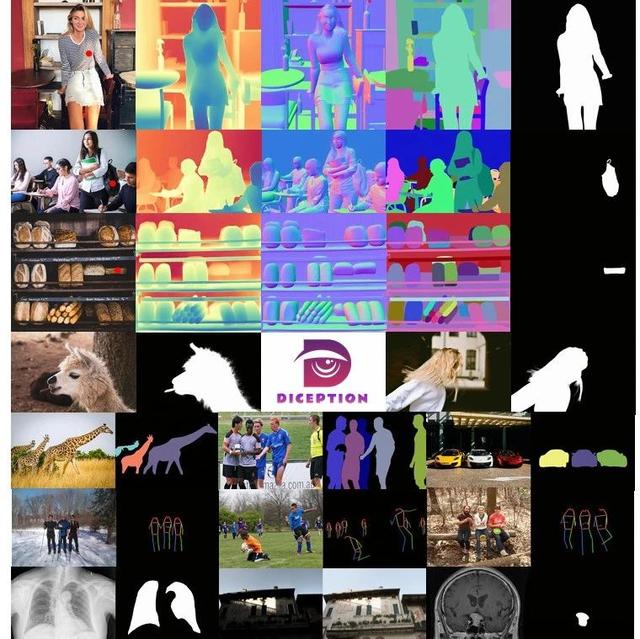

Ming-Omni的整体框架。Ming-Omni使用专用编码器提取视觉和音频token。然后,这些token与文本token组合,并通过Ling(一种MoE架构,带有特定模态路由器)进行处理。随后,它通过音频解码器生成语音,并通过扩散模型生成图像。

Ming-lite-omni在图像感知、视听交互和图像生成任务中展示了卓越的跨模态性能。具体来说,在图像感知任务中,Ming-lite-omni仅激活2. 8B参数就达到了与Qwen2.5-VL-7B相当的性能。它在端到端语音理解和指令跟随方面表现出色,超越了Qwen2. 5-Omni和Kimi-Audio。此外,它还支持原生分辨率图像生成、编辑和风格转换,GenEval得分为0. 64,优于SDXL等主流模型。在FID方面,Ming-lite-omni达到了4. 85,创下了现有方法的新SOTA。

SpeechQA

Ming-Omni是第一个在模态支持方面与GPT-4o匹敌的开源模型。它可以感知文本、图像、视频和音频模态,并实时生成文本、自然语音和图像。Ming-Omni基于LingMoE架构构建,并配备模态专用路由器以缓解模态冲突,在多模态交互和生成方面表现出色。Ming-Omni仅激活28亿个参数就达到了与Qwen2. 5-VL-7B相当的性能,并在端到端语音理解和语音指令跟踪方面展现了SOTA性能。此外,Ming-Omni还支持原始分辨率图像生成、编辑和风格迁移,超越了SDXL等主流生成模型。总而言之,MingOmni在多模态感知和生成任务中展现出强大的适应性和效率,展现出未来研究和工业应用的光明前景。

感谢你看到这里,也欢迎点击关注下方公众号并添加公众号小助手加入官方读者交流群,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、StableDiffusion、Sora等相关技术,欢迎一起交流学习💗~