超越SOTA!浙大&斯坦福提出 DiffLocks,单图头发 3D 重建精度提升30%,首次支持非洲式卷发生成!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

由浙江大学、斯坦福大学等联合提出的DiffLocks,给定一张RGB图像,DiffLocks使用扩散模型生成精确的3D发束。该模型基于一个包含RGB图像和相应3D发束的新型合成头发数据集进行训练。

论文:https ://arxiv. org/pdf/2505. 06166

主页:https ://radualexandru. github.io/difflocks/

代码:https ://github. com/Meshcapade/difflocks

数据集:https ://difflocks. is.tue. mpg.de/index. html

我们致力于从单张图像重建头发的三维几何结构,由于发型的多样性以及缺乏图像到三维头发的配对数据,这项任务极具挑战性。之前的方法主要基于合成数据进行训练,并通过使用低维中间表征(例如引导发束和头皮级嵌入)来应对此类数据量有限的问题,而这些表征需要后期处理才能解码、上采样并增强真实感。这些方法无法重建头发细节,难以处理卷发,或者仅限于处理少数几种发型。

为了克服这些限制,论文提出了DiffLocks,这是一个新颖的框架,可以直接从单张图像重建各种发型的精细结构。首先,我们通过自动创建迄今为止最大的合成头发数据集(包含4万种发型)来解决3D头发数据不足的问题。其次,论文利用合成头发数据集学习一个基于图像的扩散变换器模型,该模型可以从单张正面图像重建精确的3D发束。通过使用预训练的图像主干,我们的方法即使仅基于合成数据进行训练,也能推广到自然图像。该扩散模型可以预测头皮纹理图,其中任意一点都包含单根发束的潜在编码。这些编码可直接解码为三维发束,无需后处理技术。通过表示单根发束而非引导发束,Transformer能够建模复杂发型的详细空间结构。借助此功能,DiffLocks首次能够从单张图像中重建高度卷曲的头发,例如非洲式发型。定性和定量结果表明,DiffLocks的性能优于现有的最先进方法。数据和代码可供研究使用。

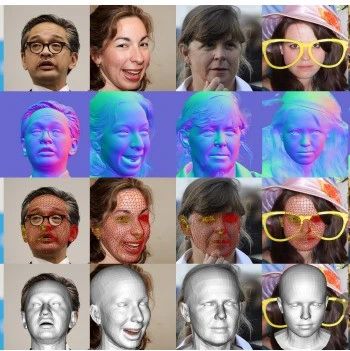

DiffLocks流程概览。给定一张RGB图像,我们使用预训练的DINOv2模型提取局部和全局特征,用于指导头皮扩散模型。头皮扩散模型对密度图和包含发束几何潜在编码的头皮纹理进行去噪。最后,我们从头皮纹理中概率采样纹素,并将潜在编码z解码为256个点组成的发束。并行解码10万条发束即可得到最终发型。

DiffLocks数据集包含40,000个样本,其中包含在Blender中渲染的逼真RGB图像、完整的3D头发文件以及与头发相关的元数据。

提出的方法可以稳健地重建各种各样的发型,并且比以前的方法具有更多的细节。

无条件生成。论文使用无分类器引导训练扩散模型,以便同一模型可以同时进行有条件和无条件的评估。本文展示了无条件生成的结果,其中观察到了一系列高质量且多样化的发型。

论文提出了一种从单幅图像生成3D发束的新方法,首先创建迄今为止最大的合成头发与RGB图像配对数据集,然后提出一种基于头皮纹理的图像条件扩散模型。我们的方法可以创建高度复杂的3D发束,超越以往的方法,并且无需使用启发式方法来提高真实感。

感谢你看到这里,也欢迎点击关注下方公众号并添加公众号小助手加入官方读者交流群,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、StableDiffusion、Sora等相关技术,欢迎一起交流学习💗~